Das Backup wurde bereits genutzt und auch für den restore,

ich habe nun aber seit neuerem (genauer Zeitpunkt unbekannt)

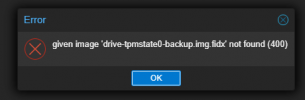

folgenden Fehler beim File restore:

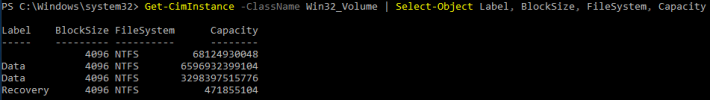

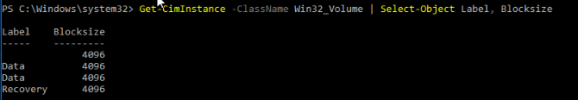

drive-scsi 1&2 sind beides identische Festplattenkonfigurationen mit NTFS

Diek 2 funktioniert einwandfrei,

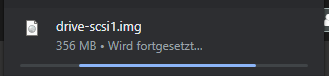

bei Disk1 erhalte ich die Fehlermeldung siehe Screenshot

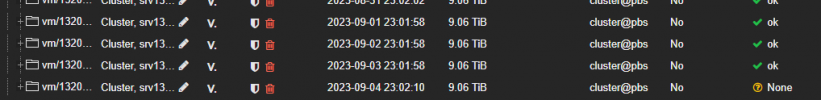

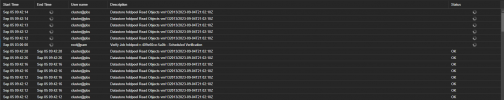

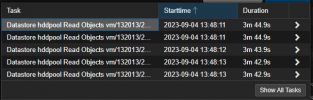

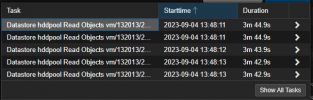

Seitens Backupserver sehen die offenen Tasks dann so aus:

ZFS gibt den pool als Grün und gut an,

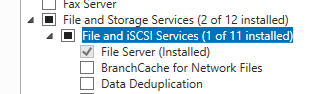

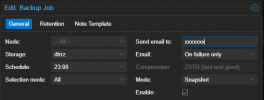

Die Serverconfig

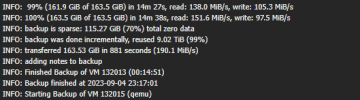

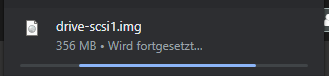

Auf dem Backupserver (3.0.2) kann ich den Download der Disk starten (nicht zu ende getestet)

ich habe nun aber seit neuerem (genauer Zeitpunkt unbekannt)

folgenden Fehler beim File restore:

drive-scsi 1&2 sind beides identische Festplattenkonfigurationen mit NTFS

Diek 2 funktioniert einwandfrei,

bei Disk1 erhalte ich die Fehlermeldung siehe Screenshot

Seitens Backupserver sehen die offenen Tasks dann so aus:

ZFS gibt den pool als Grün und gut an,

Die Serverconfig

Auf dem Backupserver (3.0.2) kann ich den Download der Disk starten (nicht zu ende getestet)