Hallo Ihr Lieben,

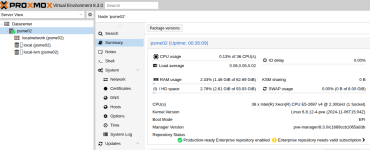

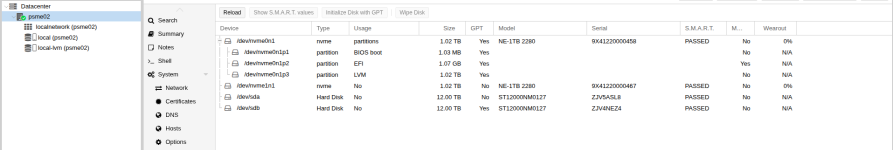

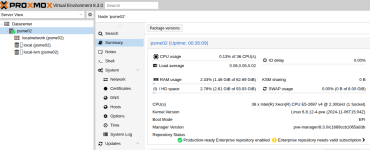

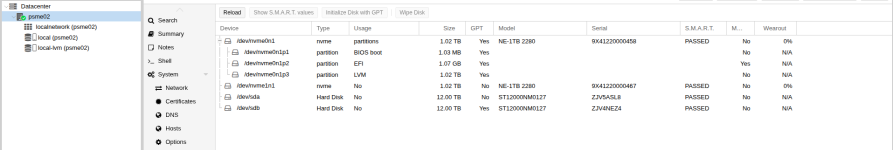

ich habe mir ein Proxmox Server installiert. Dieser Server hat 2 nvme Disk mit jeweils 1TB. Auf einer Disk ist das Hostsystem installiert. Dann habe ich noch 2 Stück 12TB SATA Festplatten die in den HotSwap Schacht stecken. Diese sollen als Data Storage dienen. Weitere 10 Schächte sind noch frei die zur Erweiterung des Storage genutzt werden soll.

Nun zu meinen UseCase. Ich möchte gerne die 2 nvme als Spiegel für das Hostsystem verwenden. Macht das überhaupt Sinn? Es ist in naher Zukunft geplant eine 2 identische Hardware einzurichten und als Cluster zu verwenden.

Das Data Storage möchte ich so verwenden das wenn 1 Festplatte defekt ist die anderen Festplatten die Daten übernehmen. Ich Denke das ich dazu ein Raid System mit einer Spare Platte einrichten muss, oder? Ggf. muss ich mir dann noch zwei 12TB SATA Festplatten kaufen, oder? Ein RAID mit Spare geht glaub ich erst mit 3 oder 4 Festplatten, oder?

Ich hoffe das ihr mich mir hier ein wenig unterstützen könnt? Wo ich mich einlesen kann?

Beigefügt zwei Bilder aus dem Datacenter. Ich verwende Proxmox in der Version 8.3.0. Was möchte ich auf den System in mehreren virtuellen Systemen in unterschiedlichen VLAN's installieren?

- Netzwerk Dienste (DHCP, DNS, Multicast Proxy, OpenVPN Server)

- Zentrale Dienste (SelfSigned CA, LDAP, Mailserver, PostgreSQL, MariaDB, Nextcloud, MediaServer, Homeassistant, CUPS, Webserver)

Lieben Gruß von Stefan Harbich

ich habe mir ein Proxmox Server installiert. Dieser Server hat 2 nvme Disk mit jeweils 1TB. Auf einer Disk ist das Hostsystem installiert. Dann habe ich noch 2 Stück 12TB SATA Festplatten die in den HotSwap Schacht stecken. Diese sollen als Data Storage dienen. Weitere 10 Schächte sind noch frei die zur Erweiterung des Storage genutzt werden soll.

Nun zu meinen UseCase. Ich möchte gerne die 2 nvme als Spiegel für das Hostsystem verwenden. Macht das überhaupt Sinn? Es ist in naher Zukunft geplant eine 2 identische Hardware einzurichten und als Cluster zu verwenden.

Das Data Storage möchte ich so verwenden das wenn 1 Festplatte defekt ist die anderen Festplatten die Daten übernehmen. Ich Denke das ich dazu ein Raid System mit einer Spare Platte einrichten muss, oder? Ggf. muss ich mir dann noch zwei 12TB SATA Festplatten kaufen, oder? Ein RAID mit Spare geht glaub ich erst mit 3 oder 4 Festplatten, oder?

Ich hoffe das ihr mich mir hier ein wenig unterstützen könnt? Wo ich mich einlesen kann?

Beigefügt zwei Bilder aus dem Datacenter. Ich verwende Proxmox in der Version 8.3.0. Was möchte ich auf den System in mehreren virtuellen Systemen in unterschiedlichen VLAN's installieren?

- Netzwerk Dienste (DHCP, DNS, Multicast Proxy, OpenVPN Server)

- Zentrale Dienste (SelfSigned CA, LDAP, Mailserver, PostgreSQL, MariaDB, Nextcloud, MediaServer, Homeassistant, CUPS, Webserver)

Lieben Gruß von Stefan Harbich

Last edited: