@ThoSo

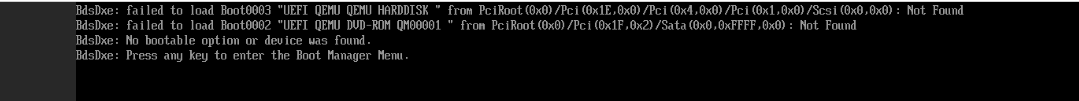

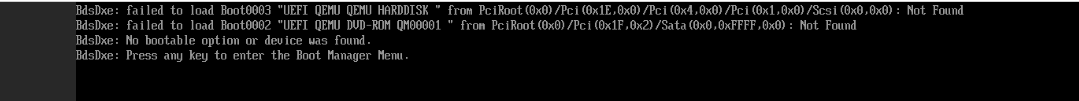

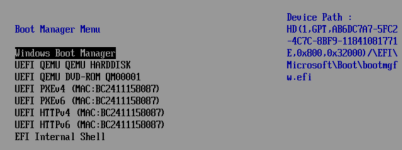

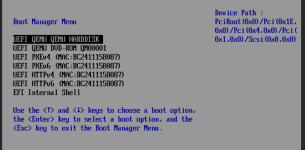

Die Backups wurden ausschließlich mit Boardmitteln über GUI und Shell versucht, leider erfolglos, der Windows Bootloader fehlt jedes mal sobald das Backup restored wurde und macht die VM und die komplette Sicherung irgendwie schwer.

Eine Reparatur des Bootloaders habe ich über das Windows CLI versucht jedoch kann Diskpart keine Disk finden.

@Impact

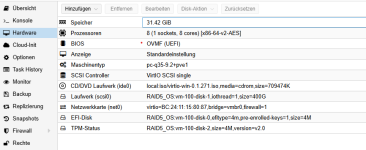

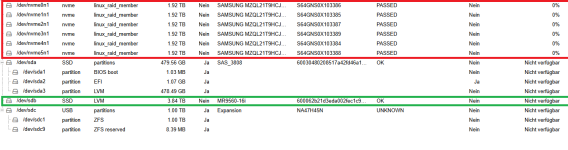

Auf deinen Vorschlag hin habe ich es erstmal mit einem ZFS Speicher für die Backups versucht aber leider komme ich auf exakt das selbe Ergebnis

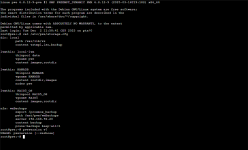

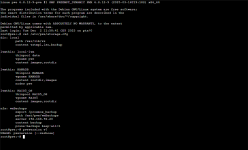

Die Storage.cfg gibt zeigt folgendes.

Die Version's angabe

Code:

root@pve:~# pveversion -v

proxmox-ve: 8.4.0 (running kernel: 6.8.12-9-pve)

pve-manager: 8.4.1 (running version: 8.4.1/2a5fa54a8503f96d)

proxmox-kernel-helper: 8.1.1

proxmox-kernel-6.8: 6.8.12-9

proxmox-kernel-6.8.12-9-pve-signed: 6.8.12-9

ceph-fuse: 17.2.8-pve2

corosync: 3.1.9-pve1

criu: 3.17.1-2+deb12u1

frr-pythontools: 10.2.2-1+pve1

glusterfs-client: 10.3-5

ifupdown2: 3.2.0-1+pmx11

ksm-control-daemon: 1.5-1

libjs-extjs: 7.0.0-5

libknet1: 1.30-pve2

libproxmox-acme-perl: 1.6.0

libproxmox-backup-qemu0: 1.5.1

libproxmox-rs-perl: 0.3.5

libpve-access-control: 8.2.2

libpve-apiclient-perl: 3.3.2

libpve-cluster-api-perl: 8.1.1

libpve-cluster-perl: 8.1.1

libpve-common-perl: 8.3.1

libpve-guest-common-perl: 5.2.2

libpve-http-server-perl: 5.2.2

libpve-network-perl: 0.11.2

libpve-rs-perl: 0.9.4

libpve-storage-perl: 8.3.6

libspice-server1: 0.15.1-1

lvm2: 2.03.16-2

lxc-pve: 6.0.0-1

lxcfs: 6.0.0-pve2

novnc-pve: 1.6.0-2

proxmox-backup-client: 3.4.2-1

proxmox-backup-file-restore: 3.4.2-1

proxmox-firewall: 0.7.1

proxmox-kernel-helper: 8.1.1

proxmox-mail-forward: 0.3.3

proxmox-mini-journalreader: 1.5

proxmox-offline-mirror-helper: 0.6.7

proxmox-widget-toolkit: 4.3.11

pve-cluster: 8.1.1

pve-container: 5.2.6

pve-docs: 8.4.0

pve-edk2-firmware: 4.2025.02-3

pve-esxi-import-tools: 0.7.4

pve-firewall: 5.1.1

pve-firmware: 3.15-4

pve-ha-manager: 4.0.7

pve-i18n: 3.4.5

pve-qemu-kvm: 9.2.0-5

pve-xtermjs: 5.5.0-2

qemu-server: 8.3.13

smartmontools: 7.3-pve1

spiceterm: 3.3.0

swtpm: 0.8.0+pve1

vncterm: 1.8.0

zfsutils-linux: 2.2.7-pve2

root@pve:~#

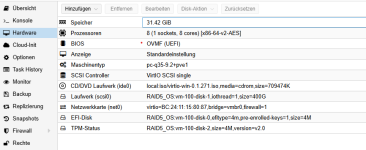

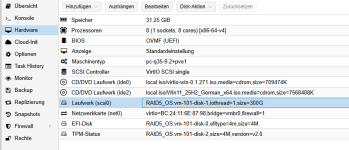

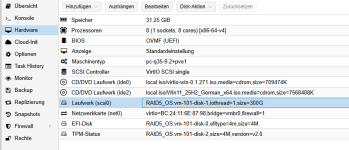

Da mir leider die Ideen ausgehen, woran das liegen kann oder was ich dagegen unternehmen könnte, habe ich die VM nochmal direkt nachdem Installieren und 5 Minuten Laufzeit gesichert, zurückgespielt und wollte dort dann eine neu Installation durchführen, jedoch geht das ebenfalls nicht.

Wieso ich das versucht habe, kann ich nur mit Verzweiflung benennen, jedoch die 300G Disk wird als 2TB erkannt nachdem ich die VirtIO treiber geladen habe und eine Installation ist ohne das Löschen der Partition wohl nicht möglich.

Das Löschen habe ich mal gelassen, da ich nicht weiß was das für eine Speicher Disk ist.

Ich werde noch mal eine VM nach den Settings die du oben gepostet hast aufsetzen und testen.

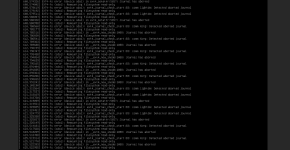

Sowohl das Migrieren von Citrix zu Proxmox als auch das Zurückspielen der Backups (die auf dem PVE erstellt wurden) scheinen alle dieses Problem zu haben. Ich teste heute Abend nochmal ein Linux und berichte euch.

Vielen Dank für eure Zeit und euer Wissen, ich bleib am Ball.

Edit: ich musste jetzt feststellen das auch Linux (Debian 12), nicht wiederhergestellt werden kann aus dem Backup...

Edit2: Eine VM zu Klonen, geht ebenfalls nicht