Hallo zusammen,

ich hoffe ich nerve hier im Forum nicht mit absoluten Anfängerfragen, hoffe aber, dass man mir vielleicht die richtigen Google-Links geben kann. Ich habe schon einiges gesucht, aber die Frage ist immer, ob die Infos noch aktuell sind und ob sie auch im produktiven Umfeld gut performen und nicht nur auf einem Einzel-Host mit wenig Anforderungen.

Aktuell setzen wir VMWare ein mit 5 ESXi Hosts und 3 TrueNas (Core und Scale) Storages. Die TrueNAS-Datasets sind aktuell per (Multipath-)NFS mit den ESXi verbunden.

Was empfiehlt sich hier? Weiter NFS, auch wenn es wenn ich das richtig sehe unter Proxmox nicht Multipath und damit nicht redundant ist? Da wir auch noch TrueNas Core einsetzen (um Multipath mit VMWare zu nutzen) können wir auf den Filern das Proxmox-Truenas-Plugin wohl nicht nutzen, oder?

Zum Netz:

Jeder der ESXi-Hosts ist mit 2 NICs mit dem Intra/Internet verbunden und mit 2 NICs mit einem abgetrennten Netz mit den Storages.

Auf dem externen Netz liegen mehrere Netzbereiche per VLAN an, im internen abgetrennten Netz liegen einzelne VLANs an, die wir für VLANs für die Kommunikation unter einigen VMs nutzen.

Im VMWare hatten wir einen virtuellen Switch für die externe Kommunikaiton und einen für die interne Kommunikation, jeweils mit den beiden 2 NICs. Auf den Virtual Switches waren dann für jedes bediente VLAN eine Virtual Machine Port Group eingerichtet, jeweils mit einer der NICs als Haupt-NIC und die andere als Failover. (Wir haben keinen Konfigurations-Zugriff auf den Switch, echtes Port Bonding ist da nicht so einfach möglich).

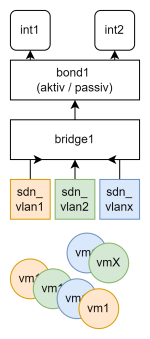

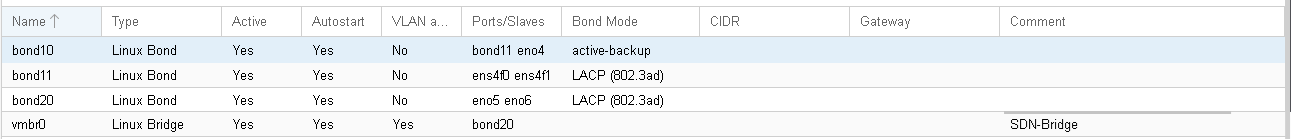

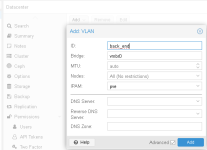

Brauche ich für eine ähnliche Konfiguration unter Proxmox die OpenvSwitches oder geht das auch mit den nativen Network-Settings?

Wie ließe sich die Einstellung "je nach VLAN mal NIC 1 und mal NIC2, aber jeweils die andere NIC als Fail-Over" realisieren?

Vielen Dank vorab schon einmal für die Denkanstöße....

Viele Grüße

Philipp

ich hoffe ich nerve hier im Forum nicht mit absoluten Anfängerfragen, hoffe aber, dass man mir vielleicht die richtigen Google-Links geben kann. Ich habe schon einiges gesucht, aber die Frage ist immer, ob die Infos noch aktuell sind und ob sie auch im produktiven Umfeld gut performen und nicht nur auf einem Einzel-Host mit wenig Anforderungen.

Aktuell setzen wir VMWare ein mit 5 ESXi Hosts und 3 TrueNas (Core und Scale) Storages. Die TrueNAS-Datasets sind aktuell per (Multipath-)NFS mit den ESXi verbunden.

Was empfiehlt sich hier? Weiter NFS, auch wenn es wenn ich das richtig sehe unter Proxmox nicht Multipath und damit nicht redundant ist? Da wir auch noch TrueNas Core einsetzen (um Multipath mit VMWare zu nutzen) können wir auf den Filern das Proxmox-Truenas-Plugin wohl nicht nutzen, oder?

Zum Netz:

Jeder der ESXi-Hosts ist mit 2 NICs mit dem Intra/Internet verbunden und mit 2 NICs mit einem abgetrennten Netz mit den Storages.

Auf dem externen Netz liegen mehrere Netzbereiche per VLAN an, im internen abgetrennten Netz liegen einzelne VLANs an, die wir für VLANs für die Kommunikation unter einigen VMs nutzen.

Im VMWare hatten wir einen virtuellen Switch für die externe Kommunikaiton und einen für die interne Kommunikation, jeweils mit den beiden 2 NICs. Auf den Virtual Switches waren dann für jedes bediente VLAN eine Virtual Machine Port Group eingerichtet, jeweils mit einer der NICs als Haupt-NIC und die andere als Failover. (Wir haben keinen Konfigurations-Zugriff auf den Switch, echtes Port Bonding ist da nicht so einfach möglich).

Brauche ich für eine ähnliche Konfiguration unter Proxmox die OpenvSwitches oder geht das auch mit den nativen Network-Settings?

Wie ließe sich die Einstellung "je nach VLAN mal NIC 1 und mal NIC2, aber jeweils die andere NIC als Fail-Over" realisieren?

Vielen Dank vorab schon einmal für die Denkanstöße....

Viele Grüße

Philipp