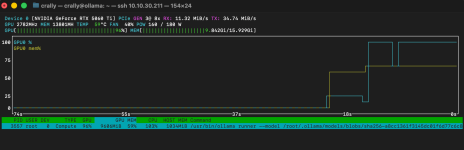

ok... also die GPU ist drin und wird auch vom OS erkannt. Das pci Passthrough klappt noch nicht ganz, aber ich hab ein anderes Problem, welches ich zuerst lösen muss...

Nach Einbau der GPU brauchte der Server 3-5 Anläufe um zu booten. Hatte in der Zeit natürlich keinen Monitor dran.

Dann fuhr alles hoch und ich konnte auch Proxmox über den Browser öffnen.

ABER: Die integrierten NIC's des Servers tauchen nicht mehr auf (eno1 und eno2).... In Proxmox werden sie als inaktiv angezeigt und ein "ip link show" zeigt die entsprechenden MAC Adressen gar nicht mehr an....

Die LED an den NIC's leuchten fleißig

Somit ist mein gesamtes Management-VLAN gerade nicht online (außer die virtuellen Maschinen).

Hat da einer eine Idee? Die pcie-4-Fach NIC Karte funktioniert, weshalb ich auch noch zugriff auf proxmox hab, aber nicht auf das irmc.

Werde vielleicht heute Abend oder morgen früh mal direkt Point-to-point an die Schnittstelle um zu schauen ob das irmc reagiert

Edit: Also direkt an den Management-Port vom Server komm ich. Dort werden mir auch die zwei anderen NIC's angezeigt. Warum werden die vom OS nicht mehr erkannt?

Edit:

- unnötige Bilder gelöscht

Es lichtet sich etwas:

Fehlermeldung: "Cannot map registers, bar size 0x0 too small, aborting"

Jetzt habe ich etwas davon gelesen, dass man im BIOS "Above 4G Decoding" aktivieren soll. Die Option dafür habe ich beim letzten mal im BIOS gesehen und bin mir sicher, dass das deaktiviert war. Genauso war "SR-IOV Support" deaktiviert.

Scheinbar verteilte der Kernel nach Einbau der GPU die PCIe-Ressourcen neu. Das würde auch die mehrfachen Neustarts erklären.

Ich werde morgen früh mal die beiden Funktionen im BIOS aktivieren und schauen, ob es danach läuft.

Außerdem kann ich im BIOS noch "Option ROM Execution" für die einzelnen PCIe Slots aktivieren. Brauch ich das?

Seht ihr das auch so? Danke schonmal

Nach Einbau der GPU brauchte der Server 3-5 Anläufe um zu booten. Hatte in der Zeit natürlich keinen Monitor dran.

Dann fuhr alles hoch und ich konnte auch Proxmox über den Browser öffnen.

ABER: Die integrierten NIC's des Servers tauchen nicht mehr auf (eno1 und eno2).... In Proxmox werden sie als inaktiv angezeigt und ein "ip link show" zeigt die entsprechenden MAC Adressen gar nicht mehr an....

Die LED an den NIC's leuchten fleißig

Somit ist mein gesamtes Management-VLAN gerade nicht online (außer die virtuellen Maschinen).

Hat da einer eine Idee? Die pcie-4-Fach NIC Karte funktioniert, weshalb ich auch noch zugriff auf proxmox hab, aber nicht auf das irmc.

Werde vielleicht heute Abend oder morgen früh mal direkt Point-to-point an die Schnittstelle um zu schauen ob das irmc reagiert

Edit: Also direkt an den Management-Port vom Server komm ich. Dort werden mir auch die zwei anderen NIC's angezeigt. Warum werden die vom OS nicht mehr erkannt?

Edit:

- unnötige Bilder gelöscht

Es lichtet sich etwas:

Code:

root@pve:~# lspci -nn | grep -i net

68:00.0 Ethernet controller [0200]: Intel Corporation Ethernet Connection X722 [8086:37cc] (rev 09)

68:00.2 Ethernet controller [0200]: Intel Corporation Ethernet Connection X722 for 1GbE [8086:37d1] (rev 09)

68:00.3 Ethernet controller [0200]: Intel Corporation Ethernet Connection X722 for 1GbE [8086:37d1] (rev 09)

b3:00.0 Ethernet controller [0200]: Intel Corporation 82580 Gigabit Network Connection [8086:150e] (rev 01)

b3:00.1 Ethernet controller [0200]: Intel Corporation 82580 Gigabit Network Connection [8086:150e] (rev 01)

b3:00.2 Ethernet controller [0200]: Intel Corporation 82580 Gigabit Network Connection [8086:150e] (rev 01)

b3:00.3 Ethernet controller [0200]: Intel Corporation 82580 Gigabit Network Connection [8086:150e] (rev 01)

root@pve:~# dmesg | grep -i i40e

[ 2.088366] i40e: Intel(R) Ethernet Connection XL710 Network Driver

[ 2.088377] i40e: Copyright (c) 2013 - 2019 Intel Corporation.

[ 2.088551] i40e 0000:68:00.2: Cannot map registers, bar size 0x0 too small, aborting

[ 2.088608] i40e: probe of 0000:68:00.2 failed with error -12

[ 2.088667] i40e 0000:68:00.3: Cannot map registers, bar size 0x0 too small, aborting

[ 2.088712] i40e: probe of 0000:68:00.3 failed with error -12Fehlermeldung: "Cannot map registers, bar size 0x0 too small, aborting"

Jetzt habe ich etwas davon gelesen, dass man im BIOS "Above 4G Decoding" aktivieren soll. Die Option dafür habe ich beim letzten mal im BIOS gesehen und bin mir sicher, dass das deaktiviert war. Genauso war "SR-IOV Support" deaktiviert.

Scheinbar verteilte der Kernel nach Einbau der GPU die PCIe-Ressourcen neu. Das würde auch die mehrfachen Neustarts erklären.

Ich werde morgen früh mal die beiden Funktionen im BIOS aktivieren und schauen, ob es danach läuft.

Außerdem kann ich im BIOS noch "Option ROM Execution" für die einzelnen PCIe Slots aktivieren. Brauch ich das?

Seht ihr das auch so? Danke schonmal

Attachments

Last edited: