Hallo zusammen,

bin schon länger aus dem Hardwaredschungel raus und wäre dankbar über Einschätzungen, Beratung und Tips.

Ich plane evtl. meinen Server zu ersetzen. Dazu erstmal derzeitige Randdaten und Nutzungsverhalten:

Fujitsu Primergy TX2450 M1:

Genutzte Software:

Dockge-master ist meine Docker VM. Hier ist vor allem Frigate als NVR Ressourcen-hungrig, da leider noch 2 von 4 Kameras nur einen MJPEG-Stream ausgeben und entsprechend go2rtc die dekodierung über die CPU managen muss. Hier ist der Xeon nicht ideal. Die PCIe Coral TPU ist direkt an die VM und den Docker Container durchgereicht und übernimmt die Objekterkennung auch zuverlässig und problemlos.

Nextcloud ist nur für den Heimgebrauch, aber über Reverse-Proxy schon öffentlich erreichbar. Hier braucht es aber nicht viel Leistung, da eher als CalDAV-Server und automatisches Photo-Backup der iPhones genutzt.

Home Assistant ist natürlich fundamentaler Bestandteil der heimischen Lebensqualität und "wächst" stetig. Hier soll der neue Server künftig auch nach Möglichkeit die lokale Voice Agent Funktion mit KI übernehmen, da ich keinen externen Dienstleister Zugriff auf mein SmartHome geben möchte.

ioBroker dient nur als "Brücke" zu HomeAssistant für von HomeAssistant nicht unterstützte Dienste/Protokolle

OpenMediaVault ist dann entsprechend meine NAS, an derer die beiden PCIe P3520 Platten direkt weitergereicht sind.

Windows wird nur bei Bedarf gestartet und ist dann zwar nicht wirklich flüssig bedienbar aber auch nicht furchtbar...

Nun ist mein Server schon etwas in die Jahre gekommen, auch wenn er im Grunde zuverlässig läuft. Vor allem saugt sich Frigate hier die meiste Leistung und belastet die CPU enorm. Eine zusätzliche GPU zur Entlastung ist mangels fehlender PCIe-Slots nicht möglich. Hier könnte ich lediglich eine zweite CPU einbauen um einen weiteren PCIe Slot zu haben, aber auch wenn es günstig zu erwerben wäre halt ich es irgendwie nicht für sinnvoll hier noch Geld reinzustecken.

Zudem möchte ich künftig meinem Home Assistant ein bisschen KI Funktionalität bieten mit selbst gehortetem KI-Modell (Klar, wird es nur ein kleines Modell werden können evtl. mithilfe einer Nvidia 3060 12GB über PCIe x16).

Die Festplatten sind leider auch nicht die schnellsten, was man schon merkt, da ich vor allem durch das Schreiben von logs extrem hohes IOPS Aufkommen hab.

Der Server verbraucht derzeit unter normaler Nutzung wie dargelegt ca. 90W. In dem Rahmen möchte ich nach Möglichkeit auch bleiben, tendenziell eher weniger (ohne GPU). Mir ist aber natürlich bewusst, dass eine GPU bei Nutzung das ganze zeitweise deutlich sprengen würde.

Das Budget für ein neues Setup sollte 1000€ nicht überschreiten, gerne auch gebrauchte Hardware.

Ziele:

- min. 96GB ECC Speicher ist für mich essentiell!

- Neue Boot-Laufwerke, z.B. 2x M.2 Firecuda 530 (ohne R) im ZFS-Mirror für Host und VM OS's

- PCIe x16 Graka für eine LLM VM

- Evtl. dedizierte Graka (z.B. GT 1030) oder iGPU von der neuen CPU für Frigate

- Weiterverwendung meine Intel P3520 U.2 Platten (u.U. auch wieder mittels PCIe Adapter)

- Weiterverwendung meiner Quad NIC-Karte

- M.2 Coral TPU muss auch wieder rein, kann aber auch auf USB umgerüstet werden

- Versuchen den Stromverbrauch zu senken, bzw. wenigstens nicht zu erhöhen

- Lautstärke nicht so wichtig

- Tower Design (kein Rack)

Gedanken und Probleme:

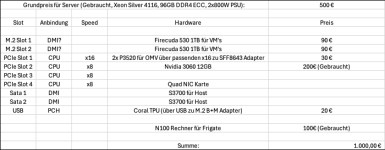

- Server Boards und CPU haben meist gute Ausstattung an PCIe Lanes und Anschlüssen, sowie redundante Netzteile und min. Quad-Channel Support. Gebraucht gute Sets zu finden (z.B. Intel Silver 4116 mit 96GB ECC und 800W Platinum NT für rund 500€)

- Consumer Hardware meist gebraucht günstiger, moderner, aber DDR5 ECC ist einfach viel zu teuer -> DDR4 ECC gebraucht gut bezahlbar, aber dann weniger Vorteil zur Server-Hardware

- Consumer Hardware hat meist weniger Lanes, vor Allem die Generationen mit DDR4 ECC Support

- Consumer Hardware ohne redundantes Netzteil (Wäre verkraftbar, Aktuelle Backup-Strategie funktioniert gut, allerdings

- Server Hardware meist stromhungriger als Consumer-HW

- Server Hardware hat proprietäres Design (evtl. werden PCIe-Slots von Grafikkarte überdeckt und unbrauchbar, außer durch Riser Kabel)

Da ich mit meinem Fujitsu Server eigtl. immer zufrieden war, habe ich auf dem Gebrauchtmarkt mal nach einem moderneren Äquivalent gesucht. Dort bekommt man TX2550 M4 relativ günstig. Man findet allerdings sehr wenig Infos darüber, ob das Board Bifurcation unterstützt. Immerhin gibt es einige PCIe Geräte unterzubringen:

- 2x NAS HDD (P3520 U.2) (PCIe x1 Adapter schon vorhanden, evtl. Umstieg auf SFF-8643 zu M.2 Adapter für 25€ je Adapter)

- GPU für Llama (zwar nur ein x16 PCIe Slot belegt, aber Kühler verdeckt evtl. nebenliegende Ports -> evtl. Riser Kabel für weitere Geräte nötig (20-30€)

- GPU für Frigate (praktisch reicht elektr. ein x1 Slot; Entfällt bei CPU mit iGPU)

- Quad-NIC Karte

- Coral TPU (aber für 20€ umrüstbar auf USB)

- Evtl. M.2 Riser Card für 2x Boot-NVME's (Wenn Bifurcation nicht verfügbar, dann Adapter mit mind. ASM2812 Chip für ca. 100€ nötig)

Alternativ können natürlich auch die P3520 Platten als Boot-Laufwerke genutzt werden und ich hol mir einfach Sata-Platten für die NAS. Hier kann ich den Performance-Unterschied schwer einschätzen, da die P3520 ja noch über PCIe 3.0 laufen und moderne M.2 NVME's mit PCIe 4.0 x4 laufen.

SATA-Platten habe ich theoretisch für lau, neue M.2 NVME's müsste ich halt kaufen (ca. 200€ für 2x 1TB)

Zudem laufen auch bei Server-Hardware die M.2 Anschlüsse meist über DMI-Anbindung. Boot-Laufwerke direkt über CPU-Anbindung natürlich schöner, daher so oder so eine Riser-Card sinnvoll und die NAS-Laufwerke über die M.2 Slots anschließen?

Ich hoffe mein Gedankengang ist nachvollziehbar beschrieben und ich freue mich auf Reaktionen. Wichtig ist, dass das Teil zuverlässig läuft, weshalb ich aktuell eher wieder zur gebrauchten Server-Hardware tendiere. Das sollte man für knappe 1000€ hinbekommen mit allen notwendigen Adaptern und Neuanschaffungen...

Aber bin gerne für Ratschläge offen.

bin schon länger aus dem Hardwaredschungel raus und wäre dankbar über Einschätzungen, Beratung und Tips.

Ich plane evtl. meinen Server zu ersetzen. Dazu erstmal derzeitige Randdaten und Nutzungsverhalten:

Fujitsu Primergy TX2450 M1:

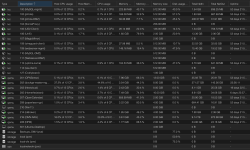

- 1x Xeon 2430L V2

- D3099-B12 Mainboard LGA1356

- 96GB DDR3 ECC RAM

- 2x 400GB Intel S3700 SSD im ZFS (ZRAID1) für Proxmox und VM's/CT's

- 2x 1,92TB Intel SSD DC P3520 U.2, PCIe 3.0 x4 - Über PCIe Adapter man zwei x4 Slots angeschlossen und direkt an OMV VM weitergereicht für NAS im Software RAID 1

- 1x 4-Port 1Gbit Netzwerkkarte

- 1x PCIe Coral TPU für Frigate

- 1x USB an APC USV

- 1x USB Zigbee Adapter

- 1x USB SATA HDD für Backups

Genutzte Software:

- 9 -11 VM's

- 8 -12 CT's

Dockge-master ist meine Docker VM. Hier ist vor allem Frigate als NVR Ressourcen-hungrig, da leider noch 2 von 4 Kameras nur einen MJPEG-Stream ausgeben und entsprechend go2rtc die dekodierung über die CPU managen muss. Hier ist der Xeon nicht ideal. Die PCIe Coral TPU ist direkt an die VM und den Docker Container durchgereicht und übernimmt die Objekterkennung auch zuverlässig und problemlos.

Nextcloud ist nur für den Heimgebrauch, aber über Reverse-Proxy schon öffentlich erreichbar. Hier braucht es aber nicht viel Leistung, da eher als CalDAV-Server und automatisches Photo-Backup der iPhones genutzt.

Home Assistant ist natürlich fundamentaler Bestandteil der heimischen Lebensqualität und "wächst" stetig. Hier soll der neue Server künftig auch nach Möglichkeit die lokale Voice Agent Funktion mit KI übernehmen, da ich keinen externen Dienstleister Zugriff auf mein SmartHome geben möchte.

ioBroker dient nur als "Brücke" zu HomeAssistant für von HomeAssistant nicht unterstützte Dienste/Protokolle

OpenMediaVault ist dann entsprechend meine NAS, an derer die beiden PCIe P3520 Platten direkt weitergereicht sind.

Windows wird nur bei Bedarf gestartet und ist dann zwar nicht wirklich flüssig bedienbar aber auch nicht furchtbar...

Nun ist mein Server schon etwas in die Jahre gekommen, auch wenn er im Grunde zuverlässig läuft. Vor allem saugt sich Frigate hier die meiste Leistung und belastet die CPU enorm. Eine zusätzliche GPU zur Entlastung ist mangels fehlender PCIe-Slots nicht möglich. Hier könnte ich lediglich eine zweite CPU einbauen um einen weiteren PCIe Slot zu haben, aber auch wenn es günstig zu erwerben wäre halt ich es irgendwie nicht für sinnvoll hier noch Geld reinzustecken.

Zudem möchte ich künftig meinem Home Assistant ein bisschen KI Funktionalität bieten mit selbst gehortetem KI-Modell (Klar, wird es nur ein kleines Modell werden können evtl. mithilfe einer Nvidia 3060 12GB über PCIe x16).

Die Festplatten sind leider auch nicht die schnellsten, was man schon merkt, da ich vor allem durch das Schreiben von logs extrem hohes IOPS Aufkommen hab.

Der Server verbraucht derzeit unter normaler Nutzung wie dargelegt ca. 90W. In dem Rahmen möchte ich nach Möglichkeit auch bleiben, tendenziell eher weniger (ohne GPU). Mir ist aber natürlich bewusst, dass eine GPU bei Nutzung das ganze zeitweise deutlich sprengen würde.

Das Budget für ein neues Setup sollte 1000€ nicht überschreiten, gerne auch gebrauchte Hardware.

Ziele:

- min. 96GB ECC Speicher ist für mich essentiell!

- Neue Boot-Laufwerke, z.B. 2x M.2 Firecuda 530 (ohne R) im ZFS-Mirror für Host und VM OS's

- PCIe x16 Graka für eine LLM VM

- Evtl. dedizierte Graka (z.B. GT 1030) oder iGPU von der neuen CPU für Frigate

- Weiterverwendung meine Intel P3520 U.2 Platten (u.U. auch wieder mittels PCIe Adapter)

- Weiterverwendung meiner Quad NIC-Karte

- M.2 Coral TPU muss auch wieder rein, kann aber auch auf USB umgerüstet werden

- Versuchen den Stromverbrauch zu senken, bzw. wenigstens nicht zu erhöhen

- Lautstärke nicht so wichtig

- Tower Design (kein Rack)

Gedanken und Probleme:

- Server Boards und CPU haben meist gute Ausstattung an PCIe Lanes und Anschlüssen, sowie redundante Netzteile und min. Quad-Channel Support. Gebraucht gute Sets zu finden (z.B. Intel Silver 4116 mit 96GB ECC und 800W Platinum NT für rund 500€)

- Consumer Hardware meist gebraucht günstiger, moderner, aber DDR5 ECC ist einfach viel zu teuer -> DDR4 ECC gebraucht gut bezahlbar, aber dann weniger Vorteil zur Server-Hardware

- Consumer Hardware hat meist weniger Lanes, vor Allem die Generationen mit DDR4 ECC Support

- Consumer Hardware ohne redundantes Netzteil (Wäre verkraftbar, Aktuelle Backup-Strategie funktioniert gut, allerdings

- Server Hardware meist stromhungriger als Consumer-HW

- Server Hardware hat proprietäres Design (evtl. werden PCIe-Slots von Grafikkarte überdeckt und unbrauchbar, außer durch Riser Kabel)

Da ich mit meinem Fujitsu Server eigtl. immer zufrieden war, habe ich auf dem Gebrauchtmarkt mal nach einem moderneren Äquivalent gesucht. Dort bekommt man TX2550 M4 relativ günstig. Man findet allerdings sehr wenig Infos darüber, ob das Board Bifurcation unterstützt. Immerhin gibt es einige PCIe Geräte unterzubringen:

- 2x NAS HDD (P3520 U.2) (PCIe x1 Adapter schon vorhanden, evtl. Umstieg auf SFF-8643 zu M.2 Adapter für 25€ je Adapter)

- GPU für Llama (zwar nur ein x16 PCIe Slot belegt, aber Kühler verdeckt evtl. nebenliegende Ports -> evtl. Riser Kabel für weitere Geräte nötig (20-30€)

- GPU für Frigate (praktisch reicht elektr. ein x1 Slot; Entfällt bei CPU mit iGPU)

- Quad-NIC Karte

- Coral TPU (aber für 20€ umrüstbar auf USB)

- Evtl. M.2 Riser Card für 2x Boot-NVME's (Wenn Bifurcation nicht verfügbar, dann Adapter mit mind. ASM2812 Chip für ca. 100€ nötig)

Alternativ können natürlich auch die P3520 Platten als Boot-Laufwerke genutzt werden und ich hol mir einfach Sata-Platten für die NAS. Hier kann ich den Performance-Unterschied schwer einschätzen, da die P3520 ja noch über PCIe 3.0 laufen und moderne M.2 NVME's mit PCIe 4.0 x4 laufen.

SATA-Platten habe ich theoretisch für lau, neue M.2 NVME's müsste ich halt kaufen (ca. 200€ für 2x 1TB)

Zudem laufen auch bei Server-Hardware die M.2 Anschlüsse meist über DMI-Anbindung. Boot-Laufwerke direkt über CPU-Anbindung natürlich schöner, daher so oder so eine Riser-Card sinnvoll und die NAS-Laufwerke über die M.2 Slots anschließen?

Ich hoffe mein Gedankengang ist nachvollziehbar beschrieben und ich freue mich auf Reaktionen. Wichtig ist, dass das Teil zuverlässig läuft, weshalb ich aktuell eher wieder zur gebrauchten Server-Hardware tendiere. Das sollte man für knappe 1000€ hinbekommen mit allen notwendigen Adaptern und Neuanschaffungen...

Aber bin gerne für Ratschläge offen.