Hallo zusammen,

absoluter Newbie was Proxmox angeht. Folgende Ausgangslage: Ich habe mir Proxmox eingerichtet, v.a. um Paperless zu nutzen. In meinem Fujitsu Q556/2 habe ich eine 1TB NVME eingebaut, darauf Proxmox installiert und eine interne SSD mit 128 GB habe ich als ZFS angelegt (alles stumpf nach Anleitung ohne verstanden zu haben, wie ZFS funktioniert). Paperless mit Docker habe ich ebenfalls nach Anleitung angelegt, hat auch alles mehr oder weniger gut geklappt, irgendwann lief es wie es sollte.

Nun kam ich auf die glorreiche Idee, zwei externe Platten zum ZFS-Pool hinzuzufügen mit dem Gedanken, je mehr Redundanz desto besser. Im laufenden Betrieb konnte ich die ZFS nicht ändern, also über die Proxmox GUI meinen Knoten Rechenzentrum--> "proxmox"-->Disks-->ZFS-->Pool "ZFS-Pool" entfernen das aktuelle ZFS (die SSD mit 128GB) gelöscht. Meine Vorstellung war, dass die tatsächlichen Daten eh auf der NVME liegen und die ZFS ja nur für das Mirroring zuständig ist. Also sollte man das ja problemlos löschen können und anschließend einen neuen ZFS-Pool inkl der externen Platten anlegen können.

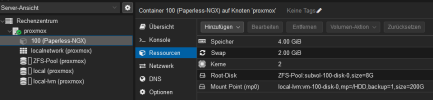

Langer Rede kurzer Sinn: Starten kann ich den Paperless-Knoten jetzt nicht mehr: "TASK ERROR: storage 'ZFS-Pool' does not exist". Ich hoffe einfach nur, dass die Daten noch auf der NVME vorhanden sind. Das erneute Anlegen des ZFS-Pools funktioniert, aber das Starten des Knotens nicht "TASK ERROR: zfs error: cannot open 'ZFS-Pool/subvol-100-disk-0': dataset does not exist".

Proxmox könnte ich neu aufsetzen, aber die Paperless-Daten würde ich gerne sichern, wenn sie überhaupt noch existieren... Was kann ich tun?

absoluter Newbie was Proxmox angeht. Folgende Ausgangslage: Ich habe mir Proxmox eingerichtet, v.a. um Paperless zu nutzen. In meinem Fujitsu Q556/2 habe ich eine 1TB NVME eingebaut, darauf Proxmox installiert und eine interne SSD mit 128 GB habe ich als ZFS angelegt (alles stumpf nach Anleitung ohne verstanden zu haben, wie ZFS funktioniert). Paperless mit Docker habe ich ebenfalls nach Anleitung angelegt, hat auch alles mehr oder weniger gut geklappt, irgendwann lief es wie es sollte.

Nun kam ich auf die glorreiche Idee, zwei externe Platten zum ZFS-Pool hinzuzufügen mit dem Gedanken, je mehr Redundanz desto besser. Im laufenden Betrieb konnte ich die ZFS nicht ändern, also über die Proxmox GUI meinen Knoten Rechenzentrum--> "proxmox"-->Disks-->ZFS-->Pool "ZFS-Pool" entfernen das aktuelle ZFS (die SSD mit 128GB) gelöscht. Meine Vorstellung war, dass die tatsächlichen Daten eh auf der NVME liegen und die ZFS ja nur für das Mirroring zuständig ist. Also sollte man das ja problemlos löschen können und anschließend einen neuen ZFS-Pool inkl der externen Platten anlegen können.

Langer Rede kurzer Sinn: Starten kann ich den Paperless-Knoten jetzt nicht mehr: "TASK ERROR: storage 'ZFS-Pool' does not exist". Ich hoffe einfach nur, dass die Daten noch auf der NVME vorhanden sind. Das erneute Anlegen des ZFS-Pools funktioniert, aber das Starten des Knotens nicht "TASK ERROR: zfs error: cannot open 'ZFS-Pool/subvol-100-disk-0': dataset does not exist".

Proxmox könnte ich neu aufsetzen, aber die Paperless-Daten würde ich gerne sichern, wenn sie überhaupt noch existieren... Was kann ich tun?