Hallo zusammen,

wir haben uns eine Testumgebung mit drei HPE ProLiant Gen 10 mit der oben genannten Proxmox-Version aufgebaut,

um zu Testen, wie performant CAD (AutoCAD) und GIS-Anwendungen auf dieser Plattform laufen.

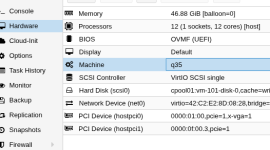

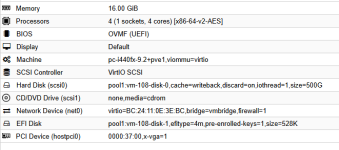

Jetzt haben wir in jede der Nodes eine Tesla T4 eingebaut und diese soll per Passthrough an die VMs durchgereicht werden.

Leider haben wir bisher keine vollständige Anleitung zur Einrichtung der Karten gefunden und nur die ersten Schritte durchgeführt:

1. Anpassen der /etc/default/grub

2. Identifizieren der GPU

3. Anlegen der VFIO-Konfig

Und an der Stelle müsste wahrscheinlich noch ein Treiber installiert werden? Aber welcher?

Könnt ihr uns hier die fehlenden Schritte und eventuell einen passenden Treiber nennen.

Vielen Dank im Voraus.

Gruß tg6300

wir haben uns eine Testumgebung mit drei HPE ProLiant Gen 10 mit der oben genannten Proxmox-Version aufgebaut,

um zu Testen, wie performant CAD (AutoCAD) und GIS-Anwendungen auf dieser Plattform laufen.

Jetzt haben wir in jede der Nodes eine Tesla T4 eingebaut und diese soll per Passthrough an die VMs durchgereicht werden.

Leider haben wir bisher keine vollständige Anleitung zur Einrichtung der Karten gefunden und nur die ersten Schritte durchgeführt:

1. Anpassen der /etc/default/grub

2. Identifizieren der GPU

3. Anlegen der VFIO-Konfig

Und an der Stelle müsste wahrscheinlich noch ein Treiber installiert werden? Aber welcher?

Könnt ihr uns hier die fehlenden Schritte und eventuell einen passenden Treiber nennen.

Vielen Dank im Voraus.

Gruß tg6300

Last edited: