Hallo zusammen,

ich bin gerade dabei meinen lokalen Backup Server auf einen zweiten, externen (bei Hetzner gehosteten) Backup Server zu synchen.

Dies funktioniert soweit auch - jedoch leider nur äußerst langsam mit nur ca. 2 bis 3 MB/s.

Zum Setup:

Lokal:

"PVE01" mit "PBS01" lokal am Host als VM virtualisiert.

Datastore liegt ebenfalls lokal am Host.

ISP-Bandbreite: 100Mbit/s Down & 100Mbit/s up

Hetzner:

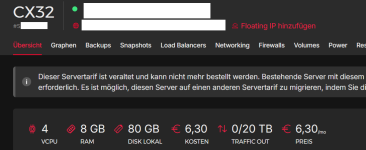

"PBS03" als Cloud-Server gehosted mit einem S3 Object Storage als Datastore.

Folgende Benchmarks habe ich bereits ausgeführt:

Benchmark direkt am "Cloud" Backup Server:

Benchmark vom lokalen PVE host zum Cloud Server:

Hier sieht man, dass der Upload Speed bei nur 2.46 MB/s liegt?!

Hier auch noch ein iperf3 Speedtest zu Hetzner:

Hat jemand eine Idee wo hier der Flaschenhals liegen könnte?

Gibt es noch andere Möglichkeiten um diesen geringen Upload-Speed besser nachvollziehen/einschränken zu können?

Vielen Dank für eure Unterstützung!

ich bin gerade dabei meinen lokalen Backup Server auf einen zweiten, externen (bei Hetzner gehosteten) Backup Server zu synchen.

Dies funktioniert soweit auch - jedoch leider nur äußerst langsam mit nur ca. 2 bis 3 MB/s.

Zum Setup:

Lokal:

"PVE01" mit "PBS01" lokal am Host als VM virtualisiert.

Datastore liegt ebenfalls lokal am Host.

ISP-Bandbreite: 100Mbit/s Down & 100Mbit/s up

Hetzner:

"PBS03" als Cloud-Server gehosted mit einem S3 Object Storage als Datastore.

Folgende Benchmarks habe ich bereits ausgeführt:

Benchmark direkt am "Cloud" Backup Server:

Code:

root@pbs03:~# proxmox-backup-client benchmark --repository PBS03-s3-datastore

Uploaded 247 chunks in 5 seconds.

Time per request: 20786 microseconds.

TLS speed: 201.78 MB/s

SHA256 speed: 330.93 MB/s

Compression speed: 256.66 MB/s

Decompress speed: 383.03 MB/s

AES256/GCM speed: 2199.89 MB/s

Verify speed: 162.02 MB/s

┌───────────────────────────────────┬────────────────────┐

│ Name │ Value │

╞═══════════════════════════════════╪════════════════════╡

│ TLS (maximal backup upload speed) │ 201.78 MB/s (16%) │

├───────────────────────────────────┼────────────────────┤

│ SHA256 checksum computation speed │ 330.93 MB/s (16%) │

├───────────────────────────────────┼────────────────────┤

│ ZStd level 1 compression speed │ 256.66 MB/s (34%) │

├───────────────────────────────────┼────────────────────┤

│ ZStd level 1 decompression speed │ 383.03 MB/s (32%) │

├───────────────────────────────────┼────────────────────┤

│ Chunk verification speed │ 162.02 MB/s (21%) │

├───────────────────────────────────┼────────────────────┤

│ AES256 GCM encryption speed │ 2199.89 MB/s (60%) │

└───────────────────────────────────┴────────────────────┘Benchmark vom lokalen PVE host zum Cloud Server:

Code:

root@pve01:~# proxmox-backup-client benchmark --repository <IP>:8007:PBS03-s3-datastore

Password for "root@pam": ********************

Uploaded 104 chunks in 177 seconds.

Time per request: 1702951 microseconds.

TLS speed: 2.46 MB/s

SHA256 speed: 458.28 MB/s

Compression speed: 449.95 MB/s

Decompress speed: 698.43 MB/s

AES256/GCM speed: 2425.54 MB/s

Verify speed: 277.14 MB/s

┌───────────────────────────────────┬────────────────────┐

│ Name │ Value │

╞═══════════════════════════════════╪════════════════════╡

│ TLS (maximal backup upload speed) │ 2.46 MB/s (0%) │

├───────────────────────────────────┼────────────────────┤

│ SHA256 checksum computation speed │ 458.28 MB/s (23%) │

├───────────────────────────────────┼────────────────────┤

│ ZStd level 1 compression speed │ 449.95 MB/s (60%) │

├───────────────────────────────────┼────────────────────┤

│ ZStd level 1 decompression speed │ 698.43 MB/s (58%) │

├───────────────────────────────────┼────────────────────┤

│ Chunk verification speed │ 277.14 MB/s (37%) │

├───────────────────────────────────┼────────────────────┤

│ AES256 GCM encryption speed │ 2425.54 MB/s (67%) │

└───────────────────────────────────┴────────────────────┘Hier sieht man, dass der Upload Speed bei nur 2.46 MB/s liegt?!

Hier auch noch ein iperf3 Speedtest zu Hetzner:

Code:

root@pve01:~# iperf3 -c <IP>

Connecting to host <IP>, port 5201

[ 5] local 10.1.4.20 port 55262 connected to <IP> port 5201

[ ID] Interval Transfer Bitrate Retr Cwnd

[ 5] 0.00-1.00 sec 12.2 MBytes 102 Mbits/sec 5 229 KBytes

[ 5] 1.00-2.00 sec 11.1 MBytes 92.8 Mbits/sec 0 264 KBytes

[ 5] 2.00-3.00 sec 11.2 MBytes 93.8 Mbits/sec 0 296 KBytes

[ 5] 3.00-4.00 sec 11.1 MBytes 93.3 Mbits/sec 4 246 KBytes

[ 5] 4.00-5.00 sec 11.9 MBytes 100 Mbits/sec 0 274 KBytes

[ 5] 5.00-6.00 sec 10.3 MBytes 86.5 Mbits/sec 5 211 KBytes

[ 5] 6.00-7.00 sec 11.3 MBytes 94.9 Mbits/sec 0 253 KBytes

[ 5] 7.00-8.00 sec 11.3 MBytes 94.9 Mbits/sec 0 279 KBytes

[ 5] 8.00-9.00 sec 11.3 MBytes 94.9 Mbits/sec 4 221 KBytes

[ 5] 9.00-10.00 sec 11.2 MBytes 94.3 Mbits/sec 0 259 KBytes

- - - - - - - - - - - - - - - - - - - - - - - - -

[ ID] Interval Transfer Bitrate Retr

[ 5] 0.00-10.00 sec 113 MBytes 94.8 Mbits/sec 18 sender

[ 5] 0.00-10.02 sec 111 MBytes 92.9 Mbits/sec receiver

iperf Done.Hat jemand eine Idee wo hier der Flaschenhals liegen könnte?

Gibt es noch andere Möglichkeiten um diesen geringen Upload-Speed besser nachvollziehen/einschränken zu können?

Vielen Dank für eure Unterstützung!