Morgen

@news

Wenn der offizielle Weg A ist, ich den Weg B nehme, dabei aber potentielles Problem C verursache, mir Problem C noch nicht mal bewusst ist, kann es schief gehen.

Viele schlaue Leute haben sich vermutlich viele schlaue Gedanken gemacht und sich bewusst für den weniger komfortablen Weg A anstelle von Weg B entschieden, eben genau weil sie potentielles Problem C (und D und E und F) im Auge hatten.

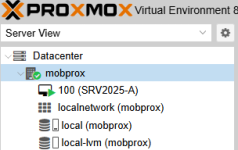

Ein Beispiel: Proxmox empfiehlt mirror anstelle von RAIDZ. Ich meine ich bin schlauer oder dies treffe auf mich nicht zu. Ich lerne wie ZFS funktioniert, was es mit volblocksize und pool geometry auf sich hat. Urplötzlich verstehe ich woher die Empfehlung kommt.

Ich persönlich bin darum grosser Fan mich an die Empfehlungen der Hersteller zu halten. Das kann aber natürlich jeder so handhaben wie er will.