Liebe proxmox Gemeinde,

ich habe folgendes Problem das ich alleine nicht lösen kann und soweit im Forum auch nichts gefunden habe

System:

Mainboard supermicro X12SCA-5F (auch getestet mit X12STH-F)

Raid Controller ist aus (auf AHCI gestellt)

Platten direkt am SATA Port (Kabel sind getauscht)

2 x Intenso 500GB SSD (auch getestet mit Crucial MX500 SSD 1TB)

2 x Samsung 32GB DDR4 mit ECC

1 x M.2 NVMe für Daten

Intel Xeon E-2324G

Gehäuse SilverStone CS350

Proxmox VE letzte Version

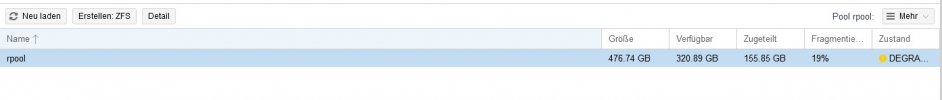

Installation ging problemlos ZFS Raid1 auf 2 Platten. Mehrere VMs und LXC eingerichtet.

VMs und proxmox selber läuft auf local_ZFS, gesichert wird auf ein NAS. Eine M.2 für Daten ist auch verbaut und läuft problemlos.

Erstes einfrieren des kompletten Systems beim Hochladen einer 6GB großen Win iso. Dann beim runterladen eines größeren docker Containers. Also immer wenn vielen Daten geschrieben werden.

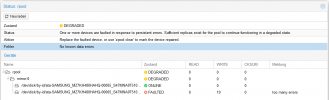

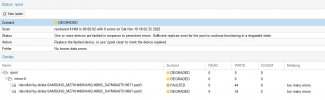

Konnte mal einen screenshot machen (ist angefügt).

Festplatte getauscht, selber Fehler. ZFS wird degraded und die Platte scheint nicht mehr unter disks auf. Proxmox rpool meldet disconnected.

Neue Festplatte gekauft und per zpool replace getauscht. Die darauffolgende rpool Herstellung bricht nach 5 Minuten ab und die neu Festplatte scheint nicht mehr auf. Bios kennt sie noch.

Hardware wurde getauscht: SSD, Kabel, Mainboard

Liegt es an den konsumer SSDs?

Hoffe ich konnte mich halbwegs verständlich ausdrücken, ist mein erster Forumseintrag.

Bin für jeden Tipp sehr dankbar.

ich habe folgendes Problem das ich alleine nicht lösen kann und soweit im Forum auch nichts gefunden habe

System:

Mainboard supermicro X12SCA-5F (auch getestet mit X12STH-F)

Raid Controller ist aus (auf AHCI gestellt)

Platten direkt am SATA Port (Kabel sind getauscht)

2 x Intenso 500GB SSD (auch getestet mit Crucial MX500 SSD 1TB)

2 x Samsung 32GB DDR4 mit ECC

1 x M.2 NVMe für Daten

Intel Xeon E-2324G

Gehäuse SilverStone CS350

Proxmox VE letzte Version

Installation ging problemlos ZFS Raid1 auf 2 Platten. Mehrere VMs und LXC eingerichtet.

VMs und proxmox selber läuft auf local_ZFS, gesichert wird auf ein NAS. Eine M.2 für Daten ist auch verbaut und läuft problemlos.

Erstes einfrieren des kompletten Systems beim Hochladen einer 6GB großen Win iso. Dann beim runterladen eines größeren docker Containers. Also immer wenn vielen Daten geschrieben werden.

Konnte mal einen screenshot machen (ist angefügt).

Festplatte getauscht, selber Fehler. ZFS wird degraded und die Platte scheint nicht mehr unter disks auf. Proxmox rpool meldet disconnected.

Neue Festplatte gekauft und per zpool replace getauscht. Die darauffolgende rpool Herstellung bricht nach 5 Minuten ab und die neu Festplatte scheint nicht mehr auf. Bios kennt sie noch.

Hardware wurde getauscht: SSD, Kabel, Mainboard

Liegt es an den konsumer SSDs?

Hoffe ich konnte mich halbwegs verständlich ausdrücken, ist mein erster Forumseintrag.

Bin für jeden Tipp sehr dankbar.