Liebe Mitglieder,

Ich habe eine Frage zu PVE auf einem NUC 14 Pro in Kombination mit einer SSD und NVMe.

Hardware:

ASUS NUC 14 Pro

CPU: i7-155H, RAM: 96GB (SO-DIMM, DDR5, 5600 MHz), SSD: 1x 2.5“ SAMSUNG EVO 870 (500GB), 1x M.2 SAMSUNG 990 PRO (2TB)

Software:

Proxmox Virtual Environment 8.3.3

Situation:

- Auf der SAMSUNG EVO 870 ist PVE installiert.

- SAMSUNG 990 PRO beherbergt alle VMs und dergleichen.

- Siehe Bilder für die Konfiguration der SSDs.

Problem:

- Mit einer gewissen Regelmäßigkeit verliert PVE plötzlich die Verbindung mit dem SAMSUNG 990 PRO.

1) Manchmal hilft ein Neustart, 2) Manchmal muss ich das System komplett ausschalten und 2 Minuten warten, 3) Manchmal schraube ich die NVMe heraus, starte PVE mit Fehlern neu, schalte das System aus und schraube die NVMe wieder ein und es funktioniert wieder.

Alles in allem, seltsam, dass die oben genannten Schritte notwendig sind, oder?

Es ist mir jetzt 2x mit diesem System passiert, aber auch 4-5x mit einem identischen anderen System.

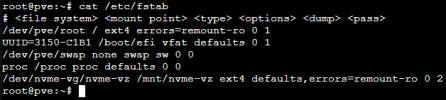

Als Vorsichtsmaßnahme habe ich auch die Firmware/Bios sowohl des NUC als auch des NVMe auf die neuesten Versionen aktualisiert. Dies hat das Problem bisher nicht gelöst. Ich hätte möglicherweise den Verweis in /etc/fstab für einen direkten Neustart zu einem funktionierenden PVE entfernen können, aber dann bleibt das Problem mit dem NVMe bestehen.

Hat jemand eine Idee, woran das liegen könnte? Liegt es am NUC, am NVMe-Laufwerk oder woran?

Fehlermeldung:

Dies ist leider variabel, aber es läuft darauf hinaus, dass die Verbindung zum NVMe verloren geht. Die aktuellste Fehlermeldung:

"[TIME] Timed out waiting for device dev-nvme\x2dvg-nvme\x2dvz.device - /dev/nvme-vg/nvme-vz.

[DEPEND] Dependency failed for systemd-fsck@dev-nvme\x2dvg-nvme\x2dvz.service - File System Check on /dev/nvme-vg/nvme-vz.

[DEPEND] Dependency failed for mnt-nvme\x2dvz.mount - /mnt/nvme-vz.

[DEPEND] Dependency failed for local-fs.target - Local File Systems.

You are in emergency mode. After logging in, type ..."

Bilder:

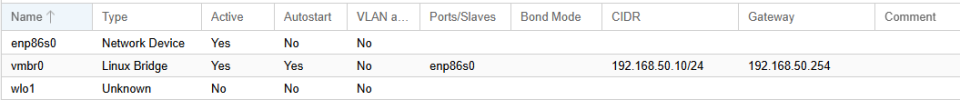

Software

Anzeige

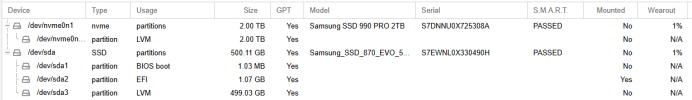

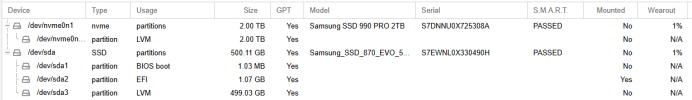

Festplatten

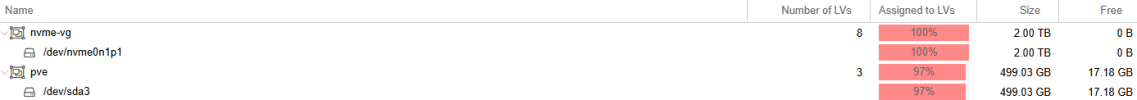

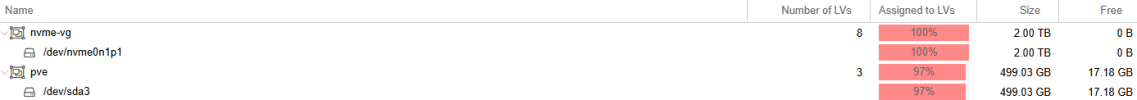

LVM

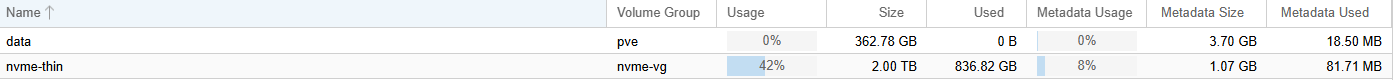

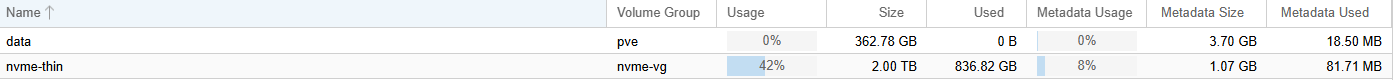

LVM-Thin

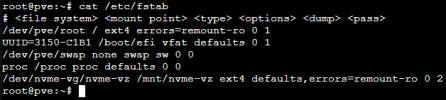

/etc/fstab

Logbuch:

Das Protokoll basiert auf den unten aufgeführten Schritten.

1) Feststellen, dass kein Server mehr online war.

2) Einfach einen Neustart von PVE durchgeführt.

3) Kein Ergebnis, NVMe nicht gefunden und Booten in den Notfallmodus.

Schließlich schalte ich den Server für eine geringere Zeit aus und schaltete ihn nach 10 Minuten wieder ein. Diesmal konnte er dann alles wieder finden. In dem früheren Bericht habe ich mir andere Tricks einfallen lassen, um ihn wieder online zu bekommen. Es variiert also, ist aber alles andere als stabil.

>>> Das Logbuch ist aus Gründen der Länge beigefügt. <<<

Ich bin sehr gespannt auf Ihre Ideen und Inspirationen. Hoffentlich bekomme ich das in den Griff und wird es stabil werden.

Vielen Dank für den Hinweis,

Canefield

Ich habe eine Frage zu PVE auf einem NUC 14 Pro in Kombination mit einer SSD und NVMe.

Hardware:

ASUS NUC 14 Pro

CPU: i7-155H, RAM: 96GB (SO-DIMM, DDR5, 5600 MHz), SSD: 1x 2.5“ SAMSUNG EVO 870 (500GB), 1x M.2 SAMSUNG 990 PRO (2TB)

Software:

Proxmox Virtual Environment 8.3.3

Situation:

- Auf der SAMSUNG EVO 870 ist PVE installiert.

- SAMSUNG 990 PRO beherbergt alle VMs und dergleichen.

- Siehe Bilder für die Konfiguration der SSDs.

Problem:

- Mit einer gewissen Regelmäßigkeit verliert PVE plötzlich die Verbindung mit dem SAMSUNG 990 PRO.

1) Manchmal hilft ein Neustart, 2) Manchmal muss ich das System komplett ausschalten und 2 Minuten warten, 3) Manchmal schraube ich die NVMe heraus, starte PVE mit Fehlern neu, schalte das System aus und schraube die NVMe wieder ein und es funktioniert wieder.

Alles in allem, seltsam, dass die oben genannten Schritte notwendig sind, oder?

Es ist mir jetzt 2x mit diesem System passiert, aber auch 4-5x mit einem identischen anderen System.

Als Vorsichtsmaßnahme habe ich auch die Firmware/Bios sowohl des NUC als auch des NVMe auf die neuesten Versionen aktualisiert. Dies hat das Problem bisher nicht gelöst. Ich hätte möglicherweise den Verweis in /etc/fstab für einen direkten Neustart zu einem funktionierenden PVE entfernen können, aber dann bleibt das Problem mit dem NVMe bestehen.

Hat jemand eine Idee, woran das liegen könnte? Liegt es am NUC, am NVMe-Laufwerk oder woran?

Fehlermeldung:

Dies ist leider variabel, aber es läuft darauf hinaus, dass die Verbindung zum NVMe verloren geht. Die aktuellste Fehlermeldung:

"[TIME] Timed out waiting for device dev-nvme\x2dvg-nvme\x2dvz.device - /dev/nvme-vg/nvme-vz.

[DEPEND] Dependency failed for systemd-fsck@dev-nvme\x2dvg-nvme\x2dvz.service - File System Check on /dev/nvme-vg/nvme-vz.

[DEPEND] Dependency failed for mnt-nvme\x2dvz.mount - /mnt/nvme-vz.

[DEPEND] Dependency failed for local-fs.target - Local File Systems.

You are in emergency mode. After logging in, type ..."

Bilder:

Software

Anzeige

Festplatten

LVM

LVM-Thin

/etc/fstab

Logbuch:

Das Protokoll basiert auf den unten aufgeführten Schritten.

1) Feststellen, dass kein Server mehr online war.

2) Einfach einen Neustart von PVE durchgeführt.

3) Kein Ergebnis, NVMe nicht gefunden und Booten in den Notfallmodus.

Schließlich schalte ich den Server für eine geringere Zeit aus und schaltete ihn nach 10 Minuten wieder ein. Diesmal konnte er dann alles wieder finden. In dem früheren Bericht habe ich mir andere Tricks einfallen lassen, um ihn wieder online zu bekommen. Es variiert also, ist aber alles andere als stabil.

>>> Das Logbuch ist aus Gründen der Länge beigefügt. <<<

Ich bin sehr gespannt auf Ihre Ideen und Inspirationen. Hoffentlich bekomme ich das in den Griff und wird es stabil werden.

Vielen Dank für den Hinweis,

Canefield