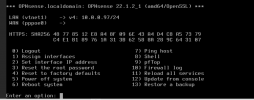

Soweit ich das verstanden habe werden an das Interface OPNsense LAN die VLANs angehängt.Soll die OPNsense denn echt nur im LAN und WAN hängen? Die soll doch bestimmt auch eine virtuelle NIC in den ganzen anderen VLAN haben damit smarthome Sachen etc auch ins Internet kommen.

Eigene NIC fürs Management finde ich etwas überflüssig. Da könnte man auch ein MNGT VLAN für machen.

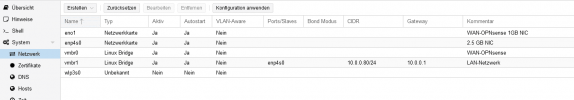

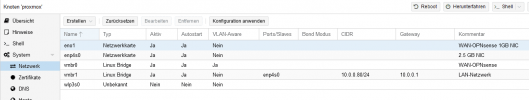

Da würde ich persönlich 4 NICs als LACP Bond auf dem Host einrichten an einer vlan aware Bridge vmbr0. Der vmbr0 verpasst du dann ein VLAN Interface für das Management (vmbr0.2 z.B. wenn das Management auf VLAN 2 soll) und gibst dem vmbr0.2 dann eine IP für SSH und das WebUI. Dann kommt nichts an Proxmox ran außer es sitzt auch im Management VLAN.

Die fünfte NIC kannst du dann ja für WAN lassen und an OPNsense durchreichen.

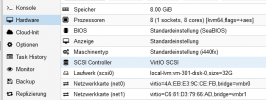

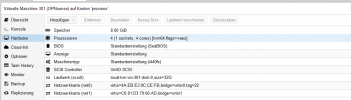

Alle VLANs und OPNsense würde ich dann über virtuelle NIC über vmbr0 laufen lassen. Dann haben alle VMs intern 10Gbit über Virtio und die VLANs können sich dann die 4Gbit vom Bond für die Außenkommunikation teilen.

Du kannst da ja dann beliebig viele VLANs über den Bond zum Switch laufen lassen wenn du tagged VLAN nutzt. Das gleiche mit vmbr0. Auf der kannst du auch beliebig viele VLANs parallel betreiben.

Das bedeutet, dass über dieses Interface, verbunden mit dem Managed Switch, alle Kommunikation aller VLANs geht.

Du hast in deinem vorigen Post auf den Vorteil hingewiesen, wenn alle NICs an die OPNsense VM durchgereicht werden und der LACP Bond in OPNsense eingerichtet wird. In deinem letzten Post empfiehlst du aber, den LACP Bond auf dem Proxmox Host einzurichten.

Das ist jetzt etwas verwirrend.

Und ist die Empfehlung, einen LACP Bond über 4 NICs einzurichten davon abhängig, ob es sich um Dual-Port NICs oder Quad-Port NIC handelt?

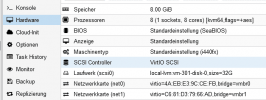

In meinem Fall habe ich eine Quad-Port NIC (Intel I350-T4) + Single-Port NIC (Mainboard).

Ich hatte geplant, auf ein anderes NIC die Netzwerke Management und Corosync zu legen als VLAN.

Und ich würde dir zustimmen, dass eine dedizierte NIC für Management overkill ist.

Die Frage ist, ob das Netzwerk Corosync so kritisch ist, dass man es nicht in ein VLAN legen sollte?

Last edited: