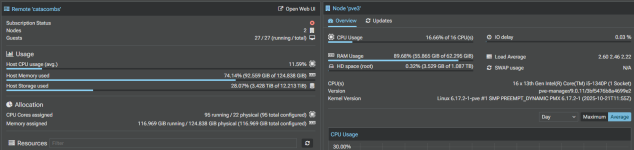

Ich fürchte, der Speicher läuft schon wieder voll ...

Das ist ein Stück weit aber normal, weil Linux (und eigentlich auch alle anderen Betriebssysteme) sehr gut darin sind nicht genutzten Arbeitsspeicher für Caching zu verwenden. Was aber andere Systeme teilweise anders machen, dass sie in ihrer Anzeige für freien Speicher den für Cache belegten "rausrechnen".

Mehr dazu:

https://www.linuxatemyram.com/

Mehr spezifisch für ProxmoxVE: https://forum.proxmox.com/threads/vm-debian-mem-usage-strange-display.165931/

Das ist gut, weil nicht genutzter RAM ist Verschwendung und es ist schlecht, weil der VM zugewiesenen RAM man nicht anderswo zuweisen kann.

Darum ist die Standardempfehlung für sowas, auf den VMs/lxcs eine Monitoringsoftware zu installieren, mit dem man die Systemparameter von "innen" überwachen kann und den der VM/dem LXC zugewiesenen RAM nach tatsächlichen Bedarf zuzuweisen. Die Doku der entsprechenden Software ist dafür meistens ein ganz guter Richtwert, für HomeAssistant sind das 2GB RAM als Minimum: https://www.home-assistant.io/installation/linux

Aber 4 GB finde ich auch voll vertretbar, dann hat die VM noch ein wenig "Luft" für Caching. Wenn du von den aktuell zugewiesenen 4/8 GB gerne etwas für andere VMS haben willst, könntest du das noch auf 2 GB Minimum/4GB Standard reduzieren.