Ich betreibe 2 Cluster,

1X tolles neues wo alles erwartungsgemäss funktioniert, aber einmal ein günstigeres Setup was in der VM aber eine meiner Meinung nach viel zu schlechte Performance abliefert.

Einmal die eingesetzte Hardware und Config:

Wir hatten das Synology NAS in Verdacht zur schlechten Performance / Hohe IO Wartezeiten.

Wir haben aber eine nicht viel bessere Performance auf dem einfach gestarteten Ceph Cluster und gehen daher von einem Fehler aus, den wir noch nicht gesehen haben.

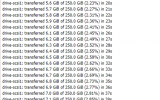

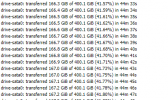

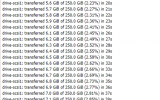

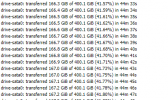

Generell schwanken die Messerte stark auf einem Ceph Pool, der sonnst noch nichts macht

(zum zeitpunkt der Messungen, mitlerweile schon)

Probleme oder Messwerte die uns komisch vorkamen/sind:

Back 2 Basic ... Ceph Performance Report:

Ich würde also sagen das die Leistung im zu erwartenden Ramen liegt,

Sachen die mir aufgefallen sind:

Hohe apply/commit latenz

Hauptsächliches Problem ist aber die Performance in einer VM:

ich wäre für einen Gedankengang offen was man anschauen könnte, / verändern könnte...

Advanced Schulung ist leider erst im März, aber aktuell nutze ich Proxmox seit version PVE 2.0

Danke bereits.

1X tolles neues wo alles erwartungsgemäss funktioniert, aber einmal ein günstigeres Setup was in der VM aber eine meiner Meinung nach viel zu schlechte Performance abliefert.

Einmal die eingesetzte Hardware und Config:

Server 1

1x Supermicro Mainboard X11DPi-NT

2x Intel Xeon Silver 4210 (2,20GHz, 10-Core, 13.25MB)

8x 64 GB (1x 65536MB) ECC Registered (RDIMM) DDR4 2933 RAM 2 Rank (ATP Server-Grade)

2x 240 GB Samsung PM893 2,5" SATA SSD (OS disk)

1 x Samsung 870 QVO 8000 GB, 2.5" (Ceph )

1x 1 Gigabit Supermicro I350-T2 RJ45 Dual Port Netzwerkkarte (VM/WAN)

1x 10 Gbit Onboard NIC (Ceph)

Server 2+3

1x Supermicro Mainboard X11DPL-i

2x Intel Xeon Silver 4210 (2,20GHz, 10-Core, 13.25MB)

4x 64 GB (1x 32768 MB) ECC Registered (RDIMM) DDR4 2933 RAM 2 Rank (Samsung non-Premium)

2x 960 GB Intel D3-S4510 2,5" SATA SSD (OS Disk)

1x Samsung 870 QVO 8000 GB, 2.5" (Ceph )

1x Intel 10 Gigabit X550-T2 RJ45 Dual Port Netzwerkkarte

1x 1 Gbit onboard nic für VM/WAN)

1x Cisco SG300 Switch 1 Gbit als VM/WAN Switch mit kundennetzen etc.

1x QNAP QSW-1208-8C 1Port 10 GBE Switch als Storage Switch

2x Synology HA NAS als bisheriger Storage.

1x Supermicro Mainboard X11DPi-NT

2x Intel Xeon Silver 4210 (2,20GHz, 10-Core, 13.25MB)

8x 64 GB (1x 65536MB) ECC Registered (RDIMM) DDR4 2933 RAM 2 Rank (ATP Server-Grade)

2x 240 GB Samsung PM893 2,5" SATA SSD (OS disk)

1 x Samsung 870 QVO 8000 GB, 2.5" (Ceph )

1x 1 Gigabit Supermicro I350-T2 RJ45 Dual Port Netzwerkkarte (VM/WAN)

1x 10 Gbit Onboard NIC (Ceph)

Server 2+3

1x Supermicro Mainboard X11DPL-i

2x Intel Xeon Silver 4210 (2,20GHz, 10-Core, 13.25MB)

4x 64 GB (1x 32768 MB) ECC Registered (RDIMM) DDR4 2933 RAM 2 Rank (Samsung non-Premium)

2x 960 GB Intel D3-S4510 2,5" SATA SSD (OS Disk)

1x Samsung 870 QVO 8000 GB, 2.5" (Ceph )

1x Intel 10 Gigabit X550-T2 RJ45 Dual Port Netzwerkkarte

1x 1 Gbit onboard nic für VM/WAN)

1x Cisco SG300 Switch 1 Gbit als VM/WAN Switch mit kundennetzen etc.

1x QNAP QSW-1208-8C 1Port 10 GBE Switch als Storage Switch

2x Synology HA NAS als bisheriger Storage.

Server 1-3

1x Supermicro Mainboard H12SSL-NT

1x AMD EPYC 7343 (3,20 GHz, 16-Core, 128 MB)

8x 64 GB (1x 65536 MB) ECC Registered (RDIMM) DDR4 3200 RAM 2 Rank (ATP Premium)

3x 7,68 TB Samsung PM893 2,5" SATA SSD

2x 480 GB ATP N600Sc Superior M.2 NVMe SSD

1x 25 Gigabit Broadcom P425G SFP28 Quad Port Netzwerkkarte

4x Flexoptix Transceiver 10GbE (SR, 550m, SFP+)

1x Supermicro Mainboard H12SSL-NT

1x AMD EPYC 7343 (3,20 GHz, 16-Core, 128 MB)

8x 64 GB (1x 65536 MB) ECC Registered (RDIMM) DDR4 3200 RAM 2 Rank (ATP Premium)

3x 7,68 TB Samsung PM893 2,5" SATA SSD

2x 480 GB ATP N600Sc Superior M.2 NVMe SSD

1x 25 Gigabit Broadcom P425G SFP28 Quad Port Netzwerkkarte

4x Flexoptix Transceiver 10GbE (SR, 550m, SFP+)

Wir hatten das Synology NAS in Verdacht zur schlechten Performance / Hohe IO Wartezeiten.

Wir haben aber eine nicht viel bessere Performance auf dem einfach gestarteten Ceph Cluster und gehen daher von einem Fehler aus, den wir noch nicht gesehen haben.

Generell schwanken die Messerte stark auf einem Ceph Pool, der sonnst noch nichts macht

(zum zeitpunkt der Messungen, mitlerweile schon)

Aktueller Ausbau mit 1x 8TB SSD / Node sollte auf 2 SSD's/Node angehoben werden in den nächsten Wochen sobald die SSD's aus dem NAS frei werden.

Das Cluster ist mit einem schmalen Budget gewachsen. Aktuell steht ein erster Schritt an Ausbau an.

-> geplant sind noch austausch Switch,

-> künftige Server etc mit SFP+ anstelle RJ45

-> Enterprise SSD's / NVMe

Aber aktuell ist erst ein erwartungsgemässer Betrieb geplant. und mit weiterem Ausbau dann die Migration von low-cost Optionen zu Enterprise.

Das Cluster ist mit einem schmalen Budget gewachsen. Aktuell steht ein erster Schritt an Ausbau an.

-> geplant sind noch austausch Switch,

-> künftige Server etc mit SFP+ anstelle RJ45

-> Enterprise SSD's / NVMe

Aber aktuell ist erst ein erwartungsgemässer Betrieb geplant. und mit weiterem Ausbau dann die Migration von low-cost Optionen zu Enterprise.

Probleme oder Messwerte die uns komisch vorkamen/sind:

ein Move von Ceph auf lokale SSD erreicht ca 250MiB/s

ein Move von altem NAS (NFS) auf Ceph erreicht ca 50 Mbit

Beides Live migrationen online, hier gehen wir aber mal vom alten NAS aus welches hier die schlechte performance liefert.

Dennoch reicht dieser Kopierprozess das eine VM die bereits auf dem Ceph liegt bereits merklich langsamer wird.

ein Move von altem NAS (NFS) auf Ceph erreicht ca 50 Mbit

Beides Live migrationen online, hier gehen wir aber mal vom alten NAS aus welches hier die schlechte performance liefert.

Dennoch reicht dieser Kopierprozess das eine VM die bereits auf dem Ceph liegt bereits merklich langsamer wird.

Back 2 Basic ... Ceph Performance Report:

root@svdrz247:~# rados bench -p scbench 10 write --no-cleanup

hints = 1

Maintaining 16 concurrent writes of 4194304 bytes to objects of size 4194304 for up to 10 seconds or 0 objects

Object prefix: benchmark_data_svdrz247_3611318

sec Cur ops started finished avg MB/s cur MB/s last lat(s) avg lat(s)

0 0 0 0 0 0 - 0

1 16 33 17 67.9959 68 0.336318 0.65526

2 16 65 49 97.9917 128 0.508199 0.553118

3 16 97 81 107.99 128 0.508953 0.53793

4 16 129 113 112.989 128 0.523179 0.53589

5 16 206 190 151.985 308 0.135851 0.413112

6 16 305 289 192.647 396 0.152425 0.323248

7 16 416 400 228.548 444 0.139805 0.27895

8 16 449 433 216.478 132 0.502553 0.292363

9 16 481 465 206.645 128 0.524757 0.306788

10 16 497 481 192.38 64 0.576347 0.315632

Total time run: 10.0234

Total writes made: 497

Write size: 4194304

Object size: 4194304

Bandwidth (MB/sec): 198.337

Stddev Bandwidth: 137.565

Max bandwidth (MB/sec): 444

Min bandwidth (MB/sec): 64

Average IOPS: 49

Stddev IOPS: 34.3914

Max IOPS: 111

Min IOPS: 16

Average Latency(s): 0.322647

Stddev Latency(s): 0.18728

Max latency(s): 0.68506

Min latency(s): 0.0309812

hints = 1

Maintaining 16 concurrent writes of 4194304 bytes to objects of size 4194304 for up to 10 seconds or 0 objects

Object prefix: benchmark_data_svdrz247_3611318

sec Cur ops started finished avg MB/s cur MB/s last lat(s) avg lat(s)

0 0 0 0 0 0 - 0

1 16 33 17 67.9959 68 0.336318 0.65526

2 16 65 49 97.9917 128 0.508199 0.553118

3 16 97 81 107.99 128 0.508953 0.53793

4 16 129 113 112.989 128 0.523179 0.53589

5 16 206 190 151.985 308 0.135851 0.413112

6 16 305 289 192.647 396 0.152425 0.323248

7 16 416 400 228.548 444 0.139805 0.27895

8 16 449 433 216.478 132 0.502553 0.292363

9 16 481 465 206.645 128 0.524757 0.306788

10 16 497 481 192.38 64 0.576347 0.315632

Total time run: 10.0234

Total writes made: 497

Write size: 4194304

Object size: 4194304

Bandwidth (MB/sec): 198.337

Stddev Bandwidth: 137.565

Max bandwidth (MB/sec): 444

Min bandwidth (MB/sec): 64

Average IOPS: 49

Stddev IOPS: 34.3914

Max IOPS: 111

Min IOPS: 16

Average Latency(s): 0.322647

Stddev Latency(s): 0.18728

Max latency(s): 0.68506

Min latency(s): 0.0309812

root@srv220:~# rados bench -p scbench 10 write --no-cleanup

hints = 1

Maintaining 16 concurrent writes of 4194304 bytes to objects of size 4194304 for up to 10 seconds or 0 objects

Object prefix: benchmark_data_srv220_2188239

sec Cur ops started finished avg MB/s cur MB/s last lat(s) avg lat(s)

0 0 0 0 0 0 - 0

1 16 199 183 731.954 732 0.0656796 0.0814933

2 16 316 300 599.952 468 0.590427 0.0977137

3 16 469 453 603.95 612 0.0470695 0.099092

4 16 631 615 614.949 648 0.0574583 0.101327

5 16 813 797 637.545 728 0.0613846 0.0984605

6 16 980 964 642.61 668 0.270459 0.0965525

7 16 1124 1108 633.087 576 0.0214834 0.0975533

8 16 1266 1250 624.944 568 0.0405118 0.100834

9 16 1422 1406 624.832 624 0.054028 0.101813

10 16 1598 1582 632.743 704 0.0425777 0.0998504

11 3 1598 1595 579.942 52 0.328297 0.100008

Total time run: 11.9324

Total writes made: 1598

Write size: 4194304

Object size: 4194304

Bandwidth (MB/sec): 535.686

Stddev Bandwidth: 191.625

Max bandwidth (MB/sec): 732

Min bandwidth (MB/sec): 52

Average IOPS: 133

Stddev IOPS: 47.9062

Max IOPS: 183

Min IOPS: 13

Average Latency(s): 0.104081

Stddev Latency(s): 0.161305

Max latency(s): 2.41895

Min latency(s): 0.0146019

hints = 1

Maintaining 16 concurrent writes of 4194304 bytes to objects of size 4194304 for up to 10 seconds or 0 objects

Object prefix: benchmark_data_srv220_2188239

sec Cur ops started finished avg MB/s cur MB/s last lat(s) avg lat(s)

0 0 0 0 0 0 - 0

1 16 199 183 731.954 732 0.0656796 0.0814933

2 16 316 300 599.952 468 0.590427 0.0977137

3 16 469 453 603.95 612 0.0470695 0.099092

4 16 631 615 614.949 648 0.0574583 0.101327

5 16 813 797 637.545 728 0.0613846 0.0984605

6 16 980 964 642.61 668 0.270459 0.0965525

7 16 1124 1108 633.087 576 0.0214834 0.0975533

8 16 1266 1250 624.944 568 0.0405118 0.100834

9 16 1422 1406 624.832 624 0.054028 0.101813

10 16 1598 1582 632.743 704 0.0425777 0.0998504

11 3 1598 1595 579.942 52 0.328297 0.100008

Total time run: 11.9324

Total writes made: 1598

Write size: 4194304

Object size: 4194304

Bandwidth (MB/sec): 535.686

Stddev Bandwidth: 191.625

Max bandwidth (MB/sec): 732

Min bandwidth (MB/sec): 52

Average IOPS: 133

Stddev IOPS: 47.9062

Max IOPS: 183

Min IOPS: 13

Average Latency(s): 0.104081

Stddev Latency(s): 0.161305

Max latency(s): 2.41895

Min latency(s): 0.0146019

Ich würde also sagen das die Leistung im zu erwartenden Ramen liegt,

Sachen die mir aufgefallen sind:

Hohe apply/commit latenz

Hauptsächliches Problem ist aber die Performance in einer VM:

ich wäre für einen Gedankengang offen was man anschauen könnte, / verändern könnte...

Advanced Schulung ist leider erst im März, aber aktuell nutze ich Proxmox seit version PVE 2.0

Danke bereits.