Hallo Ariston,

habt ihr schon neue Erkenntnisse gewonnen? Wir kämpfen mit ähnlichen Problemen.

Da wir kein separaten Storage mit ZFS haben müssen wir notgedrungen auch auf Isilon sichern (NFS Share).

Wir haben hier 2 unterschiedliche Isilon-Systeme, einen schnellen Flash Cluster und einen langsamen Archiv Cluster (nur HDDs).

Installiert sind 2 PBS, der primäre sichert auf den Flash Cluster und das funktioniert alles wunderbar. Der sekundäre zieht sich via Sync alle Backups rüber und dient als Fallback.

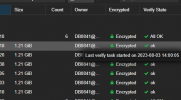

Nun haben wir das Problem, dass quasi von heute auf morgen alle Chunks gelöscht werden, in der Garbage Collection steht dann diese Info:

Interessanterweise stört das dem Verify Job überhaupt nicht, er behauptet trotzdem "Verification successful" und alles VMs haben einen grünen Haken.Code:Original Data usage: 89.354 TiB On-Disk usage: 0 B (0.00%) On-Disk chunks: 0

Zuvor hatten wir das primäre Backup auf der HDD Isilon laufen, das war auch eine Katastrophe da die geringen IOPS den NFS-Server ausgebremst haben und dadurch scheinbar nicht sauber die Daten geschrieben wurden (gleichzeitiges Backup von 5 PVE Nodes).

Der Mount erfolgt über die fstab mit "nfs nfsvers=3,defaults,_netdev,rw", auch mit NFSv4.2 keine Änderung.

das ist ja schräg.

wie kann denn ein verify sauber durchlaufen wenn die chunks nicht mehr da sind?