Hallo,

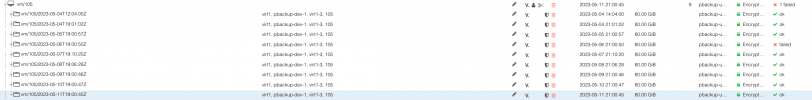

Ich sicher unsere VMs per PBS (2.4-1) von einem PVE (7.4-3) auf ein NFS-Share (auf einem Isilon Cluster). Das NFS Share ist per fstab auf dem PBS gemountet.

Die mangelnde Performance (IOPS) von NFS ist zweitrangig in diesem Fall, ist im Testbetrieb.

Solange alle Backups einer VM erfolgreich verifiziert sind, können auch alle Backups wiederhergestellt werden.

Sobald ein Backup nicht erfolgreich verifiziert wurde, kann ich kein einziges Backup der entsprechenden VM mehr wiederherstellen auch nicht Backups die vor dem

fehlgeschlagenen Lauf erzeugt wurden. Die Harddisk wird immer gelöscht.

Die Fehlermeldung bezieht sich immer auf einen fehlenden Chunk z.B. "restore failed: reading file "/nfs/.chunks/705e/705ef03501370cf36ec8a0c2193f3ebb819aeecc40b43b4a7ed911c153ef6c97" failed: No such file or directory (os error 2)"

Der entsprechende Chunk existiert auf dem Share nicht, die Fehlermeldung ist korrekt.

Wenn ich das fehlerhafte Backup lösche hat dies leider keinen Effekt. Ich kann immer noch kein Backup wiederherstellen, gleichgültig, wann das Backup erstellt wurde.

Meine Frage/Problem ist, wieso kann ein fehlerhafter Backup-Lauf alle Backups eine VM unbrauchbar machen. Selbst das erste initiale Backup kann nicht wiederhergestellt werden.

Grüße Ariston

Ich sicher unsere VMs per PBS (2.4-1) von einem PVE (7.4-3) auf ein NFS-Share (auf einem Isilon Cluster). Das NFS Share ist per fstab auf dem PBS gemountet.

Die mangelnde Performance (IOPS) von NFS ist zweitrangig in diesem Fall, ist im Testbetrieb.

Solange alle Backups einer VM erfolgreich verifiziert sind, können auch alle Backups wiederhergestellt werden.

Sobald ein Backup nicht erfolgreich verifiziert wurde, kann ich kein einziges Backup der entsprechenden VM mehr wiederherstellen auch nicht Backups die vor dem

fehlgeschlagenen Lauf erzeugt wurden. Die Harddisk wird immer gelöscht.

Die Fehlermeldung bezieht sich immer auf einen fehlenden Chunk z.B. "restore failed: reading file "/nfs/.chunks/705e/705ef03501370cf36ec8a0c2193f3ebb819aeecc40b43b4a7ed911c153ef6c97" failed: No such file or directory (os error 2)"

Der entsprechende Chunk existiert auf dem Share nicht, die Fehlermeldung ist korrekt.

Wenn ich das fehlerhafte Backup lösche hat dies leider keinen Effekt. Ich kann immer noch kein Backup wiederherstellen, gleichgültig, wann das Backup erstellt wurde.

Meine Frage/Problem ist, wieso kann ein fehlerhafter Backup-Lauf alle Backups eine VM unbrauchbar machen. Selbst das erste initiale Backup kann nicht wiederhergestellt werden.

Grüße Ariston