Hallo,

ich habe gestern Proxmox auf meinem Server aufgesetzt.

Es läuft auch super ich komme nur nicht an meine Daten im Raid.

Gibt es eine Möglichkeit noch an die Daten zu kommen? Hab die Platten lange Zeit in OpenmediaVault benutzt.

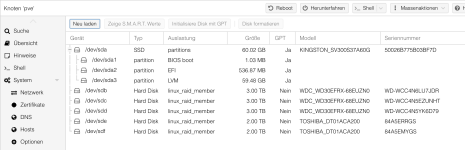

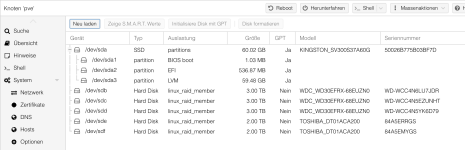

So sieht es im moment in Proxmox aus:

und so in der Konsole:

Ich vermute es liegt am Dateisystem. Ich würde es auch ändern möchte halt nur keine Daten verlieren.

Kann mir hier bitte jemand helfen.

Vielen Dank im Voraus.

Gruß Tauchi

ich habe gestern Proxmox auf meinem Server aufgesetzt.

Es läuft auch super ich komme nur nicht an meine Daten im Raid.

Gibt es eine Möglichkeit noch an die Daten zu kommen? Hab die Platten lange Zeit in OpenmediaVault benutzt.

So sieht es im moment in Proxmox aus:

und so in der Konsole:

Code:

root@pve:~# lsblk -f

NAME FSTYPE FSVER LABEL UUID FSAVAIL FSUSE% MOUNTPOINTS

sda

├─sda1

│

├─sda2

│ vfat FAT32 97C6-0C39 499.3M 2% /boot/efi

└─sda3

LVM2_m LVM2 5CtMWi-Vxa2-pYyX-CV0i-yAvi-uqWG-hbSYF9

├─pve-swap

│ swap 1 673686b9-30b1-4a02-b463-5e2f06006564 [SWAP]

├─pve-root

│ xfs fcfaefd9-7e00-4f6c-a88e-ed9237ef6c8b 20.5G 15% /

├─pve-data_tmeta

│

│ └─pve-data-tpool

│

│ ├─pve-data

│ │

│ ├─pve-vm--101--disk--0

│ │ ext4 1.0 33013591-73bb-49dd-9c4d-6228cb38f563

│ ├─pve-vm--102--disk--0

│ │ ext4 1.0 d8623707-dfca-40a1-a3a0-aa182a0bbfd4

│ ├─pve-vm--103--disk--0

│ │ ext4 1.0 f40671c8-a1a0-4cea-b92c-1e889340e4cf

│ ├─pve-vm--100--disk--0

│ │ ext4 1.0 917cb8bd-cd93-4d65-a56e-4a591235fc92

│ ├─pve-vm--104--disk--0

│ │ ext4 1.0 f6174c34-87bc-43e7-a399-d089f3073d49

│ ├─pve-vm--105--disk--0

│ │ ext4 1.0 c1cfe59b-52f8-4d44-abef-947b6b93041e

│ └─pve-vm--106--disk--0

│ ext4 1.0 e3f0c4b4-479e-4451-a55e-3a5c18f07a7d

└─pve-data_tdata

└─pve-data-tpool

├─pve-data

│

├─pve-vm--101--disk--0

│ ext4 1.0 33013591-73bb-49dd-9c4d-6228cb38f563

├─pve-vm--102--disk--0

│ ext4 1.0 d8623707-dfca-40a1-a3a0-aa182a0bbfd4

├─pve-vm--103--disk--0

│ ext4 1.0 f40671c8-a1a0-4cea-b92c-1e889340e4cf

├─pve-vm--100--disk--0

│ ext4 1.0 917cb8bd-cd93-4d65-a56e-4a591235fc92

├─pve-vm--104--disk--0

│ ext4 1.0 f6174c34-87bc-43e7-a399-d089f3073d49

├─pve-vm--105--disk--0

│ ext4 1.0 c1cfe59b-52f8-4d44-abef-947b6b93041e

└─pve-vm--106--disk--0

ext4 1.0 e3f0c4b4-479e-4451-a55e-3a5c18f07a7d

sdb linux_ 1.2 NAS:RAID

3d92fe51-2c98-a43d-e0e4-fc125975fa8d

└─md127

ext4 1.0 RAID aaf397df-5907-4951-9729-78b374749901

sdc linux_ 1.2 NAS:RAID

3d92fe51-2c98-a43d-e0e4-fc125975fa8d

└─md127

ext4 1.0 RAID aaf397df-5907-4951-9729-78b374749901

sdd linux_ 1.2 NAS:RAID

3d92fe51-2c98-a43d-e0e4-fc125975fa8d

└─md127

ext4 1.0 RAID aaf397df-5907-4951-9729-78b374749901

sde linux_ 1.2 NAS:Mirror

a49ee451-1e02-4fb0-1960-070661d9251d

sdf linux_ 1.2 NAS:Mirror

a49ee451-1e02-4fb0-1960-070661d9251d

└─md126

ext4 1.0 Mirror

6387af71-6073-4ed8-aa91-6ad20f3837c1

root@pve:~#Ich vermute es liegt am Dateisystem. Ich würde es auch ändern möchte halt nur keine Daten verlieren.

Kann mir hier bitte jemand helfen.

Vielen Dank im Voraus.

Gruß Tauchi