Hallo zusammen!

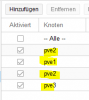

Wir haben ca. 20 VMs in einem dreier Cluster mit Ceph am laufen.

Die hälfte der VMs wurde mit Clonezilla migriert, P2V, die andere hälfte habe ich zu raw convertiert von vmware.

Nun das Problem. Vor ein paar Wochen hat sich eine Ubuntu 18.04. VM aufgehängt, diese wurde von vmware convertiert, lief ohne Probleme. Ein Stop der VM war nötig, da sie nicht mehr erreichbar war. Aber nach klicken von Start der VM, kam der Bootscreen mit der Meldung no bootable device...

Eine Woche später eine migrierte VM, SLES 12, es scheint als würde die VM eingefroren sein. Auch hier hilft nur ein Stop und Start der VM. Der selbe Effekt, kein bootable device. Und heute die dritte VM, ebenso scheint sie im freeze state gewesen zu sein. Kein reboot möglich.

Ich habe etliche boot/live iso tools versucht, um die VM bzw. auf die eigentliche Partition zugreifen zu können, aber immer vergebens, die vm bzw. die Festplatte ist einfach komplett leer/nicht lesbar.

Es half hier nur das letzte Backup einzuspielen, das funktionierte bei zwei VMs, bei einer war sogar das Backup nicht mehr brauchbar.

Hatte jemand ähnliche "Erfahrungen", das sich nach einem "aufhänger", kernel panic oder anderem verhalten, die VM bzw. die Festplatte nicht mehr lesbar/bootfähig ist?

Ich hatte nie so ein problem in der Vergangenheit, warum sind die "daten" der Vm nach einem reboot einfach weg?

Vielen dank für euer feedback.

PVE 5.4-13, alle Knoten sind up to date.

Ceph 12.2.12 mit 21 osds (je 1TB), dreifachverteilung, 1024pg_num/pgp_num

EDIT: Es könnte an den Backupjobs bzw. Backupstarts liegen - laut graphen passierte das immer, sobald die VM gebackupt wird - zumindest hat es sich bei den Vorfällen so verhalten.

Wir haben ca. 20 VMs in einem dreier Cluster mit Ceph am laufen.

Die hälfte der VMs wurde mit Clonezilla migriert, P2V, die andere hälfte habe ich zu raw convertiert von vmware.

Nun das Problem. Vor ein paar Wochen hat sich eine Ubuntu 18.04. VM aufgehängt, diese wurde von vmware convertiert, lief ohne Probleme. Ein Stop der VM war nötig, da sie nicht mehr erreichbar war. Aber nach klicken von Start der VM, kam der Bootscreen mit der Meldung no bootable device...

Eine Woche später eine migrierte VM, SLES 12, es scheint als würde die VM eingefroren sein. Auch hier hilft nur ein Stop und Start der VM. Der selbe Effekt, kein bootable device. Und heute die dritte VM, ebenso scheint sie im freeze state gewesen zu sein. Kein reboot möglich.

Ich habe etliche boot/live iso tools versucht, um die VM bzw. auf die eigentliche Partition zugreifen zu können, aber immer vergebens, die vm bzw. die Festplatte ist einfach komplett leer/nicht lesbar.

Es half hier nur das letzte Backup einzuspielen, das funktionierte bei zwei VMs, bei einer war sogar das Backup nicht mehr brauchbar.

Hatte jemand ähnliche "Erfahrungen", das sich nach einem "aufhänger", kernel panic oder anderem verhalten, die VM bzw. die Festplatte nicht mehr lesbar/bootfähig ist?

Ich hatte nie so ein problem in der Vergangenheit, warum sind die "daten" der Vm nach einem reboot einfach weg?

Vielen dank für euer feedback.

PVE 5.4-13, alle Knoten sind up to date.

Ceph 12.2.12 mit 21 osds (je 1TB), dreifachverteilung, 1024pg_num/pgp_num

EDIT: Es könnte an den Backupjobs bzw. Backupstarts liegen - laut graphen passierte das immer, sobald die VM gebackupt wird - zumindest hat es sich bei den Vorfällen so verhalten.

Last edited: