Hallo zusammen,

ich bin neu in Proxmox und beschäftige mich gerade mit dem Aufbau, bzw. der Zusammenstellung eines neuen PCs dafür.

Vorab: Ich habe bisher seit rund 2 Jahr Home Assistant auf einem Intel NUC8i3BEH 24/7 benutzt. Da ich u.a. auch noch OPNSense in mein Netzwerk integrieren möchte habe ich vor rund 1 Woche auf dem NUC Proxmox installiert und dann HA in einer VM. Da ich schon seit ein paar Jahren Linux nutze war die Install. und Einrichtung nicht weiter schwierig. Auch wenn ich nicht so tief im Thema Linux drin bin (komme aus DOS-Zeiten).

Bei der Proxmox Install. habe ich mich daran orientiert und bei der HA Install. dann daran. Bis auf das ein oder andere kleinere Problem, das es zu überwinden galt, läuft alles relativ problemlos.

Da ich wie gesagt noch OPNSense einsetzen will und der kleine NUC bzgl. NIC und Einbaumöglichkeiten eh begrenzt ist, habe ich mir einen Refurbished FUJITSU ESPRIMO D957/E90+ mit Core i3-7100 bestellt, den es nun gilt für Proxmox auszustatten bzw. einzurichten. Das Schätzchen bekommt dann noch 32 GB RAM und eine 2- oder 4-Port NIC (Intel I340/i350 -t2/-t4 als OEM) verpasst und soll dann wieder 24/7 laufen.

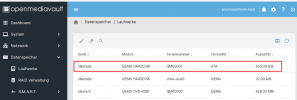

An Speichermedien habe ich zur Verfügung:

- 500GB Crucial P1 NVMe M.2

- 1TB Crucial MX500 SSD

- 250GB SSD (ist in dem Esprimo der erst nächste Woche hier ankommt)

- 120GB SanDisk SSD

- div. 3,5" 1TB SATA HDDs die aber aus Stromspargründen eigentlich nicht verbaut werden sollen

- Backups erfolgen bei mir auf Synology DS215j und DS218+

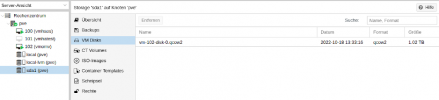

Unter Proxmox soll dann laufen (Stand heute): HA, OPNSense und ggf. noch Jellyfin (oder etwas Ähnliches).

Weiterhin plane ich noch den PC als Speicher für Medien-Dateien (Filme und Musik) im LAN zur Verfügung zu stellen, weil er ja eh 24/7 läuft. Dafür würde 1TB an Speicherplatz reichen. Dann könnte ich nämlich eins meiner beiden NAS, dass jetzt dafür zuständig ist, "in Rente schicken". --> Spart Strom.

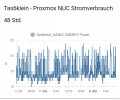

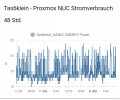

Was ich bei dem ganzen Aufbau immer im Auge behalte ist natürlich auch der Stromverbrauch. Als der NUC nur mit HA lief lag der durchschnittliche Stromverbrauch relativ gleichmässig bei 10 - 11 Watt. Jetzt mit Proxmox + HA liegt er bei ca. 15 Watt (mit starken Schwankungen). Anm.: Dazu komme ich aber noch in einem anderen Beitrag/Posting.

Bei dem ESPRIMO D957 hoffe und rechne ich dann bei i3-7100 + 32GB + Crucial P1 NVMe M.2 + SSD + NIC + Kleinkram mit einem durschnittlichen Stromverbrauch von ca. 20 Watt.

Nun zu meinen eigentichen Fragen:

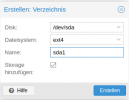

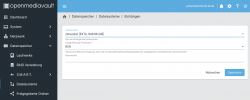

1. Mein geplanter Aufbau sehe so aus: 500GB Crucial P1 NVMe M.2 für Proxmox und die VMs und die 1TB Crucial MX500 SSD ausschließlich für die Medien-Dateien. Gibt es dazu Alternativ-/Verbesserungsvorschläge? Anm.: Proxmox Backup/Snapshots erfolgen auf einem NAS, bzw. Proxmox selber wird per Clonzilla Image gesichert.

2. HA soll weiterhin, bzw. dann wieder, in einer VM laufen. Gebe es ggf. irgendwelche Vorteile andere/weitere Anwendungen (OPNSense, Jellyfin ...) ggf. als LXC Container laufen zu lassen?

3. Gibt es irgendwelche Vorschläge was ich vielleicht anders machen könnte oder sollte und/oder was ich beachten/bedenken sollte?

4. Wie würdet Ihr das mit der 1TB für Medien-Dateien (Filme und Musik) umsetzen, sprich wie würdet ihr die in dem LAN bereitstellen, sodass alle Clients (Smart-TV, Linux Receiver Media Player, Tablets usw.) per App xyz, bzw. NFS darauf zugreifen können? Einfach als Storage unter Proxmox einbinden?

Danke für's lesen und für die vielleicht/hoffentlich kommenden Kommentare/Vorschläge/Tipps/Hinweise.

VG Jim

ich bin neu in Proxmox und beschäftige mich gerade mit dem Aufbau, bzw. der Zusammenstellung eines neuen PCs dafür.

Vorab: Ich habe bisher seit rund 2 Jahr Home Assistant auf einem Intel NUC8i3BEH 24/7 benutzt. Da ich u.a. auch noch OPNSense in mein Netzwerk integrieren möchte habe ich vor rund 1 Woche auf dem NUC Proxmox installiert und dann HA in einer VM. Da ich schon seit ein paar Jahren Linux nutze war die Install. und Einrichtung nicht weiter schwierig. Auch wenn ich nicht so tief im Thema Linux drin bin (komme aus DOS-Zeiten).

Bei der Proxmox Install. habe ich mich daran orientiert und bei der HA Install. dann daran. Bis auf das ein oder andere kleinere Problem, das es zu überwinden galt, läuft alles relativ problemlos.

Da ich wie gesagt noch OPNSense einsetzen will und der kleine NUC bzgl. NIC und Einbaumöglichkeiten eh begrenzt ist, habe ich mir einen Refurbished FUJITSU ESPRIMO D957/E90+ mit Core i3-7100 bestellt, den es nun gilt für Proxmox auszustatten bzw. einzurichten. Das Schätzchen bekommt dann noch 32 GB RAM und eine 2- oder 4-Port NIC (Intel I340/i350 -t2/-t4 als OEM) verpasst und soll dann wieder 24/7 laufen.

An Speichermedien habe ich zur Verfügung:

- 500GB Crucial P1 NVMe M.2

- 1TB Crucial MX500 SSD

- 250GB SSD (ist in dem Esprimo der erst nächste Woche hier ankommt)

- 120GB SanDisk SSD

- div. 3,5" 1TB SATA HDDs die aber aus Stromspargründen eigentlich nicht verbaut werden sollen

- Backups erfolgen bei mir auf Synology DS215j und DS218+

Unter Proxmox soll dann laufen (Stand heute): HA, OPNSense und ggf. noch Jellyfin (oder etwas Ähnliches).

Weiterhin plane ich noch den PC als Speicher für Medien-Dateien (Filme und Musik) im LAN zur Verfügung zu stellen, weil er ja eh 24/7 läuft. Dafür würde 1TB an Speicherplatz reichen. Dann könnte ich nämlich eins meiner beiden NAS, dass jetzt dafür zuständig ist, "in Rente schicken". --> Spart Strom.

Was ich bei dem ganzen Aufbau immer im Auge behalte ist natürlich auch der Stromverbrauch. Als der NUC nur mit HA lief lag der durchschnittliche Stromverbrauch relativ gleichmässig bei 10 - 11 Watt. Jetzt mit Proxmox + HA liegt er bei ca. 15 Watt (mit starken Schwankungen). Anm.: Dazu komme ich aber noch in einem anderen Beitrag/Posting.

Bei dem ESPRIMO D957 hoffe und rechne ich dann bei i3-7100 + 32GB + Crucial P1 NVMe M.2 + SSD + NIC + Kleinkram mit einem durschnittlichen Stromverbrauch von ca. 20 Watt.

Nun zu meinen eigentichen Fragen:

1. Mein geplanter Aufbau sehe so aus: 500GB Crucial P1 NVMe M.2 für Proxmox und die VMs und die 1TB Crucial MX500 SSD ausschließlich für die Medien-Dateien. Gibt es dazu Alternativ-/Verbesserungsvorschläge? Anm.: Proxmox Backup/Snapshots erfolgen auf einem NAS, bzw. Proxmox selber wird per Clonzilla Image gesichert.

2. HA soll weiterhin, bzw. dann wieder, in einer VM laufen. Gebe es ggf. irgendwelche Vorteile andere/weitere Anwendungen (OPNSense, Jellyfin ...) ggf. als LXC Container laufen zu lassen?

3. Gibt es irgendwelche Vorschläge was ich vielleicht anders machen könnte oder sollte und/oder was ich beachten/bedenken sollte?

4. Wie würdet Ihr das mit der 1TB für Medien-Dateien (Filme und Musik) umsetzen, sprich wie würdet ihr die in dem LAN bereitstellen, sodass alle Clients (Smart-TV, Linux Receiver Media Player, Tablets usw.) per App xyz, bzw. NFS darauf zugreifen können? Einfach als Storage unter Proxmox einbinden?

Danke für's lesen und für die vielleicht/hoffentlich kommenden Kommentare/Vorschläge/Tipps/Hinweise.

VG Jim