Moin allerseits. Mein erster Beitrag hier  Ich bin vor kurzem zufällig an einen ausgemusterten Terra Miniserver gekommen und habe angefangen mit proxmox rumzuspielen. Ich muss aber dazu sagen, dass ich mit Linux bisher nicht viel zu tun hatte, daher bin ich eigentlich schon froh das ich es so weit geschafft habe

Ich bin vor kurzem zufällig an einen ausgemusterten Terra Miniserver gekommen und habe angefangen mit proxmox rumzuspielen. Ich muss aber dazu sagen, dass ich mit Linux bisher nicht viel zu tun hatte, daher bin ich eigentlich schon froh das ich es so weit geschafft habe

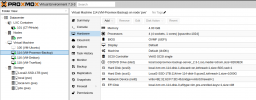

Aktuell sieht mein System so aus:

Mir geht es um die Local2-SSD-1TB (pve) Festplatte. Die habe ich als zweite Festplatte eingebaut und soll nur Daten lagern. Eigentlich ist die Platte leer. TrueNas ist zwar betriebsbereit, aber ich habe meine Daten von meinem Synology NAS noch nicht rübergeschoben. Die Platte ist in der Debian-VM gemountet und da habe ich testweise einen leeren Ordner erstellt. In der PBS-VM ist die Platte auch eingehängt. PBS habe ich aber erst die Tage aufgesetzt und nur ein Test-Backup erstellt, welches ich aber wieder gelöscht habe.

Wie ihr unten sehen könnt, müllt sich die Platte kontinuierlich zu. Und ich habe absolut keine Idee woran das liegen könnte und wie ich rausfinden kann, was die Daten draufschreibt und wie ich sie überhaupt sehen kann. Ich sehe ja nur, dass da Daten drauf sind. TrueNas sagt, die Platte ist leer. Wenn ich über den Dateiexplorer der Debian-VM auf die Platte zugreife, dann werden mir keine Dateien angezeigt außer mein angelegter, leerer Testordner.

über Hilfe würde ich mich echt freuen. Da ich ja noch Anfänger in Sachen Linux und Proxmox bin, weiß ich jetzt auch nicht genau, was ihr für Angaben braucht. Sagt es mir einfach, ich versuche Antworten zu geben Danke schon mal.

Danke schon mal.

Aktuell sieht mein System so aus:

Mir geht es um die Local2-SSD-1TB (pve) Festplatte. Die habe ich als zweite Festplatte eingebaut und soll nur Daten lagern. Eigentlich ist die Platte leer. TrueNas ist zwar betriebsbereit, aber ich habe meine Daten von meinem Synology NAS noch nicht rübergeschoben. Die Platte ist in der Debian-VM gemountet und da habe ich testweise einen leeren Ordner erstellt. In der PBS-VM ist die Platte auch eingehängt. PBS habe ich aber erst die Tage aufgesetzt und nur ein Test-Backup erstellt, welches ich aber wieder gelöscht habe.

Wie ihr unten sehen könnt, müllt sich die Platte kontinuierlich zu. Und ich habe absolut keine Idee woran das liegen könnte und wie ich rausfinden kann, was die Daten draufschreibt und wie ich sie überhaupt sehen kann. Ich sehe ja nur, dass da Daten drauf sind. TrueNas sagt, die Platte ist leer. Wenn ich über den Dateiexplorer der Debian-VM auf die Platte zugreife, dann werden mir keine Dateien angezeigt außer mein angelegter, leerer Testordner.

über Hilfe würde ich mich echt freuen. Da ich ja noch Anfänger in Sachen Linux und Proxmox bin, weiß ich jetzt auch nicht genau, was ihr für Angaben braucht. Sagt es mir einfach, ich versuche Antworten zu geben