Hi

Bin neu hier und bei Proxmox dabei.

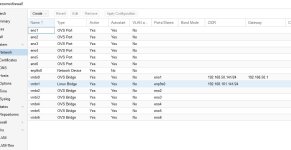

Bin gerade am migrieren von langjährigen ESXi zu PVE. Habe PVE zuerst auf dem ESXi Server getestet, da hat soweit alles geklappt, und ich kam auf Anhieb mit dem virtualisierten Host ins Internet, etwa um Updates zu ziehen. Nun habe ich mal den Schritt aufs Blech gewagt mit PVE. Es handelt sich im eine Selbstbau Firewall mit einem Supermicro X10SLH-LN6TF / N6-ST031 Mainboard (mit 3x Intel X540 NIC hinter einem PLX Chip).

Der Host ist aufgesetzt (mehrere Male). Der kommt aber nicht ins Internet. Dachte erst, es liegt an den 10 GbE Karten, weil Proxmox da ja eine OVS Bridge will. Die kann ich aber nicht einrichten, weil der Host ja kein Internet hat, und ich somit das Paket openvswitch-switch nicht installieren kann. Dachte ich mir, gut, baust Du halt eine 1 GbE Karte ein zum testen. Hier selbes Bild, Host ist erreichbar, aber der kann nicht mal den Gateway pingen. Wenn ich auf den Host Gäste installiere, beziehen die brav ihre Adresse an der betreffenden Linux-Bridge.

Firewall habe ich zum testen auch aus gemacht, sowohl im Datacenter als auch am Host selbst. Ein DNS Problem wird es auch nicht sein, da ich nicht mal den Gateway pingen kann. Habe da schon alles mögliche getestet. Auch andere IP vergeben, obwohl ich da recht sicher bin, dass da nichts doppelt vergeben wurde. Grossteil der Adressen werden eh per DHCP vergeben.

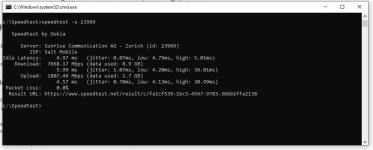

Hier im Gast, an der selben Linux Bridge:

Gruss und danke

Bin neu hier und bei Proxmox dabei.

Bin gerade am migrieren von langjährigen ESXi zu PVE. Habe PVE zuerst auf dem ESXi Server getestet, da hat soweit alles geklappt, und ich kam auf Anhieb mit dem virtualisierten Host ins Internet, etwa um Updates zu ziehen. Nun habe ich mal den Schritt aufs Blech gewagt mit PVE. Es handelt sich im eine Selbstbau Firewall mit einem Supermicro X10SLH-LN6TF / N6-ST031 Mainboard (mit 3x Intel X540 NIC hinter einem PLX Chip).

Der Host ist aufgesetzt (mehrere Male). Der kommt aber nicht ins Internet. Dachte erst, es liegt an den 10 GbE Karten, weil Proxmox da ja eine OVS Bridge will. Die kann ich aber nicht einrichten, weil der Host ja kein Internet hat, und ich somit das Paket openvswitch-switch nicht installieren kann. Dachte ich mir, gut, baust Du halt eine 1 GbE Karte ein zum testen. Hier selbes Bild, Host ist erreichbar, aber der kann nicht mal den Gateway pingen. Wenn ich auf den Host Gäste installiere, beziehen die brav ihre Adresse an der betreffenden Linux-Bridge.

Firewall habe ich zum testen auch aus gemacht, sowohl im Datacenter als auch am Host selbst. Ein DNS Problem wird es auch nicht sein, da ich nicht mal den Gateway pingen kann. Habe da schon alles mögliche getestet. Auch andere IP vergeben, obwohl ich da recht sicher bin, dass da nichts doppelt vergeben wurde. Grossteil der Adressen werden eh per DHCP vergeben.

Hier im Gast, an der selben Linux Bridge:

Gruss und danke

Last edited: