Moin,

leider muss ich mich hier mal melden. Ich kann plötzlich einen Container nicht mehr starten. Er meldet: Not enough space. Das verstehe ich nicht. Das Backup hat entpackt keine 2GB. Ich bekomme auch ein Warning dass die LVM-Thin Size überschritten ist.

In meinem NUC steckt eine 120GB M.1 SSD. Zusätzlich einen 1TB SSD angeschlossen.

Irgendwas muss ich bei der Erstellung bzw. Zuweisung im LVM falsch gemacht haben. Wie kann ich das "Geradebiegen". Da ist doch eigenlich genug Platz!

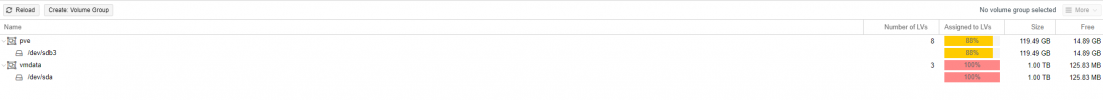

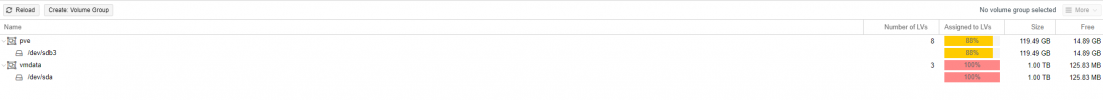

Laut LVM:

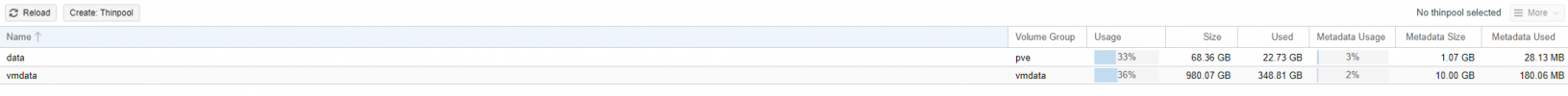

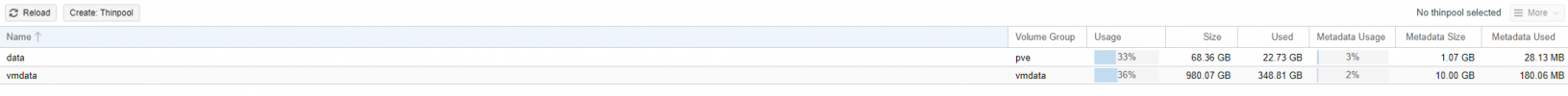

IM LVM-Thin steht das drin:

Ich habe jetzt mal ein restore auf der 1TB SSD probiert. Auch da heisst es:

Ideen was ich machen kann?

leider muss ich mich hier mal melden. Ich kann plötzlich einen Container nicht mehr starten. Er meldet: Not enough space. Das verstehe ich nicht. Das Backup hat entpackt keine 2GB. Ich bekomme auch ein Warning dass die LVM-Thin Size überschritten ist.

In meinem NUC steckt eine 120GB M.1 SSD. Zusätzlich einen 1TB SSD angeschlossen.

Irgendwas muss ich bei der Erstellung bzw. Zuweisung im LVM falsch gemacht haben. Wie kann ich das "Geradebiegen". Da ist doch eigenlich genug Platz!

Laut LVM:

IM LVM-Thin steht das drin:

Ich habe jetzt mal ein restore auf der 1TB SSD probiert. Auch da heisst es:

Code:

recovering backed-up configuration from 'Qnap:backup/vzdump-lxc-104-2022_11_21-00_26_24.tar.gz'

Logical volume "vm-104-disk-0" created.

Creating filesystem with 786432 4k blocks and 196608 inodes

Filesystem UUID: c07a6d43-452e-47f7-a464-dfe1c2769302

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912

Logical volume "vm-104-disk-1" created.

Creating filesystem with 26214400 4k blocks and 6553600 inodes

Filesystem UUID: 6d8f98f1-24b7-46f4-ae5f-e1842f414bd7

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208,

4096000, 7962624, 11239424, 20480000, 23887872

restoring 'Qnap:backup/vzdump-lxc-104-2022_11_21-00_26_24.tar.gz' now..

extracting archive '/mnt/pve/Qnap/dump/vzdump-lxc-104-2022_11_21-00_26_24.tar.gz'

tar: ./etc/ImageMagick-6/mime.xml: Cannot write: No space left on device

tar: ./etc/ImageMagick-6/type-apple.xml: Cannot write: No space left on device

tar: ./etc/ImageMagick-6/type-urw-base35.xml: Cannot write: No space left on device

tar: ./etc/timezone: Cannot write: No space left on device

...

Code:

root@pve:~# df -h

Filesystem Size Used Avail Use% Mounted on

udev 3.9G 0 3.9G 0% /dev

tmpfs 788M 1.2M 787M 1% /run

/dev/mapper/pve-root 28G 14G 13G 53% /

tmpfs 3.9G 46M 3.9G 2% /dev/shm

tmpfs 5.0M 0 5.0M 0% /run/lock

/dev/fuse 128M 20K 128M 1% /etc/pve

192.168.178.11:/Sicherung/Proxmox 2.7T 2.3T 478G 83% /mnt/pve/Qnap

tmpfs 788M 4.0K 788M 1% /run/user/0

root@pve:~# qm list

VMID NAME STATUS MEM(MB) BOOTDISK(GB) PID

202 ioBroker running 5120 15.00 2577

root@pve:~# vm list

-bash: vm: command not found

root@pve:~# pct list

VMID Status Lock Name

100 running pihole

101 running fileshare

103 running MariaDB

105 running homebridge

root@pve:~# lvm

lvm> vgs

VG #PV #LV #SN Attr VSize VFree

pve 1 8 0 wz--n- <111.29g 13.87g

vmdata 1 3 0 wz--n- 931.51g 120.00m

lvm>

Code:

root@pve:~# cat /etc/fstab

# <file system> <mount point> <type> <options> <dump> <pass>

/dev/pve/root / ext4 errors=remount-ro 0 1

/dev/pve/swap none swap sw 0 0

proc /proc proc defaults 0 0Ideen was ich machen kann?