Hallo an Alle,

seit ein paar Tagen habe ich bei meinem 3 Node Cluster, immer mal wieder das Problem, dass ich Meldungen in Ceph bekomme, "Slow OSD heartbeats on front" und/oder "Slow OSD heartbeats on back". Mal betrifft es ein oder mehrer OSDs, gerade eben zB nur eines.

Dann verschwindet ab und zu der Node3, kommt aber nach ein paar Augenblicken wieder online.

Auch die OSDs erholen sich nach ein paar Minuten wieder. So bekomme ich etwa alle 10 Minuten eine Melundung von meinem Monitoring, dass Ceph auf allen drei Nodes im "Warning" Zustatnd ist.

Im Netzwerk scheint nicht viel los zu sein. Zumindest sag mein Switch, dass zwischen 10Kbit und 50Mbit verkehr zu den einzelnen Netzwerkkarten an meinen Servern läuft.

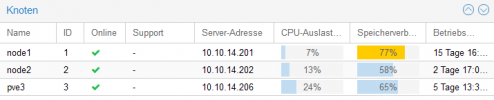

Ich habe ein Cluster mit 3 NUC10 i7, mit jeweils 3 Netzwerkarten (1x die eingebaute und 2x per USB) und je 64GB Ram.

Wie schon erwähnt, hat alles wunderbar funktioniert, bis vor ein paar Tagen. Ich vermute irngendein Update hat dieses Verhalten beeinflusst.

Seither habe ich auch ein kleine Problem mit einer VM auf dem Node3, die ich als Arbeitsmaschine verwende. Ich arbeite per RDP auf dieser VM. Diese VM hängt immer mal wieder für ein paar Sekunden. Das nervt.

Kann mir jemand einen Tipp geben, was ich noch überpüfen kann, um das Problem zu isolieren?

Hier noch ein paar Infos zu meinem Setup:

Kann ich euch noch weitere Infos geben, um dem Problem auf die Spur zu kommen?

Ach ja, bevor ichs noch vergesse, hin und wieder sagt mir der Reiter Ceph, dass einer der Ceph.Monitore eines Hosts probleme hat, dann starte ich am betreffenden Node den Ceph.Monitor neu, danachist alles wieder gut, für ein paar Minuten zumindest. Wenn ich warte erholt sich das von alleine, dauert nur länger.

Danke für eure Hilfe

SG

seit ein paar Tagen habe ich bei meinem 3 Node Cluster, immer mal wieder das Problem, dass ich Meldungen in Ceph bekomme, "Slow OSD heartbeats on front" und/oder "Slow OSD heartbeats on back". Mal betrifft es ein oder mehrer OSDs, gerade eben zB nur eines.

Dann verschwindet ab und zu der Node3, kommt aber nach ein paar Augenblicken wieder online.

Auch die OSDs erholen sich nach ein paar Minuten wieder. So bekomme ich etwa alle 10 Minuten eine Melundung von meinem Monitoring, dass Ceph auf allen drei Nodes im "Warning" Zustatnd ist.

Im Netzwerk scheint nicht viel los zu sein. Zumindest sag mein Switch, dass zwischen 10Kbit und 50Mbit verkehr zu den einzelnen Netzwerkkarten an meinen Servern läuft.

Ich habe ein Cluster mit 3 NUC10 i7, mit jeweils 3 Netzwerkarten (1x die eingebaute und 2x per USB) und je 64GB Ram.

Wie schon erwähnt, hat alles wunderbar funktioniert, bis vor ein paar Tagen. Ich vermute irngendein Update hat dieses Verhalten beeinflusst.

Seither habe ich auch ein kleine Problem mit einer VM auf dem Node3, die ich als Arbeitsmaschine verwende. Ich arbeite per RDP auf dieser VM. Diese VM hängt immer mal wieder für ein paar Sekunden. Das nervt.

Kann mir jemand einen Tipp geben, was ich noch überpüfen kann, um das Problem zu isolieren?

Hier noch ein paar Infos zu meinem Setup:

Code:

root@node1:~# pveversion

pve-manager/6.4-13/9f411e79 (running kernel: 5.4.124-1-pve)

Bash:

root@node1:~# ceph status

cluster:

id: b79bb86c-3744-4cb9-8bd0-ac3d5a50c082

health: HEALTH_WARN

Slow OSD heartbeats on back (longest 1744.981ms)

Slow OSD heartbeats on front (longest 2386.341ms)

1 slow ops, oldest one blocked for 483 sec, mon.node1 has slow ops

services:

mon: 3 daemons, quorum node1,node2,pve3 (age 66s)

mgr: node2(active, since 6d), standbys: node1, pve3

mds: 3 up:standby

osd: 3 osds: 3 up (since 8m), 3 in (since 3w)

task status:

data:

pools: 3 pools, 161 pgs

objects: 307.29k objects, 1.1 TiB

usage: 3.3 TiB used, 2.3 TiB / 5.6 TiB avail

pgs: 161 active+clean

io:

client: 55 KiB/s rd, 6.0 MiB/s wr, 5 op/s rd, 96 op/s wrKann ich euch noch weitere Infos geben, um dem Problem auf die Spur zu kommen?

Ach ja, bevor ichs noch vergesse, hin und wieder sagt mir der Reiter Ceph, dass einer der Ceph.Monitore eines Hosts probleme hat, dann starte ich am betreffenden Node den Ceph.Monitor neu, danachist alles wieder gut, für ein paar Minuten zumindest. Wenn ich warte erholt sich das von alleine, dauert nur länger.

Danke für eure Hilfe

SG

Last edited: