Ich persönlich würde das mit dem Datenverzeichnis übrigens so machen:

1.) eine leere HDD nehmen und da wie zuvor für die BackupHDD eine ext4 Partition anlegen

2.) die Partition dann wie zuvor über die fstab auf dem Proxmox Host mounten (z.B. nach /mnt/NC-data). Einen Storage muss du dann nicht erstellen, weil Proxmox die HDD nicht selbst nutzen muss

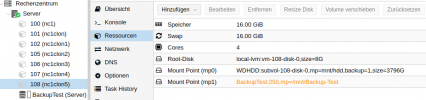

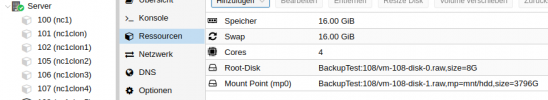

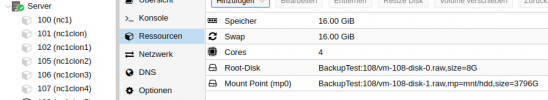

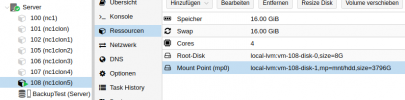

3.) Dann den Ordner /mnt/NC-data vom Host per bind-mount in den Nextcloud-LXC bringen. Dafür erstellt man einen neuen mp0 der dann etwa so aussieht:

mp0: /mnt/NC-data,mp=/mnt/hdd,mountoptions=noatime

Wenn man dann im LXC auf den Ordner "/mnt/hdd" zugreift, dann greift man in Wirklichkeit auf den Ordner "/mnt/NC-data" auf dem Host zu welcher ja wiederum direkt auf die ext4-Partition der HDD verweist. So landet dann alles was du im LXC unter /mnt/NC-data" schreibst direkt physisch auf der ext4-Partition ohne irgendwelche Virtualisierung mit virtuellen HDDs dazwischen.

4.) Wenn das ein unprivilegierter LXC ist wird es dann etwas kompliziert, weil man die Rechte anpassen muss. Entweder man macht dann mit

chmod -R 0777 /mnt/NC-data die Partition für wirklich jeden les-/beschreibbar oder man ändert das User Remapping wie

hier beschrieben (was aber ein ziemlicher Krampf ist aber sicherer wäre), dass da der Nextcloud-User innerhalb des LXC die Rechte hätte etwas auf dem Host unter "/mnt/NC-data" zu schreiben

5.) Dann sollte die Nextcloud im LXC eigentlich direkt auf die ext4 Partition schreiben dürfen.

6.) Da bind-mounts über VZdump nicht mitgesichert werden musst du da anderweitig für sorgen, dass du immer ein aktuelles Backup deines Nextcloud-Datenverzeichnisses hast. Dafür würde sich wie schon gesagt z.B. rsync oder besser noch

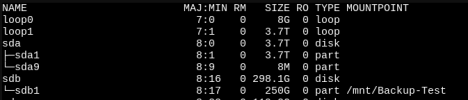

rdiff anbieten. Da könnte man z.B. auf der Backup-Partition "/mnt/Backup-Test" einen neuen Unterornder wie "/mnt/Backup-Test/NC-data-backup" anlegen.

7.) Dann erstellt man einen Cron-Job der täglich rsync oder rdiff aufruft und alles von dem Ordner "/mnt/NC-data" nach "/mnt/Backup-Test/NC-data-backup" sichert. Das sollte dann super schnell gehen, da echt nur die Änderungen zum vorherigen Tag gesichert werden müssen und nicht immer alles komplett neu. Mit rsync hätte man quasi immer nur eine aktuelle Kopie die identisch mit dem Quellordner ist. Das schützt dann vor Verlust, wenn mal eine HDD komplett ausfällt, aber nicht, falls ein Fehler oder eigene Dummheit etwas ausversehen zerstört/löscht. Mit rdiff könnte man auch ältere Stände wiederherstellen. Letzteres wäre dann so ähnlich wie mit Snapshots, wo man dann auch noch an Daten kommt die man z.B. bereits vor einer Woche oder so geändert/gelöscht hatte, was dann noch einmal die Datensicherheit erhöhen würde.

Und wenn dir die Daten wirklich wichtig sind würde ich statt ext4 auch empfehlen ein sichereres Dateisystem wie ZFS zu benutzen. Dann hättest du auch mit einem ZFS Mirror z.B. Ausfallsicherheit und nichts passiert und alles läuft normal weiter, wenn da mal eine HDD den Geist aufgibt, deine Daten würden nicht mehr unbemerkt über die Jahre selbstständig kaputt gehen (bit rot) und ZFS erstellt Prüfsummen von allen Daten und gleicht die Regelmäßig ab. Wenn da dann Fehler entdeckt werden und Daten korrumpiert wurden, dann kann sich ZFS selber heilen und die Schäden über Paritätsdaten wieder reparieren. Auch würde man sich alles mit rsync und rdiff sparen können, da ZFS Replikation und Snapshots unterstützt. Und ZFS kann Kompression auf Blockebene und alles was deine Nextcloud speichert würde automatisch komprimiert werden, selbst wenn Nextcloud selbst keine Kompression unterstützt.

Dann bräuchtest du aber auch die HDDs doppelt für den Mirror (Raid1), so gute 8 GB RAM die rein für ZFS draufgehen und die HDDs sollten kein SMR nutzen (genertell sollten SMR HDDs verboten werden...^^).

Und ein Backup sollte man dann trotzdem noch machen, da Raid nie ein Backup ersetzt.

Der Punkt ist aber...ohne ein fortschrittliches Dateisystem wie ZFS weißt du nie ob deine Dateien wirklich noch heil sind. Dann hast du mit ext4 oder sonst etwas zwar ein Backup und kannst das wiederherstellen, wenn mal eine HDD kaputt geht, es kann aber sein, dass da auch eine Datei in allen Backups bereits korrumpiert ist, da die schon vor 2 Jahren kaputt ging und du es nur nie bemerkt hast. Oder kurz...Backups sind nett, aber 100% verlassen kann man sich auf die auch nicht, wenn man nicht weiß, ob alle Dateien überhaupt noch heil sind bevor man von ihnen ein Backup erstellt.

Ist dann halt die Frage ob du willst das 100% deiner Dateien sicher sind oder ob es dich auch nicht stört, wenn da vielleicht jede 10.000ste Datei unbemerkt kaputt geht und für immer verloren ist da auch keine Backups helfen.