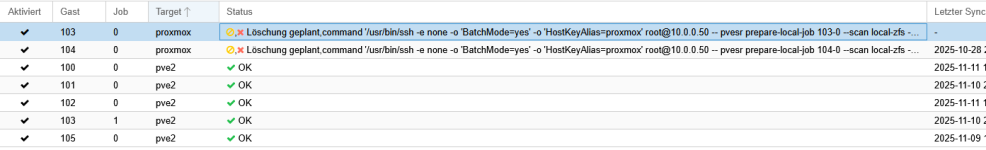

1.) mehr gibts leider nicht

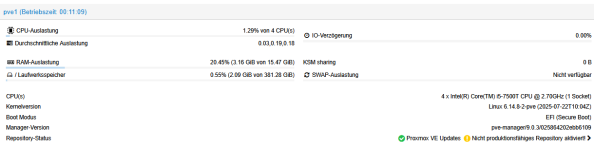

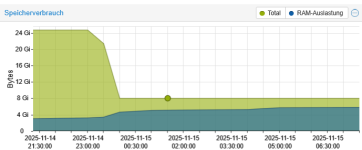

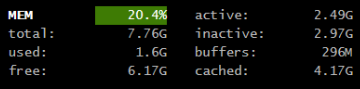

2.)

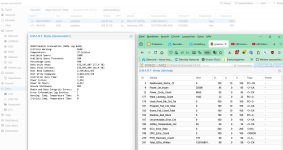

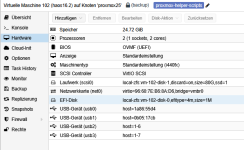

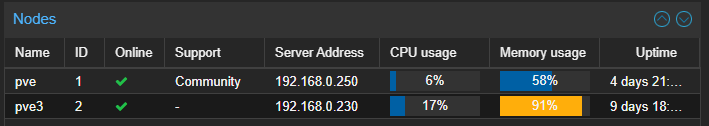

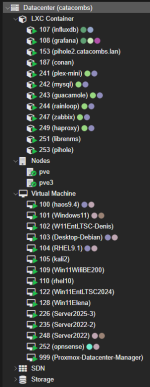

4.)

kann ich das ändern ?

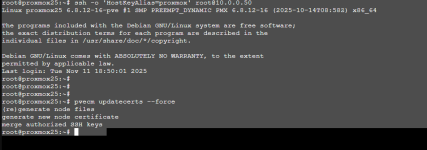

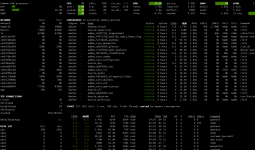

Code:

root@proxmox25:~# /usr/bin/ssh -e none -o 'BatchMode=yes' -o 'HostKeyAlias=proxmox' root@10.0.0.50

Host key verification failed.2.)

Code:

root@pve2:~# lsblk -o+FSTYPE,LABEL,MODEL

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS FSTYPE LABEL MODEL

sda 8:0 0 476.9G 0 disk TS512GMTS430S

├─sda1 8:1 0 1007K 0 part

├─sda2 8:2 0 1G 0 part vfat

└─sda3 8:3 0 199G 0 part zfs_member rpool

zd0 230:0 0 1M 0 disk

zd16 230:16 0 80G 0 disk

├─zd16p1 230:17 0 32M 0 part vfat hassos-boot

├─zd16p2 230:18 0 24M 0 part squashfs

├─zd16p3 230:19 0 256M 0 part erofs

├─zd16p4 230:20 0 24M 0 part squashfs

├─zd16p5 230:21 0 256M 0 part erofs

├─zd16p6 230:22 0 8M 0 part

├─zd16p7 230:23 0 96M 0 part ext4 hassos-overlay

└─zd16p8 230:24 0 79.3G 0 part ext4 hassos-data

zd32 230:32 0 1M 0 disk

zd48 230:48 0 80G 0 disk

├─zd48p1 230:49 0 32M 0 part vfat hassos-boot

├─zd48p2 230:50 0 24M 0 part squashfs

├─zd48p3 230:51 0 256M 0 part erofs

├─zd48p4 230:52 0 24M 0 part squashfs

├─zd48p5 230:53 0 256M 0 part erofs

├─zd48p6 230:54 0 8M 0 part

├─zd48p7 230:55 0 96M 0 part ext4 hassos-overlay

└─zd48p8 230:56 0 79.3G 0 part ext4 hassos-data4.)

kann ich das ändern ?