Hi Leute,

ich bin gerade meine Speicherkonfiguration durchgegangen und dabei kam mir eine Frage auf.

Wir kann ich mir die Netto und Brutto Kapazität meines ZFS Speichers anschauen?

ZFS Version:

zfs-0.8.4-pve2

zfs-kmod-0.8.4-pve1

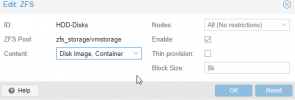

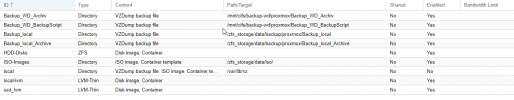

Ich habe folgendes Setup.

3 Festplatten à 1,8TB als RAIDZ1 konfiguriert.

1 SSD als Cache.

Nun würde ich erwarten, dass sich daraus 5,4 TB Brutto und 3,6 TB Netto ergeben.

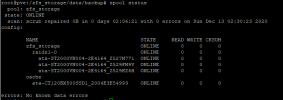

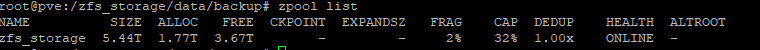

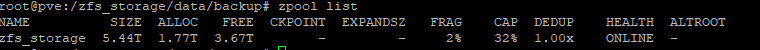

Was sich auch beim Befehl "zpool list" widerspiegelt.

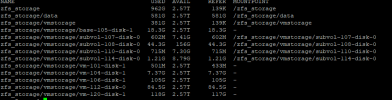

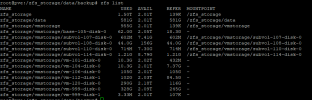

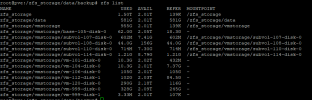

Beim Befehl "zfs list" kommt aber folgendes raus.

Hier steht nun das "zfs_storage" 2,01 TB verfügbar hat.

Mir ist klar, dass bei "zpoo list" der Brutto Speicher angezeigt wird.

Ich hätte aber erwartet, dass bei "zfs list" dann der Netto Speicher stehen würde.

Kann mir jemand erklären woran das liegt?

Danke und Gruß

T

ich bin gerade meine Speicherkonfiguration durchgegangen und dabei kam mir eine Frage auf.

Wir kann ich mir die Netto und Brutto Kapazität meines ZFS Speichers anschauen?

ZFS Version:

zfs-0.8.4-pve2

zfs-kmod-0.8.4-pve1

Ich habe folgendes Setup.

3 Festplatten à 1,8TB als RAIDZ1 konfiguriert.

1 SSD als Cache.

Nun würde ich erwarten, dass sich daraus 5,4 TB Brutto und 3,6 TB Netto ergeben.

Was sich auch beim Befehl "zpool list" widerspiegelt.

Beim Befehl "zfs list" kommt aber folgendes raus.

Hier steht nun das "zfs_storage" 2,01 TB verfügbar hat.

Mir ist klar, dass bei "zpoo list" der Brutto Speicher angezeigt wird.

Ich hätte aber erwartet, dass bei "zfs list" dann der Netto Speicher stehen würde.

Kann mir jemand erklären woran das liegt?

Danke und Gruß

T