Hallo,

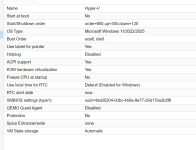

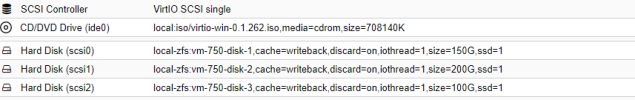

ich starte gerade nochmal den Versuch, Hyper-V unter PVE virtualisiert einzusetzen. Ich habe das schon einmal erfolglos versucht (damals mit Windows Server 2022: https://forum.proxmox.com/threads/hyper-v-unter-proxmox-ve.151919/), nun also auf ein Neues.

Ich wollte nun von Windows Server 2025 Standard inkl. Desktopdarstellung starten, und meine ersten Versuche waren nicht nur ferfolglos, sondern erinnerten mich auch an den damaligen Hyper-V-Versuch. Mal schauen.

Ich lege hier los:

Ich hatte jeweils die VirtIO-treiber hinzugefügt, Windows Updates installiert. Dann kam nach Neustarts nur noch kurz das Proxmox-Logo, und die Maschine startete immer wieder neu. Im Abgesicherten Modus mit Netzwerktreibern funktionierte das System.

Jetzt also systematisch. Zuerst: Hat hier schon jemand einen Windows Server 2025 unter PVE virtualisiert?

Ups... jetzt startet das frische System schon nicht mehr, nachdem ich nur den Hostnamen geändert habe. Letzte Woche trat dieser Effekt erst nach mehreren Neustarts auf, während derer ich die VirtIO-treiber hinzugefügt und für Internetverbindung gesorgt hatte. Habe ich jetzt alles noch nicht gemacht. Abgesicherter Modus mit Netzwerk funktioniert.

ich starte gerade nochmal den Versuch, Hyper-V unter PVE virtualisiert einzusetzen. Ich habe das schon einmal erfolglos versucht (damals mit Windows Server 2022: https://forum.proxmox.com/threads/hyper-v-unter-proxmox-ve.151919/), nun also auf ein Neues.

Ich wollte nun von Windows Server 2025 Standard inkl. Desktopdarstellung starten, und meine ersten Versuche waren nicht nur ferfolglos, sondern erinnerten mich auch an den damaligen Hyper-V-Versuch. Mal schauen.

Ich lege hier los:

- pve-manager/8.2.8

- Linux 6.11.0-1-pve

- 48 x Intel(R) Xeon(R) Gold 5412U (1 Socket)

Ich hatte jeweils die VirtIO-treiber hinzugefügt, Windows Updates installiert. Dann kam nach Neustarts nur noch kurz das Proxmox-Logo, und die Maschine startete immer wieder neu. Im Abgesicherten Modus mit Netzwerktreibern funktionierte das System.

Jetzt also systematisch. Zuerst: Hat hier schon jemand einen Windows Server 2025 unter PVE virtualisiert?

Ups... jetzt startet das frische System schon nicht mehr, nachdem ich nur den Hostnamen geändert habe. Letzte Woche trat dieser Effekt erst nach mehreren Neustarts auf, während derer ich die VirtIO-treiber hinzugefügt und für Internetverbindung gesorgt hatte. Habe ich jetzt alles noch nicht gemacht. Abgesicherter Modus mit Netzwerk funktioniert.

Last edited: