Hallo

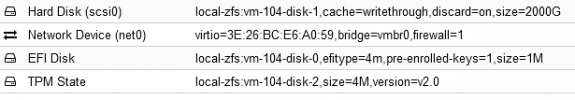

Ich habe ein Problem mit Windows Server 2022 Standard. Es gibt 3 davon. Jedes dieser Systeme schaltet sich über den Tag weg mindestens 2 Mal ab. Und zwar so, dass das System einfach aus geht, ohne herunterzufahren. In der Ereignisanzeige steht nur, dass das System zuvor unerwartet heruntergefahren wurde. Das System ist ein Produktivsystem. Ich habe die deutsche iso benutzt mit pc-q35-5.1. 6.2 funktionieren die Netzwerkadapter nicht, was hier im Forum schon oft besprochen wurde. Ich habe nur den Guest Agent installiert aus virtio win 0215. Hardware Einstellungen und Optionen in Anlage. Ich benutze V7.2.3. Was mir noch aufgefallen war, dass die Systeme zuvor ca. über 4 Wochen stabil gelaufen sind, mit den gleichen Einstellungen, danach ging es dann los mit den unerwarteten Ereignissen, dass die Systeme sich einfach abschalten.

Ich weiss mir jetzt bald nicht mehr zu helfen. Bei Server 2019, Win10 oder Win11 habe ich diese Problematiken nicht. Die laufen stabil.

Gibt es jemand, der weiss was man einstellen oder noch konfigurieren muss?

Wie müssen die Bios Einstellungen aussehen?

Danke

Ich habe ein Problem mit Windows Server 2022 Standard. Es gibt 3 davon. Jedes dieser Systeme schaltet sich über den Tag weg mindestens 2 Mal ab. Und zwar so, dass das System einfach aus geht, ohne herunterzufahren. In der Ereignisanzeige steht nur, dass das System zuvor unerwartet heruntergefahren wurde. Das System ist ein Produktivsystem. Ich habe die deutsche iso benutzt mit pc-q35-5.1. 6.2 funktionieren die Netzwerkadapter nicht, was hier im Forum schon oft besprochen wurde. Ich habe nur den Guest Agent installiert aus virtio win 0215. Hardware Einstellungen und Optionen in Anlage. Ich benutze V7.2.3. Was mir noch aufgefallen war, dass die Systeme zuvor ca. über 4 Wochen stabil gelaufen sind, mit den gleichen Einstellungen, danach ging es dann los mit den unerwarteten Ereignissen, dass die Systeme sich einfach abschalten.

Ich weiss mir jetzt bald nicht mehr zu helfen. Bei Server 2019, Win10 oder Win11 habe ich diese Problematiken nicht. Die laufen stabil.

Gibt es jemand, der weiss was man einstellen oder noch konfigurieren muss?

Wie müssen die Bios Einstellungen aussehen?

Danke