Moin,

da mein Hauptpost anscheinend zu umfangreich ist, mal nur eine Teilfrage:

Welche Arten von RAID gibt es unter Proxmox und was sind die Vor-Nachteile des jeweiligen?

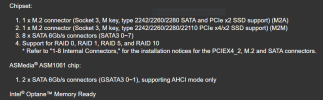

Explizit habe ich ein GIGABYTE C246M-WU4. Auf diesem sind 2 Western Digital Red SN700 NVMe NAS SSD - 1DWPD 1TB, M.2 (WDS100T1R0C) installiert und 8 SATA Ports.

Es sollen 2-3 VMs drauf laufen. Meine Idee war, die M2-SSD in einen RAID1 zu packen und dort die VMs laufen zu lassen. Die SATA-Platten sollen als NAS fungieren. Dazu hätte ich eine VM mit passender SW (unraid, Nextcloud,...) aufgesetzt und die Platten dann an die VM durchgereicht, damit die mit diesen ein RAID5 als NAS aufbaut.

Oder habe ich da eine völlig sinnfreie Konfiguration im Kopf?

mfG

Rene?

da mein Hauptpost anscheinend zu umfangreich ist, mal nur eine Teilfrage:

Welche Arten von RAID gibt es unter Proxmox und was sind die Vor-Nachteile des jeweiligen?

Explizit habe ich ein GIGABYTE C246M-WU4. Auf diesem sind 2 Western Digital Red SN700 NVMe NAS SSD - 1DWPD 1TB, M.2 (WDS100T1R0C) installiert und 8 SATA Ports.

Es sollen 2-3 VMs drauf laufen. Meine Idee war, die M2-SSD in einen RAID1 zu packen und dort die VMs laufen zu lassen. Die SATA-Platten sollen als NAS fungieren. Dazu hätte ich eine VM mit passender SW (unraid, Nextcloud,...) aufgesetzt und die Platten dann an die VM durchgereicht, damit die mit diesen ein RAID5 als NAS aufbaut.

Oder habe ich da eine völlig sinnfreie Konfiguration im Kopf?

mfG

Rene?