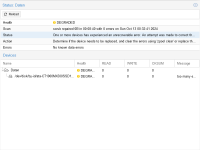

root@pve01:~# zpool clear Daten

root@pve01:~# zpool status

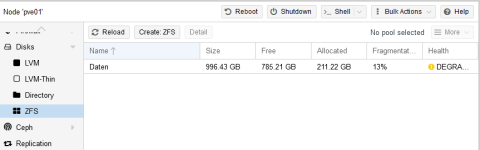

pool: Daten

state: ONLINE

scan: scrub repaired 0B in 00:08:40 with 0 errors on Sun Oct 13 00:32:41 2024

config:

NAME STATE READ WRITE CKSUM

Daten ONLINE 0 0 0

ata-CT1000MX500SSD1_2136E5CF4504 ONLINE 0 0 0

errors: No known data errors

root@pve01:~# zpool list -v

NAME SIZE ALLOC FREE CKPOINT EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT

Daten 928G 197G 731G - - 13% 21% 1.00x ONLINE -

ata-CT1000MX500SSD1_2136E5CF4504 932G 197G 731G - - 13% 21.2% - ONLINE

root@pve01:~# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 931.5G 0 disk

├─sda1 8:1 0 931.5G 0 part

└─sda9 8:9 0 8M 0 part

zd0 230:0 0 128G 0 disk

├─zd0p1 230:1 0 50M 0 part

└─zd0p2 230:2 0 127.9G 0 part

zd16 230:16 0 16.5G 0 disk

zd32 230:32 0 128G 0 disk

├─zd32p1 230:33 0 100M 0 part

├─zd32p2 230:34 0 16M 0 part

├─zd32p3 230:35 0 127.1G 0 part

└─zd32p4 230:36 0 837M 0 part

zd48 230:48 0 1M 0 disk

zd64 230:64 0 1M 0 disk

nvme0n1 259:0 0 238.5G 0 disk

├─nvme0n1p1 259:1 0 1007K 0 part

├─nvme0n1p2 259:2 0 1G 0 part /boot/efi

└─nvme0n1p3 259:3 0 237.5G 0 part

├─pve-swap 252:0 0 8G 0 lvm [SWAP]

├─pve-root 252:1 0 69.4G 0 lvm /

├─pve-data_tmeta 252:2 0 1.4G 0 lvm

│ └─pve-data 252:4 0 141.2G 0 lvm

└─pve-data_tdata 252:3 0 141.2G 0 lvm

└─pve-data 252:4 0 141.2G 0 lvm

root@pve01:~# ls -lA /dev/disk/by-id/

total 0

lrwxrwxrwx 1 root root 9 Nov 17 02:08 ata-CT1000MX500SSD1_2136E5CF4504 -> ../../sda

lrwxrwxrwx 1 root root 10 Nov 17 02:08 ata-CT1000MX500SSD1_2136E5CF4504-part1 -> ../../sda1

lrwxrwxrwx 1 root root 10 Nov 17 02:08 ata-CT1000MX500SSD1_2136E5CF4504-part9 -> ../../sda9

lrwxrwxrwx 1 root root 10 Nov 17 02:08 dm-name-pve-root -> ../../dm-1

lrwxrwxrwx 1 root root 10 Nov 17 02:08 dm-name-pve-swap -> ../../dm-0

lrwxrwxrwx 1 root root 10 Nov 17 02:08 dm-uuid-LVM-lefS9MQw30amz5XoxQM18FUb85oqGIw83CAsANb7w1wnXqeMxIkTz81PGsHOwRUe -> ../../dm-0

lrwxrwxrwx 1 root root 10 Nov 17 02:08 dm-uuid-LVM-lefS9MQw30amz5XoxQM18FUb85oqGIw8UeV5AjCvkN2DM8lTLR63irsvqgyVVffp -> ../../dm-1

lrwxrwxrwx 1 root root 15 Nov 17 02:08 lvm-pv-uuid-brjiJB-yyZQ-9AR6-omIg-mcT4-UBWf-3xh4kE -> ../../nvme0n1p3

lrwxrwxrwx 1 root root 13 Nov 17 02:08 nvme-eui.001b444a493f66c4 -> ../../nvme0n1

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-eui.001b444a493f66c4-part1 -> ../../nvme0n1p1

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-eui.001b444a493f66c4-part2 -> ../../nvme0n1p2

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-eui.001b444a493f66c4-part3 -> ../../nvme0n1p3

lrwxrwxrwx 1 root root 13 Nov 17 02:08 nvme-WDC_PC_SN530_SDBPMPZ-256G-1001_22203S476208 -> ../../nvme0n1

lrwxrwxrwx 1 root root 13 Nov 17 02:08 nvme-WDC_PC_SN530_SDBPMPZ-256G-1001_22203S476208_1 -> ../../nvme0n1

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-WDC_PC_SN530_SDBPMPZ-256G-1001_22203S476208_1-part1 -> ../../nvme0n1p1

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-WDC_PC_SN530_SDBPMPZ-256G-1001_22203S476208_1-part2 -> ../../nvme0n1p2

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-WDC_PC_SN530_SDBPMPZ-256G-1001_22203S476208_1-part3 -> ../../nvme0n1p3

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-WDC_PC_SN530_SDBPMPZ-256G-1001_22203S476208-part1 -> ../../nvme0n1p1

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-WDC_PC_SN530_SDBPMPZ-256G-1001_22203S476208-part2 -> ../../nvme0n1p2

lrwxrwxrwx 1 root root 15 Nov 17 02:08 nvme-WDC_PC_SN530_SDBPMPZ-256G-1001_22203S476208-part3 -> ../../nvme0n1p3

lrwxrwxrwx 1 root root 9 Nov 17 02:08 wwn-0x500a0751e5cf4504 -> ../../sda

lrwxrwxrwx 1 root root 10 Nov 17 02:08 wwn-0x500a0751e5cf4504-part1 -> ../../sda1

lrwxrwxrwx 1 root root 10 Nov 17 02:08 wwn-0x500a0751e5cf4504-part9 -> ../../sda9