Hallo Zusammen,

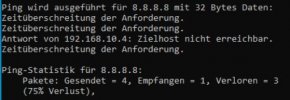

der Neuling mal wieder... seit Taaagen versuche ich ohne Erfolg VMs oder LXCs ins Internet zu bekommen. Eine lokale IP bekommen die VMs/LXCs jeweils. Pingen geht auch. Aber kein Internet...

Ich kopier mal was hier rein.. ip addr & nano /etc/network/interfaces.. Ein Kumpel sagte, dass soweit alles in Ordnung aussieht.

und

Jemand eine Idee? Ist ein Intel Nuc mit 2 Netzwerkkarten..

Besten Dank für Eure Unterstützung.

kevo

der Neuling mal wieder... seit Taaagen versuche ich ohne Erfolg VMs oder LXCs ins Internet zu bekommen. Eine lokale IP bekommen die VMs/LXCs jeweils. Pingen geht auch. Aber kein Internet...

Ich kopier mal was hier rein.. ip addr & nano /etc/network/interfaces.. Ein Kumpel sagte, dass soweit alles in Ordnung aussieht.

Code:

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: enp87s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq master vmbr0 state UP group default qlen 1000

link/ether 54:b2:03:9e:e2:c5 brd ff:ff:ff:ff:ff:ff

3: enp88s0: <BROADCAST,MULTICAST> mtu 1500 qdisc noop state DOWN group default qlen 1000

link/ether 54:b2:03:9e:d2:7f brd ff:ff:ff:ff:ff:ff

4: wlo1: <BROADCAST,MULTICAST> mtu 1500 qdisc noop state DOWN group default qlen 1000

link/ether 90:cc:df:1e:32:fa brd ff:ff:ff:ff:ff:ff

5: vmbr0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default qlen 1000

link/ether 54:b2:03:9e:e2:c5 brd ff:ff:ff:ff:ff:ff

inet 192.168.10.2/24 scope global vmbr0

valid_lft forever preferred_lft forever

inet6 fe80::56b2:3ff:fe9e:e2c5/64 scope link

valid_lft forever preferred_lft forever

30: veth101i0@if2: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master fwbr101i0 state UP group default qlen 1000

link/ether fe:fa:b1:2c:2a:26 brd ff:ff:ff:ff:ff:ff link-netnsid 0

31: fwbr101i0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default qlen 1000

link/ether 62:df:0e:58:5e:7d brd ff:ff:ff:ff:ff:ff

32: fwpr101p0@fwln101i0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master vmbr0 state UP group default qlen 1000

link/ether aa:db:b6:b8:de:99 brd ff:ff:ff:ff:ff:ff

33: fwln101i0@fwpr101p0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master fwbr101i0 state UP group default qlen 1000

link/ether 62:df:0e:58:5e:7d brd ff:ff:ff:ff:ff:ffund

Code:

auto lo

iface lo inet loopback

auto enp87s0

iface enp87s0 inet manual

#Haupt-LAN

iface enp88s0 inet manual

auto vmbr0

iface vmbr0 inet static

address 192.168.10.2/24

gateway 192.168.10.1

bridge-ports enp87s0

bridge-stp off

bridge-fd 0Jemand eine Idee? Ist ein Intel Nuc mit 2 Netzwerkkarten..

Besten Dank für Eure Unterstützung.

kevo