Hallo zusammen,

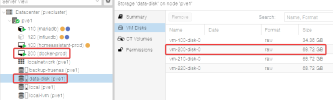

ich betreibe aktuell drei PVE nodes (8.0.4 mit aktuellen Updates, keine SubscriptioN) und auf einem liegt die VM200 (docker-prod) basierend auf Ubuntu 22.04 LTS.

Die VM läuft soweit reibungslos, aber ich habe ein bzw. zwei Probleme.

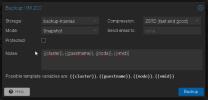

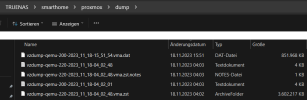

Es klappt nicht, dass ich auf TrueNAS (SMB/CFIS) ein Backup der VM mache. Es kommt immer folgende Fehlermeldung. Das immer bei ~ 16,7-9 GB und das finde ich schon recht verdächtig:

Nun habe ich etwas recherchiert, aber leider finde ich keine Anleitung wie ich hier vorgehen kann um z.B. die Festplatte zu prüfen.

Infos:

Zweites Problem: Ich kann die VM auch nicht replizieren. Dazu kommt immer folgender Fehler:

Welche Informationen kann ich noch bereitstellen um dazu eine Lösung zu finden?

Viele Grüße und einen schönen Samstag,

Buddinski88

ich betreibe aktuell drei PVE nodes (8.0.4 mit aktuellen Updates, keine SubscriptioN) und auf einem liegt die VM200 (docker-prod) basierend auf Ubuntu 22.04 LTS.

Die VM läuft soweit reibungslos, aber ich habe ein bzw. zwei Probleme.

Es klappt nicht, dass ich auf TrueNAS (SMB/CFIS) ein Backup der VM mache. Es kommt immer folgende Fehlermeldung. Das immer bei ~ 16,7-9 GB und das finde ich schon recht verdächtig:

Code:

INFO: Starting Backup of VM 200 (qemu)

INFO: Backup started at 2023-11-18 04:02:01

INFO: status = running

INFO: VM Name: docker-prod

INFO: include disk 'scsi0' 'data-disk:vm-200-disk-0' 64G

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: creating vzdump archive '/mnt/pve/backup-truenas/dump/vzdump-qemu-200-2023_11_18-04_02_01.vma.zst'

INFO: started backup task 'c500f276-c2c7-488e-8fd4-4ffe7964b923'

INFO: resuming VM again

INFO: 3% (2.2 GiB of 64.0 GiB) in 3s, read: 763.7 MiB/s, write: 330.8 MiB/s

INFO: 4% (2.8 GiB of 64.0 GiB) in 6s, read: 203.0 MiB/s, write: 200.1 MiB/s

INFO: 5% (3.5 GiB of 64.0 GiB) in 9s, read: 235.6 MiB/s, write: 232.0 MiB/s

INFO: 6% (4.2 GiB of 64.0 GiB) in 12s, read: 244.1 MiB/s, write: 238.0 MiB/s

INFO: 7% (4.9 GiB of 64.0 GiB) in 15s, read: 234.4 MiB/s, write: 231.7 MiB/s

INFO: 8% (5.4 GiB of 64.0 GiB) in 18s, read: 170.4 MiB/s, write: 164.9 MiB/s

INFO: 9% (6.0 GiB of 64.0 GiB) in 21s, read: 188.5 MiB/s, write: 187.2 MiB/s

INFO: 10% (6.6 GiB of 64.0 GiB) in 24s, read: 203.0 MiB/s, write: 202.4 MiB/s

INFO: 11% (7.1 GiB of 64.0 GiB) in 27s, read: 181.2 MiB/s, write: 181.1 MiB/s

INFO: 12% (7.8 GiB of 64.0 GiB) in 31s, read: 177.6 MiB/s, write: 176.6 MiB/s

INFO: 13% (8.5 GiB of 64.0 GiB) in 34s, read: 229.6 MiB/s, write: 220.5 MiB/s

INFO: 14% (9.0 GiB of 64.0 GiB) in 37s, read: 198.2 MiB/s, write: 195.2 MiB/s

INFO: 15% (9.6 GiB of 64.0 GiB) in 40s, read: 191.7 MiB/s, write: 191.4 MiB/s

INFO: 16% (10.3 GiB of 64.0 GiB) in 43s, read: 227.6 MiB/s, write: 224.0 MiB/s

INFO: 17% (10.9 GiB of 64.0 GiB) in 46s, read: 211.5 MiB/s, write: 210.8 MiB/s

INFO: 18% (11.8 GiB of 64.0 GiB) in 49s, read: 316.6 MiB/s, write: 206.0 MiB/s

INFO: 19% (12.5 GiB of 64.0 GiB) in 52s, read: 238.0 MiB/s, write: 233.5 MiB/s

INFO: 20% (13.3 GiB of 64.0 GiB) in 55s, read: 257.4 MiB/s, write: 256.2 MiB/s

INFO: 21% (13.9 GiB of 64.0 GiB) in 58s, read: 228.4 MiB/s, write: 224.8 MiB/s

INFO: 22% (14.6 GiB of 64.0 GiB) in 1m 1s, read: 239.2 MiB/s, write: 233.5 MiB/s

INFO: 23% (15.3 GiB of 64.0 GiB) in 1m 4s, read: 220.6 MiB/s, write: 219.2 MiB/s

INFO: 24% (15.9 GiB of 64.0 GiB) in 1m 7s, read: 204.7 MiB/s, write: 203.9 MiB/s

INFO: 25% (16.5 GiB of 64.0 GiB) in 1m 10s, read: 222.3 MiB/s, write: 222.1 MiB/s

INFO: 26% (16.9 GiB of 64.0 GiB) in 1m 13s, read: 127.9 MiB/s, write: 127.8 MiB/s

ERROR: job failed with err -5 - Input/output error

INFO: aborting backup job

INFO: resuming VM again

ERROR: Backup of VM 200 failed - job failed with err -5 - Input/output error

INFO: Failed at 2023-11-18 04:03:39

INFO: Backup job finished with errors

TASK ERROR: job errorsNun habe ich etwas recherchiert, aber leider finde ich keine Anleitung wie ich hier vorgehen kann um z.B. die Festplatte zu prüfen.

Infos:

- Es liegen noch eine andere VM sowie zwei Container auf dem Node. Beide lassen sich problemlos sichern.

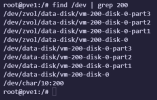

- Die Festplatten liegen auf einem ZFS Share "data-disk". Das wiederum ist jeweils eine 1TB SSD innerhalb der NUCs.

Zweites Problem: Ich kann die VM auch nicht replizieren. Dazu kommt immer folgender Fehler:

Code:

2023-11-18 14:07:02 200-0: start replication job

2023-11-18 14:07:02 200-0: guest => VM 200, running => 2432148

2023-11-18 14:07:02 200-0: volumes => data-disk:vm-200-disk-0

2023-11-18 14:07:03 200-0: create snapshot '__replicate_200-0_1700312822__' on data-disk:vm-200-disk-0

2023-11-18 14:07:03 200-0: using secure transmission, rate limit: none

2023-11-18 14:07:03 200-0: full sync 'data-disk:vm-200-disk-0' (__replicate_200-0_1700312822__)

2023-11-18 14:07:04 200-0: full send of data-disk/vm-200-disk-0@__replicate_200-0_1700312822__ estimated size is 62.6G

2023-11-18 14:07:04 200-0: total estimated size is 62.6G

2023-11-18 14:07:05 200-0: TIME SENT SNAPSHOT data-disk/vm-200-disk-0@__replicate_200-0_1700312822__

2023-11-18 14:07:05 200-0: 14:07:05 80.4M data-disk/vm-200-disk-0@__replicate_200-0_1700312822__

2023-11-18 14:07:06 200-0: 14:07:06 192M data-disk/vm-200-disk-0@__replicate_200-0_1700312822__

2023-11-18 14:07:07 200-0: 14:07:07 303M data-disk/vm-200-disk-0@__replicate_200-0_1700312822__

2023-11-18 14:07:08 200-0: 14:07:08 414M data-disk/vm-200-disk-0@__replicate_200-0_1700312822__

...

2023-11-18 14:09:29 200-0: 14:09:29 15.7G data-disk/vm-200-disk-0@__replicate_200-0_1700312822__

2023-11-18 14:09:30 200-0: warning: cannot send 'data-disk/vm-200-disk-0@__replicate_200-0_1700312822__': Input/output error

2023-11-18 14:09:31 200-0: cannot receive new filesystem stream: checksum mismatch

2023-11-18 14:09:31 200-0: cannot open 'data-disk/vm-200-disk-0': dataset does not exist

2023-11-18 14:09:31 200-0: command 'zfs recv -F -- data-disk/vm-200-disk-0' failed: exit code 1

2023-11-18 14:09:31 200-0: delete previous replication snapshot '__replicate_200-0_1700312822__' on data-disk:vm-200-disk-0

2023-11-18 14:09:31 200-0: end replication job with error: command 'set -o pipefail && pvesm export data-disk:vm-200-disk-0 zfs - -with-snapshots 1 -snapshot __replicate_200-0_1700312822__ | /usr/bin/ssh -e none -o 'BatchMode=yes' -o 'HostKeyAlias=pve2' root@10.10.10.22 -- pvesm import data-disk:vm-200-disk-0 zfs - -with-snapshots 1 -snapshot __replicate_200-0_1700312822__ -allow-rename 0' failed: exit code 1Welche Informationen kann ich noch bereitstellen um dazu eine Lösung zu finden?

Viele Grüße und einen schönen Samstag,

Buddinski88

Last edited: