Hallo,

wir haben seit kurzem unseren ersten Proxmox-Host.

Wir haben folgendes Problem: Bei uns hängen sich die virutellen Maschinen auf.

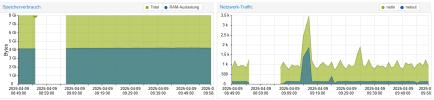

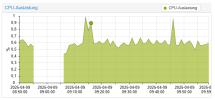

Wenn ich mich auf den Proxmox Knoten verbinde, sieht es so aus, als würden die Maschinen noch laufen. Allerdings wind dann Unterbrechungen in den Grafiken der jeweiligen Maschine. Wir haben mittlerweile, um ein Netzwerkproblem auszuschließen, den ISCSI Speicher direkt verbunden.

Im Anhang findet ihr Screenshots davon.

Im Systemlog findet sich folgender Fehler:

Apr 09 08:56:49 42-v-proxmox1 pvestatd[1414]: status update time (124.260 seconds)

Apr 09 09:04:34 42-v-proxmox1 kernel: connection1:0: detected conn error (1020)

Apr 09 09:04:35 42-v-proxmox1 iscsid[1632]: Kernel reported iSCSI connection 1:0 error (1020 - ISCSI_ERR_TCP_CONN_CLOSE: TCP connection closed) state (3)

Apr 09 09:04:37 42-v-proxmox1 pvestatd[1414]: status update time (467.605 seconds)

Apr 09 09:04:37 42-v-proxmox1 iscsid[1632]: connection1:0 is operational after recovery (1 attempts)

Hier unsere Paketversionen:

proxmox-ve: 8.3.0 (running kernel: 6.8.12-9-pve)pve-manager: 8.3.5 (running version: 8.3.5/dac3aa88bac3f300)proxmox-kernel-helper: 8.1.1proxmox-kernel-6.8: 6.8.12-9proxmox-kernel-6.8.12-9-pve-signed: 6.8.12-9proxmox-kernel-6.8.12-8-pve-signed: 6.8.12-8proxmox-kernel-6.8.4-2-pve-signed: 6.8.4-2ceph: 18.2.4-pve3ceph-fuse: 18.2.4-pve3corosync: 3.1.7-pve3criu: 3.17.1-2+deb12u1glusterfs-client: 10.3-5ifupdown2: 3.2.0-1+pmx11ksm-control-daemon: 1.5-1libjs-extjs: 7.0.0-5libknet1: 1.28-pve1libproxmox-acme-perl: 1.6.0libproxmox-backup-qemu0: 1.5.1libproxmox-rs-perl: 0.3.5libpve-access-control: 8.2.0libpve-apiclient-perl: 3.3.2libpve-cluster-api-perl: 8.0.10libpve-cluster-perl: 8.0.10libpve-common-perl: 8.2.9libpve-guest-common-perl: 5.1.6libpve-http-server-perl: 5.2.0libpve-network-perl: 0.10.1libpve-rs-perl: 0.9.2libpve-storage-perl: 8.3.3libspice-server1: 0.15.1-1lvm2: 2.03.16-2lxc-pve: 6.0.0-1lxcfs: 6.0.0-pve2novnc-pve: 1.5.0-1proxmox-backup-client: 3.3.4-1proxmox-backup-file-restore: 3.3.4-1proxmox-firewall: 0.6.0proxmox-kernel-helper: 8.1.1proxmox-mail-forward: 0.3.1proxmox-mini-journalreader: 1.4.0proxmox-offline-mirror-helper: 0.6.7proxmox-widget-toolkit: 4.3.6pve-cluster: 8.0.10pve-container: 5.2.4pve-docs: 8.3.1pve-edk2-firmware: 4.2023.08-4pve-esxi-import-tools: 0.7.2pve-firewall: 5.1.0pve-firmware: 3.14-3pve-ha-manager: 4.0.6pve-i18n: 3.4.0pve-qemu-kvm: 9.0.2-5pve-xtermjs: 5.3.0-3qemu-server: 8.3.8smartmontools: 7.3-pve1spiceterm: 3.3.0swtpm: 0.8.0+pve1vncterm: 1.8.0zfsutils-linux: 2.2.7-pve2

wir haben seit kurzem unseren ersten Proxmox-Host.

Wir haben folgendes Problem: Bei uns hängen sich die virutellen Maschinen auf.

Wenn ich mich auf den Proxmox Knoten verbinde, sieht es so aus, als würden die Maschinen noch laufen. Allerdings wind dann Unterbrechungen in den Grafiken der jeweiligen Maschine. Wir haben mittlerweile, um ein Netzwerkproblem auszuschließen, den ISCSI Speicher direkt verbunden.

Im Anhang findet ihr Screenshots davon.

Im Systemlog findet sich folgender Fehler:

Apr 09 08:56:49 42-v-proxmox1 pvestatd[1414]: status update time (124.260 seconds)

Apr 09 09:04:34 42-v-proxmox1 kernel: connection1:0: detected conn error (1020)

Apr 09 09:04:35 42-v-proxmox1 iscsid[1632]: Kernel reported iSCSI connection 1:0 error (1020 - ISCSI_ERR_TCP_CONN_CLOSE: TCP connection closed) state (3)

Apr 09 09:04:37 42-v-proxmox1 pvestatd[1414]: status update time (467.605 seconds)

Apr 09 09:04:37 42-v-proxmox1 iscsid[1632]: connection1:0 is operational after recovery (1 attempts)

Hier unsere Paketversionen:

proxmox-ve: 8.3.0 (running kernel: 6.8.12-9-pve)pve-manager: 8.3.5 (running version: 8.3.5/dac3aa88bac3f300)proxmox-kernel-helper: 8.1.1proxmox-kernel-6.8: 6.8.12-9proxmox-kernel-6.8.12-9-pve-signed: 6.8.12-9proxmox-kernel-6.8.12-8-pve-signed: 6.8.12-8proxmox-kernel-6.8.4-2-pve-signed: 6.8.4-2ceph: 18.2.4-pve3ceph-fuse: 18.2.4-pve3corosync: 3.1.7-pve3criu: 3.17.1-2+deb12u1glusterfs-client: 10.3-5ifupdown2: 3.2.0-1+pmx11ksm-control-daemon: 1.5-1libjs-extjs: 7.0.0-5libknet1: 1.28-pve1libproxmox-acme-perl: 1.6.0libproxmox-backup-qemu0: 1.5.1libproxmox-rs-perl: 0.3.5libpve-access-control: 8.2.0libpve-apiclient-perl: 3.3.2libpve-cluster-api-perl: 8.0.10libpve-cluster-perl: 8.0.10libpve-common-perl: 8.2.9libpve-guest-common-perl: 5.1.6libpve-http-server-perl: 5.2.0libpve-network-perl: 0.10.1libpve-rs-perl: 0.9.2libpve-storage-perl: 8.3.3libspice-server1: 0.15.1-1lvm2: 2.03.16-2lxc-pve: 6.0.0-1lxcfs: 6.0.0-pve2novnc-pve: 1.5.0-1proxmox-backup-client: 3.3.4-1proxmox-backup-file-restore: 3.3.4-1proxmox-firewall: 0.6.0proxmox-kernel-helper: 8.1.1proxmox-mail-forward: 0.3.1proxmox-mini-journalreader: 1.4.0proxmox-offline-mirror-helper: 0.6.7proxmox-widget-toolkit: 4.3.6pve-cluster: 8.0.10pve-container: 5.2.4pve-docs: 8.3.1pve-edk2-firmware: 4.2023.08-4pve-esxi-import-tools: 0.7.2pve-firewall: 5.1.0pve-firmware: 3.14-3pve-ha-manager: 4.0.6pve-i18n: 3.4.0pve-qemu-kvm: 9.0.2-5pve-xtermjs: 5.3.0-3qemu-server: 8.3.8smartmontools: 7.3-pve1spiceterm: 3.3.0swtpm: 0.8.0+pve1vncterm: 1.8.0zfsutils-linux: 2.2.7-pve2