Hallo zusammen,

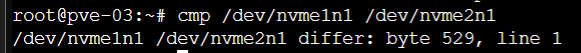

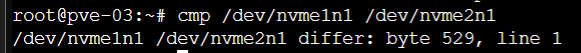

Ich habe einen ZFS Mirror Pool auf einem Proxmox-Server mit der ZFS-Version 2.1.12-pve1 eingerichtet. Der Pool (rpool) besteht aus zwei NVMe-Festplatten, die als Mirror konfiguriert sind. Nach dem Vergleich der beiden Festplatten mit dem Befehl cmp /dev/nvme1n1 /dev/nvme2n1 habe ich festgestellt, dass sie bei Byte 529 unterschiedlich sind.

Hier sind einige Details zu meiner Konfiguration:

In der Anfangsphase stieß ich auf ein Problem mit der EFI-Partition auf der zweiten Festplatte. Die 2. Partition, die als EFI-Partition dient, hatte zunächst kein zugewiesenes Dateisystem, und die erforderlichen Flags waren nicht gesetzt. Nach einigen Herausforderungen und vielen Versuchen gelang es mir, die Konfiguration der beiden Festplatten zu harmonisieren, sodass sie nun identisch erscheinen.

Hier noch ein paar Screens:

Danke im Voraus für eure Hilfe!

Ich habe einen ZFS Mirror Pool auf einem Proxmox-Server mit der ZFS-Version 2.1.12-pve1 eingerichtet. Der Pool (rpool) besteht aus zwei NVMe-Festplatten, die als Mirror konfiguriert sind. Nach dem Vergleich der beiden Festplatten mit dem Befehl cmp /dev/nvme1n1 /dev/nvme2n1 habe ich festgestellt, dass sie bei Byte 529 unterschiedlich sind.

Hier sind einige Details zu meiner Konfiguration:

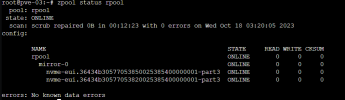

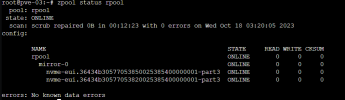

- ZFS-Pool-Konfiguration:

- Pool-Name: rpool

- Pool-Typ: Mirror

- Festplatten: nvme-eui.36434b30577053850025385400000001-part3 und nvme-eui.36434b30577053820025385400000001-part3

- Zuletzt durchgeführter Scrub: scrub repaired 0B in 00:12:23 with 0 errors on Wed Oct 18 03:20:05 2023

- Keine bekannten Datenfehler

- Betriebssystem: Proxmox (Die genaue Version konnte ich nicht abrufen, da der Befehl lsb_release nicht gefunden wurde.)

- ZFS-Version: zfs-2.1.12-pve1 und zfs-kmod-2.1.12-pve1

- Partitionierung und Festplattenmodelle:

- Beide Festplatten sind Samsung Modelle mit einer Kapazität von ca. 7 TB.

- Die Partitionierung auf beiden Festplatten ist identisch, mit drei Partitionen:

- Eine BIOS-Boot-Partition von 1007K

- Eine EFI-Systempartition von 1G

- Eine Solaris /usr & Apple ZFS-Partition von 7T

In der Anfangsphase stieß ich auf ein Problem mit der EFI-Partition auf der zweiten Festplatte. Die 2. Partition, die als EFI-Partition dient, hatte zunächst kein zugewiesenes Dateisystem, und die erforderlichen Flags waren nicht gesetzt. Nach einigen Herausforderungen und vielen Versuchen gelang es mir, die Konfiguration der beiden Festplatten zu harmonisieren, sodass sie nun identisch erscheinen.

Hier noch ein paar Screens:

Danke im Voraus für eure Hilfe!

Last edited: