Moin zusammen,

ich habe aktuell Probleme mit zu langsamen Storage.

Ich habe die Vermutung, dass es an dem Dell H330 mini Controller liegt, kann dies jemand bestätigen und hatte das selbe Problem?

Verwendet wird ebend der H330 Mini im Dell R730 mit 2x Xeon E5-2650 v4 und 64 GB RAM.

Aktuell habe ich auf dem H330 ein RAID 1 fürs OS und 4 weitere Cruicial BX500 1TB SSDs als Non-RAID an Proxmox für ein ZFS Pool RAIDZ1 weiteregeben.

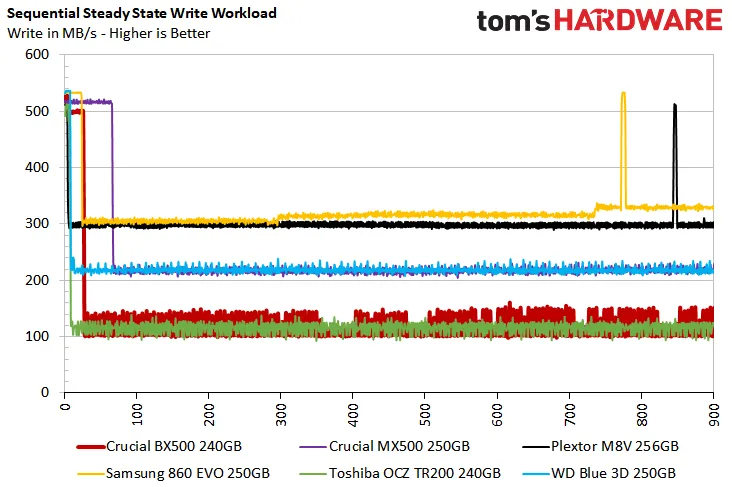

Benchmark einer Disk aus dem ZFS Pool:

CrystalDisk Mark Screenshot aus einer Windows Server VM - Die extrem langsam reagiert:

Vielen Dank.

ich habe aktuell Probleme mit zu langsamen Storage.

Ich habe die Vermutung, dass es an dem Dell H330 mini Controller liegt, kann dies jemand bestätigen und hatte das selbe Problem?

Verwendet wird ebend der H330 Mini im Dell R730 mit 2x Xeon E5-2650 v4 und 64 GB RAM.

Aktuell habe ich auf dem H330 ein RAID 1 fürs OS und 4 weitere Cruicial BX500 1TB SSDs als Non-RAID an Proxmox für ein ZFS Pool RAIDZ1 weiteregeben.

Benchmark einer Disk aus dem ZFS Pool:

Code:

root@MADLEN-PVE01:~# fio --ioengine=libaio --direct=1 --sync=1 --rw=read --bs=4K --numjobs=1 --iodepth=1 --runtime=60 --time_based --name seq_read --filename=/dev/sda

seq_read: (g=0): rw=read, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=libaio, iodepth=1

fio-3.25

Starting 1 process

Jobs: 1 (f=1): [R(1)][100.0%][r=93.3MiB/s][r=23.9k IOPS][eta 00m:00s]

seq_read: (groupid=0, jobs=1): err= 0: pid=2312969: Fri Feb 24 11:19:52 2023

read: IOPS=24.2k, BW=94.5MiB/s (99.1MB/s)(5672MiB/60001msec)

slat (usec): min=7, max=1103, avg= 8.19, stdev= 4.62

clat (usec): min=2, max=14275, avg=31.78, stdev=39.15

lat (usec): min=33, max=14285, avg=40.15, stdev=39.59

clat percentiles (usec):

| 1.00th=[ 29], 5.00th=[ 29], 10.00th=[ 29], 20.00th=[ 30],

| 30.00th=[ 30], 40.00th=[ 30], 50.00th=[ 30], 60.00th=[ 30],

| 70.00th=[ 30], 80.00th=[ 31], 90.00th=[ 32], 95.00th=[ 33],

| 99.00th=[ 38], 99.50th=[ 44], 99.90th=[ 660], 99.95th=[ 898],

| 99.99th=[ 1139]

bw ( KiB/s): min=81112, max=102288, per=100.00%, avg=96867.83, stdev=3393.08, samples=119

iops : min=20278, max=25572, avg=24216.94, stdev=848.26, samples=119

lat (usec) : 4=0.01%, 10=0.01%, 20=0.01%, 50=99.55%, 100=0.04%

lat (usec) : 250=0.07%, 500=0.20%, 750=0.05%, 1000=0.05%

lat (msec) : 2=0.03%, 4=0.01%, 10=0.01%, 20=0.01%

cpu : usr=12.33%, sys=28.78%, ctx=1452032, majf=0, minf=46

IO depths : 1=100.0%, 2=0.0%, 4=0.0%, 8=0.0%, 16=0.0%, 32=0.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

issued rwts: total=1452027,0,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=1

Run status group 0 (all jobs):

READ: bw=94.5MiB/s (99.1MB/s), 94.5MiB/s-94.5MiB/s (99.1MB/s-99.1MB/s), io=5672MiB (5948MB), run=60001-60001msec

Disk stats (read/write):

sda: ios=1449076/2857, merge=0/9, ticks=46695/1310, in_queue=48982, util=99.96%CrystalDisk Mark Screenshot aus einer Windows Server VM - Die extrem langsam reagiert:

Vielen Dank.