Hallo zusammen,

ich bin neu bei Proxmox.

Ich habe vor einigen Wochen 2 Proxmox-Server geerbt, 1x PVE Version 4 und 1x PVE Version 5. Wir hatten diesen beiden Server mit einer FreeNAS als Sicherungs-Server gekoppelt. Da ich mir unsicher war, habe ich die Bestandsserver nicht migriert, da einer unserer IT-Admins gekündigt hat, wollte ich mich erstmal vorsichtig an Proxmox ran tasten.

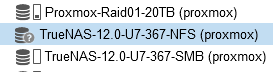

Da wir keine wirkliche Redundanz hatten, habe ich gleich 2x neue Hardware bestellt und aus den alten Proxmox-Versionen nun PVE 7.1 gemacht. Aus dem FreeNAS habe ich nun ein aktuelles TrueNAS gemacht. Also quasi alle Server sind nun up to date und haben meines Wissens nach (wir sind ein kleines Mittelstandsunternehmen) genug Power und Performance (wir fahren ca. 6 VMs und 3 Container). Also keine Unterdimensionierung der Hardware/Switche (alles min. 1Gbit-Netzwerk für die DaSi sogar 10Gbit bereitgestellt).

Ich habe die Container und die VMs per Rücksicherung wiederhergestellt. Bis auf das eine oder andere wo ich schon desöfteren im Forum fündig geworden bin, läuft alles soweit. Habe mittlerweile auch das PMG installiert, da wir einen MS Exchange im Einsatz haben und ich die GUI und den Rest von Proxmox super finde.

Ich habe aktuell ein großes Problem (durch Zufall im Syslog gefunden und weil die E-Mail Benachrichtung von Proxmox nach der Datensicherung immer länger gedauert hat).

Ich habe die beiden Proxmox-Server + TrueNAS mit einem eigenen Netzwerk (10Gbit vernetzt, eigenes Subnetz). Die Proxmox-Server bestehen aus 2 Sockets je 16 Core Intel Xeon (2.4GHz), 128GB-RAM und 4x20TB SAS (WD HC330) im Raid10. Das TrueNAS ist ein AMD Ryzen 5 (1500x) mit 16GB und 4x6TB WD NAS red (ZFS RaidZ+Hotspare). Wenn ich den Load bei TrueNAS und Proxmox sehe, spielen sich die Server an den Eiern rum... Also eigentlich keine wirkliche Last (beim TrueNAS ist die CPU Auslastung nie größer als 3%, habe jetzt nochmal RAM bestellt, damit ich 32GB anstatt 16GB habe, weiß nicht ob das hilft). Die RAM-Erweiterung hatte ich in Betracht gezogen, da ich von einem Member aus diesem Forum gelesen habe, dass die Meldung Storage not Online evtl. damit zusammenhängen kann, wenn der TrueNAS überlastet ist. Zwischen den Proxmox-Servern und dem TrueNAS existiert auch keine Firewall. Ich habe in den Servern jeweils 1Gbit und 10Gbit Netzwerkkarten verbaut. Ebenso sind alle Switche 1Gbit bzw. 10Gbit (LWL), ich vewende auch die dementsprechenden CAT-6A-Kabel bzw. LWL-Kabel. Die Server haben jeweils eigene Boot-Platten (M2-SSD = Proxmox bzw. SSD bei TrueNAS).

Ich hätte jetzt erwartet, wenn ich ein Backup mache, dass ich mit mehr als 50MB manchmal 65MB/s sichern könnte (manchmal sogar nur 30MB/s). Ich erhalte aber auch ständig folgende Meldungen auf beiden Proxmox-Servern (siehe unten). Außerdem spamt mir die Meldung das Syslog voll!

Jan 30 14:20:08 proxmox-mailgateway pvestatd[228187]: storage 'TrueNAS-12.0-U7-367-NFS' is not online

Jan 30 14:20:14 proxmox-mailgateway pvestatd[228187]: storage 'TrueNAS-12.0-U7-367-NFS' is not online

Jetzt habe schon das Timeout von 2 Sekunden auf 5 Sekunden anbehoben (wie des öfteren im Forum gelesen) und PVESTATD neu gestartet.

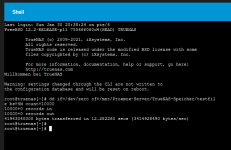

Ich habe auch diesen RPC-Aufruf gemacht. Wenn die Server sichern, dauert die Antwort einige Sekunden und wenn die Server nicht sichern (idle), dann kommt die Antwort sofort.

Pings laufen ohne Unterbrechungen auch NSLOOKUP funktioniert (jeweils auf allen Servern).

Ich weiß nicht, was ich noch machen könnte. Bin ein wenig aufgebracht. Was auch noch passiert ist, wenn ich während der Sicherung auf das Storage klicke (unter Backups oder Übersicht) erhalte ich immer ein Timeout mit Error 500. Ich habe es sogar mal geschafft, dass das TrueNAS hängengeblieben ist, was nicht gut ist, während einer Sicherung, dadurch ist auch schon ein Proxmox-Knoten hängen geblieben.

Ich habe jetzt (aus unserer Firmen-Sicht, nicht was größere Unternehmen aufbringen) ein haufen Kohle für alles ausgebeben und die Kisten laufen wie ein Sack Flöhe. Bevor ich jetzt das ganze Netzwerk monitore, ob Syn/Acks Probleme machen oder wie auch immer, wollte ich von Euch einen Rat. Wir setzen quasi nur Layer2 Switche von Netgear ein, tracen könnte ich nur auf den Proxmox/TrueNAS-Servern.

Beispiel 1 hier war es noch eine FreeNAS jetzt TrueNAS:

INFO: Starting Backup of VM 101 (lxc)

INFO: Backup started at 2022-01-10 18:30:05

INFO: status = running

INFO: backup mode: stop

INFO: ionice priority: 7

INFO: CT Name: fileserver-ubuntu-20-04-lts

INFO: including mount point rootfs ('/') in backup

INFO: stopping virtual guest

INFO: creating vzdump archive '/mnt/pve/FreeNAS-367-NFS/dump/vzdump-lxc-101-2022_01_10-18_30_05.tar.zst'

INFO: Total bytes written: 397896826880 (371GiB, 25MiB/s)

INFO: archive file size: 212.01GB

INFO: prune older backups with retention: keep-last=10

INFO: pruned 0 backup(s)

INFO: restarting vm

INFO: guest is online again after 16057 seconds

INFO: Finished Backup of VM 101 (04:27:37)

INFO: Backup finished at 2022-01-10 22:57:42

INFO: Backup job finished successfully

TASK OK

Oder Beispiel 2, von einem anderen Proxmox-Server wo ich auf einer VM das PMG von Proxmox installiert habe, sonst keine VMs aktiv, außer eine.

INFO: starting new backup job: vzdump 200 --storage TrueNAS-12.0-U7-367-NFS --remove 0 --mode stop --node proxmox-mailgateway --compress zstd

INFO: Starting Backup of VM 200 (qemu)

INFO: Backup started at 2022-01-30 13:41:08

INFO: status = stopped

INFO: backup mode: stop

INFO: ionice priority: 7

INFO: VM Name: pfSense-FreeBSD

INFO: include disk 'virtio0' 'Proxmox-Raid1-2TB:vm-200-disk-0' 50G

INFO: creating vzdump archive '/mnt/pve/TrueNAS-12.0-U7-367-NFS/dump/vzdump-qemu-200-2022_01_30-13_41_08.vma.zst'

INFO: starting kvm to execute backup task

INFO: started backup task '480e2af1-e62a-43e2-ab6d-4f4a35310b57'

INFO: 1% (725.0 MiB of 50.0 GiB) in 3s, read: 241.7 MiB/s, write: 172.2 MiB/s

INFO: 2% (1.3 GiB of 50.0 GiB) in 6s, read: 206.6 MiB/s, write: 203.7 MiB/s

INFO: 3% (1.8 GiB of 50.0 GiB) in 9s, read: 176.4 MiB/s, write: 174.6 MiB/s

INFO: 4% (2.5 GiB of 50.0 GiB) in 12s, read: 222.3 MiB/s, write: 209.8 MiB/s

INFO: 6% (3.1 GiB of 50.0 GiB) in 15s, read: 216.3 MiB/s, write: 215.6 MiB/s

INFO: 7% (3.9 GiB of 50.0 GiB) in 18s, read: 276.7 MiB/s, write: 262.3 MiB/s

INFO: 9% (4.7 GiB of 50.0 GiB) in 21s, read: 250.1 MiB/s, write: 238.2 MiB/s

INFO: 11% (5.5 GiB of 50.0 GiB) in 24s, read: 290.0 MiB/s, write: 288.6 MiB/s

INFO: 12% (6.4 GiB of 50.0 GiB) in 27s, read: 287.6 MiB/s, write: 277.2 MiB/s

INFO: 13% (6.9 GiB of 50.0 GiB) in 30s, read: 197.0 MiB/s, write: 195.5 MiB/s

INFO: 15% (7.7 GiB of 50.0 GiB) in 33s, read: 277.9 MiB/s, write: 275.9 MiB/s

INFO: 16% (8.5 GiB of 50.0 GiB) in 36s, read: 250.1 MiB/s, write: 235.5 MiB/s

INFO: 18% (9.3 GiB of 50.0 GiB) in 39s, read: 281.5 MiB/s, write: 279.8 MiB/s

INFO: 20% (10.1 GiB of 50.0 GiB) in 42s, read: 290.0 MiB/s, write: 276.6 MiB/s

INFO: 21% (10.8 GiB of 50.0 GiB) in 45s, read: 226.0 MiB/s, write: 225.2 MiB/s

INFO: 23% (11.7 GiB of 50.0 GiB) in 48s, read: 297.2 MiB/s, write: 293.0 MiB/s

INFO: 25% (12.5 GiB of 50.0 GiB) in 51s, read: 281.5 MiB/s, write: 269.1 MiB/s

INFO: 26% (13.3 GiB of 50.0 GiB) in 54s, read: 279.1 MiB/s, write: 276.9 MiB/s

INFO: 28% (14.2 GiB of 50.0 GiB) in 57s, read: 311.8 MiB/s, write: 298.2 MiB/s

INFO: 30% (15.1 GiB of 50.0 GiB) in 1m, read: 303.3 MiB/s, write: 301.1 MiB/s

INFO: 32% (16.0 GiB of 50.0 GiB) in 1m 3s, read: 308.1 MiB/s, write: 297.6 MiB/s

INFO: 33% (16.8 GiB of 50.0 GiB) in 1m 6s, read: 275.5 MiB/s, write: 272.2 MiB/s

INFO: 35% (17.6 GiB of 50.0 GiB) in 1m 9s, read: 267.0 MiB/s, write: 266.3 MiB/s

INFO: 36% (18.4 GiB of 50.0 GiB) in 1m 12s, read: 273.1 MiB/s, write: 258.5 MiB/s

INFO: 38% (19.2 GiB of 50.0 GiB) in 1m 15s, read: 279.1 MiB/s, write: 278.3 MiB/s

INFO: 40% (20.1 GiB of 50.0 GiB) in 1m 18s, read: 311.8 MiB/s, write: 299.0 MiB/s

INFO: 41% (20.6 GiB of 50.0 GiB) in 1m 21s, read: 168.0 MiB/s, write: 166.4 MiB/s

INFO: 42% (21.2 GiB of 50.0 GiB) in 1m 24s, read: 183.7 MiB/s, write: 183.5 MiB/s

INFO: 43% (21.5 GiB of 50.0 GiB) in 1m 27s, read: 118.4 MiB/s, write: 118.4 MiB/s

INFO: 44% (22.3 GiB of 50.0 GiB) in 1m 30s, read: 258.6 MiB/s, write: 242.5 MiB/s

INFO: 45% (22.6 GiB of 50.0 GiB) in 1m 33s, read: 107.5 MiB/s, write: 107.3 MiB/s

INFO: 46% (23.0 GiB of 50.0 GiB) in 1m 41s, read: 54.4 MiB/s, write: 54.4 MiB/s

INFO: 47% (23.5 GiB of 50.0 GiB) in 1m 48s, read: 70.9 MiB/s, write: 70.9 MiB/s

INFO: 48% (24.1 GiB of 50.0 GiB) in 1m 55s, read: 80.8 MiB/s, write: 75.4 MiB/s

INFO: 49% (24.5 GiB of 50.0 GiB) in 2m 6s, read: 41.9 MiB/s, write: 41.8 MiB/s

INFO: 50% (25.0 GiB of 50.0 GiB) in 2m 37s, read: 16.8 MiB/s, write: 16.8 MiB/s

INFO: 51% (25.5 GiB of 50.0 GiB) in 2m 56s, read: 26.9 MiB/s, write: 26.9 MiB/s

INFO: 52% (26.0 GiB of 50.0 GiB) in 3m 22s, read: 20.6 MiB/s, write: 19.4 MiB/s

INFO: 53% (26.5 GiB of 50.0 GiB) in 3m 34s, read: 39.3 MiB/s, write: 39.3 MiB/s

INFO: 54% (27.0 GiB of 50.0 GiB) in 4m 3s, read: 17.8 MiB/s, write: 17.6 MiB/s

INFO: 55% (27.5 GiB of 50.0 GiB) in 4m 18s, read: 33.8 MiB/s, write: 33.7 MiB/s

INFO: 56% (28.0 GiB of 50.0 GiB) in 5m 44s, read: 5.9 MiB/s, write: 5.8 MiB/s

INFO: 57% (28.5 GiB of 50.0 GiB) in 5m 58s, read: 38.3 MiB/s, write: 36.1 MiB/s

INFO: 58% (29.0 GiB of 50.0 GiB) in 6m 43s, read: 11.0 MiB/s, write: 11.0 MiB/s

INFO: 59% (29.5 GiB of 50.0 GiB) in 7m 15s, read: 15.7 MiB/s, write: 15.7 MiB/s

INFO: 60% (30.0 GiB of 50.0 GiB) in 7m 32s, read: 31.1 MiB/s, write: 30.9 MiB/s

INFO: 61% (30.5 GiB of 50.0 GiB) in 7m 57s, read: 20.2 MiB/s, write: 19.9 MiB/s

INFO: 62% (31.0 GiB of 50.0 GiB) in 9m 8s, read: 7.0 MiB/s, write: 7.0 MiB/s

INFO: 63% (31.5 GiB of 50.0 GiB) in 9m 37s, read: 18.4 MiB/s, write: 18.2 MiB/s

INFO: 64% (32.1 GiB of 50.0 GiB) in 10m 12s, read: 15.5 MiB/s, write: 14.8 MiB/s

INFO: 65% (32.5 GiB of 50.0 GiB) in 10m 47s, read: 13.3 MiB/s, write: 13.2 MiB/s

INFO: 66% (33.0 GiB of 50.0 GiB) in 11m 2s, read: 36.0 MiB/s, write: 35.9 MiB/s

INFO: 67% (33.6 GiB of 50.0 GiB) in 11m 9s, read: 89.6 MiB/s, write: 89.6 MiB/s

INFO: 68% (34.1 GiB of 50.0 GiB) in 11m 13s, read: 111.5 MiB/s, write: 103.5 MiB/s

INFO: 69% (34.6 GiB of 50.0 GiB) in 11m 19s, read: 84.0 MiB/s, write: 83.9 MiB/s

INFO: 70% (35.1 GiB of 50.0 GiB) in 11m 52s, read: 15.9 MiB/s, write: 15.9 MiB/s

INFO: 71% (35.5 GiB of 50.0 GiB) in 11m 57s, read: 91.3 MiB/s, write: 91.1 MiB/s

INFO: 72% (36.1 GiB of 50.0 GiB) in 12m 2s, read: 110.2 MiB/s, write: 102.3 MiB/s

INFO: 73% (36.5 GiB of 50.0 GiB) in 12m 5s, read: 152.2 MiB/s, write: 149.0 MiB/s

INFO: 74% (37.2 GiB of 50.0 GiB) in 12m 16s, read: 60.3 MiB/s, write: 60.3 MiB/s

INFO: 76% (38.0 GiB of 50.0 GiB) in 12m 19s, read: 292.6 MiB/s, write: 285.7 MiB/s

INFO: 77% (38.5 GiB of 50.0 GiB) in 12m 24s, read: 105.0 MiB/s, write: 102.8 MiB/s

INFO: 78% (39.0 GiB of 50.0 GiB) in 12m 52s, read: 17.1 MiB/s, write: 17.1 MiB/s

INFO: 79% (39.5 GiB of 50.0 GiB) in 13m 34s, read: 12.6 MiB/s, write: 12.6 MiB/s

INFO: 80% (40.1 GiB of 50.0 GiB) in 13m 54s, read: 27.5 MiB/s, write: 25.4 MiB/s

INFO: 81% (40.6 GiB of 50.0 GiB) in 13m 58s, read: 138.7 MiB/s, write: 138.1 MiB/s

INFO: 82% (41.2 GiB of 50.0 GiB) in 14m 3s, read: 131.9 MiB/s, write: 114.0 MiB/s

INFO: 83% (41.5 GiB of 50.0 GiB) in 14m 11s, read: 36.7 MiB/s, write: 32.7 MiB/s

INFO: 84% (42.1 GiB of 50.0 GiB) in 14m 21s, read: 55.1 MiB/s, write: 51.2 MiB/s

INFO: 85% (42.6 GiB of 50.0 GiB) in 14m 43s, read: 24.2 MiB/s, write: 24.0 MiB/s

INFO: 86% (43.0 GiB of 50.0 GiB) in 14m 51s, read: 55.7 MiB/s, write: 55.7 MiB/s

INFO: 87% (43.5 GiB of 50.0 GiB) in 15m 10s, read: 25.8 MiB/s, write: 25.7 MiB/s

INFO: 88% (44.1 GiB of 50.0 GiB) in 15m 15s, read: 118.9 MiB/s, write: 112.9 MiB/s

INFO: 89% (44.5 GiB of 50.0 GiB) in 15m 23s, read: 56.6 MiB/s, write: 56.5 MiB/s

INFO: 90% (45.3 GiB of 50.0 GiB) in 15m 28s, read: 151.5 MiB/s, write: 151.3 MiB/s

INFO: 91% (45.8 GiB of 50.0 GiB) in 15m 31s, read: 171.6 MiB/s, write: 171.4 MiB/s

INFO: 92% (46.1 GiB of 50.0 GiB) in 15m 36s, read: 58.7 MiB/s, write: 58.7 MiB/s

INFO: 93% (46.6 GiB of 50.0 GiB) in 15m 44s, read: 75.7 MiB/s, write: 75.6 MiB/s

INFO: 94% (47.2 GiB of 50.0 GiB) in 15m 47s, read: 182.5 MiB/s, write: 182.3 MiB/s

INFO: 95% (47.5 GiB of 50.0 GiB) in 15m 51s, read: 90.6 MiB/s, write: 90.4 MiB/s

INFO: 96% (48.1 GiB of 50.0 GiB) in 15m 57s, read: 90.0 MiB/s, write: 89.8 MiB/s

INFO: 97% (48.5 GiB of 50.0 GiB) in 16m 11s, read: 32.4 MiB/s, write: 32.3 MiB/s

INFO: 98% (49.1 GiB of 50.0 GiB) in 16m 25s, read: 40.1 MiB/s, write: 40.0 MiB/s

INFO: 99% (49.5 GiB of 50.0 GiB) in 16m 30s, read: 94.2 MiB/s, write: 94.0 MiB/s

INFO: 100% (50.0 GiB of 50.0 GiB) in 16m 35s, read: 100.1 MiB/s, write: 100.1 MiB/s

INFO: backup is sparse: 1.26 GiB (2%) total zero data

INFO: transferred 50.00 GiB in 995 seconds (51.5 MiB/s)

INFO: stopping kvm after backup task

INFO: archive file size: 15.93GB

INFO: Finished Backup of VM 200 (00:20:14)

INFO: Backup finished at 2022-01-30 14:01:22

INFO: Backup job finished successfully

TASK OK

Vielleicht hat noch jemand eine Idee, ich habe hier schon einige Dinge aus dem Forum ausprobiert (neu gemountet vorher alles ungemountet usw.). Wenn Ihr noch mehr Abfragen oder Config-Auszüge benötigt meldet euch bitte. Wie schon oben mitgeteilt, ich bin ein Newbie.

ich bin neu bei Proxmox.

Ich habe vor einigen Wochen 2 Proxmox-Server geerbt, 1x PVE Version 4 und 1x PVE Version 5. Wir hatten diesen beiden Server mit einer FreeNAS als Sicherungs-Server gekoppelt. Da ich mir unsicher war, habe ich die Bestandsserver nicht migriert, da einer unserer IT-Admins gekündigt hat, wollte ich mich erstmal vorsichtig an Proxmox ran tasten.

Da wir keine wirkliche Redundanz hatten, habe ich gleich 2x neue Hardware bestellt und aus den alten Proxmox-Versionen nun PVE 7.1 gemacht. Aus dem FreeNAS habe ich nun ein aktuelles TrueNAS gemacht. Also quasi alle Server sind nun up to date und haben meines Wissens nach (wir sind ein kleines Mittelstandsunternehmen) genug Power und Performance (wir fahren ca. 6 VMs und 3 Container). Also keine Unterdimensionierung der Hardware/Switche (alles min. 1Gbit-Netzwerk für die DaSi sogar 10Gbit bereitgestellt).

Ich habe die Container und die VMs per Rücksicherung wiederhergestellt. Bis auf das eine oder andere wo ich schon desöfteren im Forum fündig geworden bin, läuft alles soweit. Habe mittlerweile auch das PMG installiert, da wir einen MS Exchange im Einsatz haben und ich die GUI und den Rest von Proxmox super finde.

Ich habe aktuell ein großes Problem (durch Zufall im Syslog gefunden und weil die E-Mail Benachrichtung von Proxmox nach der Datensicherung immer länger gedauert hat).

Ich habe die beiden Proxmox-Server + TrueNAS mit einem eigenen Netzwerk (10Gbit vernetzt, eigenes Subnetz). Die Proxmox-Server bestehen aus 2 Sockets je 16 Core Intel Xeon (2.4GHz), 128GB-RAM und 4x20TB SAS (WD HC330) im Raid10. Das TrueNAS ist ein AMD Ryzen 5 (1500x) mit 16GB und 4x6TB WD NAS red (ZFS RaidZ+Hotspare). Wenn ich den Load bei TrueNAS und Proxmox sehe, spielen sich die Server an den Eiern rum... Also eigentlich keine wirkliche Last (beim TrueNAS ist die CPU Auslastung nie größer als 3%, habe jetzt nochmal RAM bestellt, damit ich 32GB anstatt 16GB habe, weiß nicht ob das hilft). Die RAM-Erweiterung hatte ich in Betracht gezogen, da ich von einem Member aus diesem Forum gelesen habe, dass die Meldung Storage not Online evtl. damit zusammenhängen kann, wenn der TrueNAS überlastet ist. Zwischen den Proxmox-Servern und dem TrueNAS existiert auch keine Firewall. Ich habe in den Servern jeweils 1Gbit und 10Gbit Netzwerkkarten verbaut. Ebenso sind alle Switche 1Gbit bzw. 10Gbit (LWL), ich vewende auch die dementsprechenden CAT-6A-Kabel bzw. LWL-Kabel. Die Server haben jeweils eigene Boot-Platten (M2-SSD = Proxmox bzw. SSD bei TrueNAS).

Ich hätte jetzt erwartet, wenn ich ein Backup mache, dass ich mit mehr als 50MB manchmal 65MB/s sichern könnte (manchmal sogar nur 30MB/s). Ich erhalte aber auch ständig folgende Meldungen auf beiden Proxmox-Servern (siehe unten). Außerdem spamt mir die Meldung das Syslog voll!

Jan 30 14:20:08 proxmox-mailgateway pvestatd[228187]: storage 'TrueNAS-12.0-U7-367-NFS' is not online

Jan 30 14:20:14 proxmox-mailgateway pvestatd[228187]: storage 'TrueNAS-12.0-U7-367-NFS' is not online

Jetzt habe schon das Timeout von 2 Sekunden auf 5 Sekunden anbehoben (wie des öfteren im Forum gelesen) und PVESTATD neu gestartet.

Ich habe auch diesen RPC-Aufruf gemacht. Wenn die Server sichern, dauert die Antwort einige Sekunden und wenn die Server nicht sichern (idle), dann kommt die Antwort sofort.

Pings laufen ohne Unterbrechungen auch NSLOOKUP funktioniert (jeweils auf allen Servern).

Ich weiß nicht, was ich noch machen könnte. Bin ein wenig aufgebracht. Was auch noch passiert ist, wenn ich während der Sicherung auf das Storage klicke (unter Backups oder Übersicht) erhalte ich immer ein Timeout mit Error 500. Ich habe es sogar mal geschafft, dass das TrueNAS hängengeblieben ist, was nicht gut ist, während einer Sicherung, dadurch ist auch schon ein Proxmox-Knoten hängen geblieben.

Ich habe jetzt (aus unserer Firmen-Sicht, nicht was größere Unternehmen aufbringen) ein haufen Kohle für alles ausgebeben und die Kisten laufen wie ein Sack Flöhe. Bevor ich jetzt das ganze Netzwerk monitore, ob Syn/Acks Probleme machen oder wie auch immer, wollte ich von Euch einen Rat. Wir setzen quasi nur Layer2 Switche von Netgear ein, tracen könnte ich nur auf den Proxmox/TrueNAS-Servern.

Beispiel 1 hier war es noch eine FreeNAS jetzt TrueNAS:

INFO: Starting Backup of VM 101 (lxc)

INFO: Backup started at 2022-01-10 18:30:05

INFO: status = running

INFO: backup mode: stop

INFO: ionice priority: 7

INFO: CT Name: fileserver-ubuntu-20-04-lts

INFO: including mount point rootfs ('/') in backup

INFO: stopping virtual guest

INFO: creating vzdump archive '/mnt/pve/FreeNAS-367-NFS/dump/vzdump-lxc-101-2022_01_10-18_30_05.tar.zst'

INFO: Total bytes written: 397896826880 (371GiB, 25MiB/s)

INFO: archive file size: 212.01GB

INFO: prune older backups with retention: keep-last=10

INFO: pruned 0 backup(s)

INFO: restarting vm

INFO: guest is online again after 16057 seconds

INFO: Finished Backup of VM 101 (04:27:37)

INFO: Backup finished at 2022-01-10 22:57:42

INFO: Backup job finished successfully

TASK OK

Oder Beispiel 2, von einem anderen Proxmox-Server wo ich auf einer VM das PMG von Proxmox installiert habe, sonst keine VMs aktiv, außer eine.

INFO: starting new backup job: vzdump 200 --storage TrueNAS-12.0-U7-367-NFS --remove 0 --mode stop --node proxmox-mailgateway --compress zstd

INFO: Starting Backup of VM 200 (qemu)

INFO: Backup started at 2022-01-30 13:41:08

INFO: status = stopped

INFO: backup mode: stop

INFO: ionice priority: 7

INFO: VM Name: pfSense-FreeBSD

INFO: include disk 'virtio0' 'Proxmox-Raid1-2TB:vm-200-disk-0' 50G

INFO: creating vzdump archive '/mnt/pve/TrueNAS-12.0-U7-367-NFS/dump/vzdump-qemu-200-2022_01_30-13_41_08.vma.zst'

INFO: starting kvm to execute backup task

INFO: started backup task '480e2af1-e62a-43e2-ab6d-4f4a35310b57'

INFO: 1% (725.0 MiB of 50.0 GiB) in 3s, read: 241.7 MiB/s, write: 172.2 MiB/s

INFO: 2% (1.3 GiB of 50.0 GiB) in 6s, read: 206.6 MiB/s, write: 203.7 MiB/s

INFO: 3% (1.8 GiB of 50.0 GiB) in 9s, read: 176.4 MiB/s, write: 174.6 MiB/s

INFO: 4% (2.5 GiB of 50.0 GiB) in 12s, read: 222.3 MiB/s, write: 209.8 MiB/s

INFO: 6% (3.1 GiB of 50.0 GiB) in 15s, read: 216.3 MiB/s, write: 215.6 MiB/s

INFO: 7% (3.9 GiB of 50.0 GiB) in 18s, read: 276.7 MiB/s, write: 262.3 MiB/s

INFO: 9% (4.7 GiB of 50.0 GiB) in 21s, read: 250.1 MiB/s, write: 238.2 MiB/s

INFO: 11% (5.5 GiB of 50.0 GiB) in 24s, read: 290.0 MiB/s, write: 288.6 MiB/s

INFO: 12% (6.4 GiB of 50.0 GiB) in 27s, read: 287.6 MiB/s, write: 277.2 MiB/s

INFO: 13% (6.9 GiB of 50.0 GiB) in 30s, read: 197.0 MiB/s, write: 195.5 MiB/s

INFO: 15% (7.7 GiB of 50.0 GiB) in 33s, read: 277.9 MiB/s, write: 275.9 MiB/s

INFO: 16% (8.5 GiB of 50.0 GiB) in 36s, read: 250.1 MiB/s, write: 235.5 MiB/s

INFO: 18% (9.3 GiB of 50.0 GiB) in 39s, read: 281.5 MiB/s, write: 279.8 MiB/s

INFO: 20% (10.1 GiB of 50.0 GiB) in 42s, read: 290.0 MiB/s, write: 276.6 MiB/s

INFO: 21% (10.8 GiB of 50.0 GiB) in 45s, read: 226.0 MiB/s, write: 225.2 MiB/s

INFO: 23% (11.7 GiB of 50.0 GiB) in 48s, read: 297.2 MiB/s, write: 293.0 MiB/s

INFO: 25% (12.5 GiB of 50.0 GiB) in 51s, read: 281.5 MiB/s, write: 269.1 MiB/s

INFO: 26% (13.3 GiB of 50.0 GiB) in 54s, read: 279.1 MiB/s, write: 276.9 MiB/s

INFO: 28% (14.2 GiB of 50.0 GiB) in 57s, read: 311.8 MiB/s, write: 298.2 MiB/s

INFO: 30% (15.1 GiB of 50.0 GiB) in 1m, read: 303.3 MiB/s, write: 301.1 MiB/s

INFO: 32% (16.0 GiB of 50.0 GiB) in 1m 3s, read: 308.1 MiB/s, write: 297.6 MiB/s

INFO: 33% (16.8 GiB of 50.0 GiB) in 1m 6s, read: 275.5 MiB/s, write: 272.2 MiB/s

INFO: 35% (17.6 GiB of 50.0 GiB) in 1m 9s, read: 267.0 MiB/s, write: 266.3 MiB/s

INFO: 36% (18.4 GiB of 50.0 GiB) in 1m 12s, read: 273.1 MiB/s, write: 258.5 MiB/s

INFO: 38% (19.2 GiB of 50.0 GiB) in 1m 15s, read: 279.1 MiB/s, write: 278.3 MiB/s

INFO: 40% (20.1 GiB of 50.0 GiB) in 1m 18s, read: 311.8 MiB/s, write: 299.0 MiB/s

INFO: 41% (20.6 GiB of 50.0 GiB) in 1m 21s, read: 168.0 MiB/s, write: 166.4 MiB/s

INFO: 42% (21.2 GiB of 50.0 GiB) in 1m 24s, read: 183.7 MiB/s, write: 183.5 MiB/s

INFO: 43% (21.5 GiB of 50.0 GiB) in 1m 27s, read: 118.4 MiB/s, write: 118.4 MiB/s

INFO: 44% (22.3 GiB of 50.0 GiB) in 1m 30s, read: 258.6 MiB/s, write: 242.5 MiB/s

INFO: 45% (22.6 GiB of 50.0 GiB) in 1m 33s, read: 107.5 MiB/s, write: 107.3 MiB/s

INFO: 46% (23.0 GiB of 50.0 GiB) in 1m 41s, read: 54.4 MiB/s, write: 54.4 MiB/s

INFO: 47% (23.5 GiB of 50.0 GiB) in 1m 48s, read: 70.9 MiB/s, write: 70.9 MiB/s

INFO: 48% (24.1 GiB of 50.0 GiB) in 1m 55s, read: 80.8 MiB/s, write: 75.4 MiB/s

INFO: 49% (24.5 GiB of 50.0 GiB) in 2m 6s, read: 41.9 MiB/s, write: 41.8 MiB/s

INFO: 50% (25.0 GiB of 50.0 GiB) in 2m 37s, read: 16.8 MiB/s, write: 16.8 MiB/s

INFO: 51% (25.5 GiB of 50.0 GiB) in 2m 56s, read: 26.9 MiB/s, write: 26.9 MiB/s

INFO: 52% (26.0 GiB of 50.0 GiB) in 3m 22s, read: 20.6 MiB/s, write: 19.4 MiB/s

INFO: 53% (26.5 GiB of 50.0 GiB) in 3m 34s, read: 39.3 MiB/s, write: 39.3 MiB/s

INFO: 54% (27.0 GiB of 50.0 GiB) in 4m 3s, read: 17.8 MiB/s, write: 17.6 MiB/s

INFO: 55% (27.5 GiB of 50.0 GiB) in 4m 18s, read: 33.8 MiB/s, write: 33.7 MiB/s

INFO: 56% (28.0 GiB of 50.0 GiB) in 5m 44s, read: 5.9 MiB/s, write: 5.8 MiB/s

INFO: 57% (28.5 GiB of 50.0 GiB) in 5m 58s, read: 38.3 MiB/s, write: 36.1 MiB/s

INFO: 58% (29.0 GiB of 50.0 GiB) in 6m 43s, read: 11.0 MiB/s, write: 11.0 MiB/s

INFO: 59% (29.5 GiB of 50.0 GiB) in 7m 15s, read: 15.7 MiB/s, write: 15.7 MiB/s

INFO: 60% (30.0 GiB of 50.0 GiB) in 7m 32s, read: 31.1 MiB/s, write: 30.9 MiB/s

INFO: 61% (30.5 GiB of 50.0 GiB) in 7m 57s, read: 20.2 MiB/s, write: 19.9 MiB/s

INFO: 62% (31.0 GiB of 50.0 GiB) in 9m 8s, read: 7.0 MiB/s, write: 7.0 MiB/s

INFO: 63% (31.5 GiB of 50.0 GiB) in 9m 37s, read: 18.4 MiB/s, write: 18.2 MiB/s

INFO: 64% (32.1 GiB of 50.0 GiB) in 10m 12s, read: 15.5 MiB/s, write: 14.8 MiB/s

INFO: 65% (32.5 GiB of 50.0 GiB) in 10m 47s, read: 13.3 MiB/s, write: 13.2 MiB/s

INFO: 66% (33.0 GiB of 50.0 GiB) in 11m 2s, read: 36.0 MiB/s, write: 35.9 MiB/s

INFO: 67% (33.6 GiB of 50.0 GiB) in 11m 9s, read: 89.6 MiB/s, write: 89.6 MiB/s

INFO: 68% (34.1 GiB of 50.0 GiB) in 11m 13s, read: 111.5 MiB/s, write: 103.5 MiB/s

INFO: 69% (34.6 GiB of 50.0 GiB) in 11m 19s, read: 84.0 MiB/s, write: 83.9 MiB/s

INFO: 70% (35.1 GiB of 50.0 GiB) in 11m 52s, read: 15.9 MiB/s, write: 15.9 MiB/s

INFO: 71% (35.5 GiB of 50.0 GiB) in 11m 57s, read: 91.3 MiB/s, write: 91.1 MiB/s

INFO: 72% (36.1 GiB of 50.0 GiB) in 12m 2s, read: 110.2 MiB/s, write: 102.3 MiB/s

INFO: 73% (36.5 GiB of 50.0 GiB) in 12m 5s, read: 152.2 MiB/s, write: 149.0 MiB/s

INFO: 74% (37.2 GiB of 50.0 GiB) in 12m 16s, read: 60.3 MiB/s, write: 60.3 MiB/s

INFO: 76% (38.0 GiB of 50.0 GiB) in 12m 19s, read: 292.6 MiB/s, write: 285.7 MiB/s

INFO: 77% (38.5 GiB of 50.0 GiB) in 12m 24s, read: 105.0 MiB/s, write: 102.8 MiB/s

INFO: 78% (39.0 GiB of 50.0 GiB) in 12m 52s, read: 17.1 MiB/s, write: 17.1 MiB/s

INFO: 79% (39.5 GiB of 50.0 GiB) in 13m 34s, read: 12.6 MiB/s, write: 12.6 MiB/s

INFO: 80% (40.1 GiB of 50.0 GiB) in 13m 54s, read: 27.5 MiB/s, write: 25.4 MiB/s

INFO: 81% (40.6 GiB of 50.0 GiB) in 13m 58s, read: 138.7 MiB/s, write: 138.1 MiB/s

INFO: 82% (41.2 GiB of 50.0 GiB) in 14m 3s, read: 131.9 MiB/s, write: 114.0 MiB/s

INFO: 83% (41.5 GiB of 50.0 GiB) in 14m 11s, read: 36.7 MiB/s, write: 32.7 MiB/s

INFO: 84% (42.1 GiB of 50.0 GiB) in 14m 21s, read: 55.1 MiB/s, write: 51.2 MiB/s

INFO: 85% (42.6 GiB of 50.0 GiB) in 14m 43s, read: 24.2 MiB/s, write: 24.0 MiB/s

INFO: 86% (43.0 GiB of 50.0 GiB) in 14m 51s, read: 55.7 MiB/s, write: 55.7 MiB/s

INFO: 87% (43.5 GiB of 50.0 GiB) in 15m 10s, read: 25.8 MiB/s, write: 25.7 MiB/s

INFO: 88% (44.1 GiB of 50.0 GiB) in 15m 15s, read: 118.9 MiB/s, write: 112.9 MiB/s

INFO: 89% (44.5 GiB of 50.0 GiB) in 15m 23s, read: 56.6 MiB/s, write: 56.5 MiB/s

INFO: 90% (45.3 GiB of 50.0 GiB) in 15m 28s, read: 151.5 MiB/s, write: 151.3 MiB/s

INFO: 91% (45.8 GiB of 50.0 GiB) in 15m 31s, read: 171.6 MiB/s, write: 171.4 MiB/s

INFO: 92% (46.1 GiB of 50.0 GiB) in 15m 36s, read: 58.7 MiB/s, write: 58.7 MiB/s

INFO: 93% (46.6 GiB of 50.0 GiB) in 15m 44s, read: 75.7 MiB/s, write: 75.6 MiB/s

INFO: 94% (47.2 GiB of 50.0 GiB) in 15m 47s, read: 182.5 MiB/s, write: 182.3 MiB/s

INFO: 95% (47.5 GiB of 50.0 GiB) in 15m 51s, read: 90.6 MiB/s, write: 90.4 MiB/s

INFO: 96% (48.1 GiB of 50.0 GiB) in 15m 57s, read: 90.0 MiB/s, write: 89.8 MiB/s

INFO: 97% (48.5 GiB of 50.0 GiB) in 16m 11s, read: 32.4 MiB/s, write: 32.3 MiB/s

INFO: 98% (49.1 GiB of 50.0 GiB) in 16m 25s, read: 40.1 MiB/s, write: 40.0 MiB/s

INFO: 99% (49.5 GiB of 50.0 GiB) in 16m 30s, read: 94.2 MiB/s, write: 94.0 MiB/s

INFO: 100% (50.0 GiB of 50.0 GiB) in 16m 35s, read: 100.1 MiB/s, write: 100.1 MiB/s

INFO: backup is sparse: 1.26 GiB (2%) total zero data

INFO: transferred 50.00 GiB in 995 seconds (51.5 MiB/s)

INFO: stopping kvm after backup task

INFO: archive file size: 15.93GB

INFO: Finished Backup of VM 200 (00:20:14)

INFO: Backup finished at 2022-01-30 14:01:22

INFO: Backup job finished successfully

TASK OK

Vielleicht hat noch jemand eine Idee, ich habe hier schon einige Dinge aus dem Forum ausprobiert (neu gemountet vorher alles ungemountet usw.). Wenn Ihr noch mehr Abfragen oder Config-Auszüge benötigt meldet euch bitte. Wie schon oben mitgeteilt, ich bin ein Newbie.

Last edited: