Moin,

mir ist folgendes Problem bereits zum zweiten Male untergekommen:

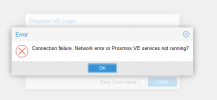

Ohne weiteres Zutun stellen gewisse VMs, deren Platten auf einer NAS liegen, teilweise oder ganz ihre Arbeit ein.

Über die Console /mnt/pve/nas7/ sind die Pfade erreichbar.

pvesm status ergibt auch die aktuellen Werte und spricht vom aktivem Status.

Andere Hosts im Cluster können über die WEB-Gui auch auf die Inhalte zugreifen - nur "der eine" Hosts nicht, in dem die VM mit den NAS-Laufwerken sitzt.

Dabei wurden zwei verschiedene NAS ausprobiert: eine mit 4 HDDs und 1gbit/s (~125MB/s) und eine mit 12HDDs und 2x 10gbit (~300MB/s).

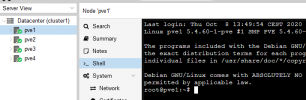

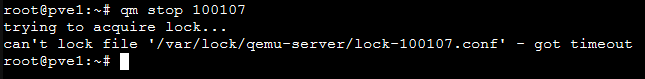

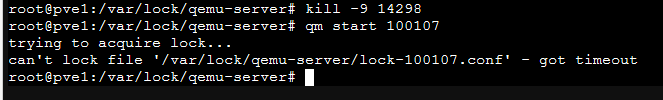

Wenn dieser Zustand eintritt, sind keine Migrationen oder sonstige PVE-Befehle mehr auf diesem Host möglich. Geholfen hatte bisher nur ein Reboot, bei dem man noch einen Hardwarereset hinterherschicken muss, damit der endlich neustartet. Um den Host auszuschließen wurden die VMs mal migriert - selber Fehler nur dann eben auf dem entsprechendem Host.

Aktuell habe ich diesen Status und müsste dann heute Abend den Reset durchführen. Da das z.B. redundante VMs sind, ist das nicht ganz so übel.

Hat jemand diese Art von Problemen schonmal erlebt und wenn ja, wie gefixt?

Aktueller Versionsstand: 6.2-11 mit Standardlizenz.

Gruß, Patrick

mir ist folgendes Problem bereits zum zweiten Male untergekommen:

Ohne weiteres Zutun stellen gewisse VMs, deren Platten auf einer NAS liegen, teilweise oder ganz ihre Arbeit ein.

Über die Console /mnt/pve/nas7/ sind die Pfade erreichbar.

pvesm status ergibt auch die aktuellen Werte und spricht vom aktivem Status.

Andere Hosts im Cluster können über die WEB-Gui auch auf die Inhalte zugreifen - nur "der eine" Hosts nicht, in dem die VM mit den NAS-Laufwerken sitzt.

Dabei wurden zwei verschiedene NAS ausprobiert: eine mit 4 HDDs und 1gbit/s (~125MB/s) und eine mit 12HDDs und 2x 10gbit (~300MB/s).

Wenn dieser Zustand eintritt, sind keine Migrationen oder sonstige PVE-Befehle mehr auf diesem Host möglich. Geholfen hatte bisher nur ein Reboot, bei dem man noch einen Hardwarereset hinterherschicken muss, damit der endlich neustartet. Um den Host auszuschließen wurden die VMs mal migriert - selber Fehler nur dann eben auf dem entsprechendem Host.

Aktuell habe ich diesen Status und müsste dann heute Abend den Reset durchführen. Da das z.B. redundante VMs sind, ist das nicht ganz so übel.

Hat jemand diese Art von Problemen schonmal erlebt und wenn ja, wie gefixt?

Aktueller Versionsstand: 6.2-11 mit Standardlizenz.

Gruß, Patrick