Moin,

ich hab schon einige Threads hier und außerhalb gelesen, die Anleitungen usw..

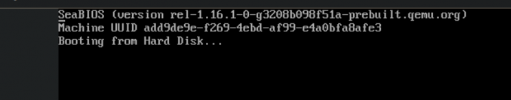

Der Host (PC83) läuft soweit. Auch ein ubuntu22-guest läuft mit Standard-Treibern. Sobald ich das PCI-Device 0000:65:00.0 auswähle, bootet der guest nicht mehr.

Folgende Infos hab ich:

root@pc83:~# lspci |grep -i nvidia

0000:65:00.0 VGA compatible controller: NVIDIA Corporation Device 2488 (rev a1)

0000:65:00.1 Audio device: NVIDIA Corporation GA104 High Definition Audio Controller (rev a1)

root@pc83:~# nvidia-detect

Detected NVIDIA GPUs:

0000:65:00.0 VGA compatible controller [0300]: NVIDIA Corporation Device [10de:2488] (rev a1)

Checking card: 00.0 VGA compatible controller

Uh oh. Your card is not supported by any driver version up to 530.30.02.

A newer driver may add support for your card.

Newer driver releases may be available in backports, unstable or experimental.

## Was wollen die mir damit sagen? Ne 3070 ist doch jetzt nicht soo neu.

root@pc83:~# journalctl --since '2023-05-24'

...

May 25 13:02:36 pc83 QEMU[1554]: kvm: vfio_region_write(0000:65:00.0:region1+0x160de18, 0xff000000ff000000,8) failed: Device or resource busy

May 25 13:02:36 pc83 kernel: vfio-pci 0000:65:00.0: BAR 1: can't reserve [mem 0xc0000000-0xcfffffff 64bit pref]

...

May 25 13:02:36 pc83 systemd-journald[498]: Missed 8 kernel messages

May 25 13:02:36 pc83 kernel: vfio-pci 0000:65:00.0: BAR 1: can't reserve [mem 0xc0000000-0xcfffffff 64bit pref]

Ich hab das 3.1G große cuda-repo-debian11-12-1-local_12.1.1-530.30.02-1_amd64.deb installiert, kann damit aber nix anfangen:

root@pc83:~# dpkg -l |grep -i cuda

ii cuda 12.1.1-1 amd64 CUDA meta-package

ii cuda-12-1 12.1.1-1 amd64 CUDA 12.1 meta-package

ii cuda

...

Hat irgend ein Mensch ne Nvidia 3070 mit aktuellem Proxmox und nem Linux-Guest am Laufen?

Mein Vergleichswunsch: PiTiVi - mp4 rendern in MOV. Das kann bei nem 2G.mp4 2 Minuten oder >1Std. dauern.

LG, D.

ich hab schon einige Threads hier und außerhalb gelesen, die Anleitungen usw..

Der Host (PC83) läuft soweit. Auch ein ubuntu22-guest läuft mit Standard-Treibern. Sobald ich das PCI-Device 0000:65:00.0 auswähle, bootet der guest nicht mehr.

Folgende Infos hab ich:

root@pc83:~# lspci |grep -i nvidia

0000:65:00.0 VGA compatible controller: NVIDIA Corporation Device 2488 (rev a1)

0000:65:00.1 Audio device: NVIDIA Corporation GA104 High Definition Audio Controller (rev a1)

root@pc83:~# nvidia-detect

Detected NVIDIA GPUs:

0000:65:00.0 VGA compatible controller [0300]: NVIDIA Corporation Device [10de:2488] (rev a1)

Checking card: 00.0 VGA compatible controller

Uh oh. Your card is not supported by any driver version up to 530.30.02.

A newer driver may add support for your card.

Newer driver releases may be available in backports, unstable or experimental.

## Was wollen die mir damit sagen? Ne 3070 ist doch jetzt nicht soo neu.

root@pc83:~# journalctl --since '2023-05-24'

...

May 25 13:02:36 pc83 QEMU[1554]: kvm: vfio_region_write(0000:65:00.0:region1+0x160de18, 0xff000000ff000000,8) failed: Device or resource busy

May 25 13:02:36 pc83 kernel: vfio-pci 0000:65:00.0: BAR 1: can't reserve [mem 0xc0000000-0xcfffffff 64bit pref]

...

May 25 13:02:36 pc83 systemd-journald[498]: Missed 8 kernel messages

May 25 13:02:36 pc83 kernel: vfio-pci 0000:65:00.0: BAR 1: can't reserve [mem 0xc0000000-0xcfffffff 64bit pref]

Ich hab das 3.1G große cuda-repo-debian11-12-1-local_12.1.1-530.30.02-1_amd64.deb installiert, kann damit aber nix anfangen:

root@pc83:~# dpkg -l |grep -i cuda

ii cuda 12.1.1-1 amd64 CUDA meta-package

ii cuda-12-1 12.1.1-1 amd64 CUDA 12.1 meta-package

ii cuda

...

Hat irgend ein Mensch ne Nvidia 3070 mit aktuellem Proxmox und nem Linux-Guest am Laufen?

Mein Vergleichswunsch: PiTiVi - mp4 rendern in MOV. Das kann bei nem 2G.mp4 2 Minuten oder >1Std. dauern.

LG, D.