Sofern das Filesystem von HASO das auch unterstützt. Nehmen die da ZFS?Falls noch nicht geschehen, die Option discard anhaken, dann wird gelöschter Speicher auch wieder im Pool freigegeben.

Proxmox Oberfläche nach Stromausfall nicht mehr erreichbar

- Thread starter lethuer

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Mit ext4 ist doch sogar das verkleinern relativ problemlos möglich. Müsste man mal schauen wie die Partitionierung genau ist.

Aber Falk hat Recht, eigentlich ist es nur ein kosmetisches Ding.

Aber Falk hat Recht, eigentlich ist es nur ein kosmetisches Ding.

Moin !

Ich hatte leider wieder das Problem, dass mein "local" voll war.

Mit

habe ich dieses mal das hier bekommen:

Trotzdem habe ich dann mit

das System "local" dann wieder von rund 30GB auf 6.1GB reduzieren können.

Wie bekomme ich genauer raus was da jedes mal mit der Zeit den log Ordner voll müllt ?

Kann mich da jemand genauer anleiten und evtl. irgendwie nach der Ursache forschen ?

Auch bei meinen beiden LXC Containern hatte ich danach noch geschaut und gesehen, dass die "Bootdisk Größe" rot war.

Hier habe ich dann eben falls 15.2GB beim ersten bzw. 8.2GB beim zweiten Container frei machen können.

Beide melden aber ebenfalls:

bzw.

Was heißt das?

Ich hatte leider wieder das Problem, dass mein "local" voll war.

Mit

Code:

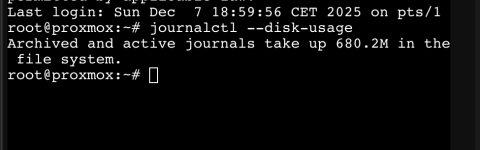

root@proxmox:~# journalctl --disk-usagehabe ich dieses mal das hier bekommen:

Code:

Journal file /var/log/journal/27a75f85666348ada3dad0aff5ce8b9a/system.journal is truncated, ignoring file.Trotzdem habe ich dann mit

Code:

journalctl --vacuum-size 1Gdas System "local" dann wieder von rund 30GB auf 6.1GB reduzieren können.

Wie bekomme ich genauer raus was da jedes mal mit der Zeit den log Ordner voll müllt ?

Kann mich da jemand genauer anleiten und evtl. irgendwie nach der Ursache forschen ?

Auch bei meinen beiden LXC Containern hatte ich danach noch geschaut und gesehen, dass die "Bootdisk Größe" rot war.

Hier habe ich dann eben falls 15.2GB beim ersten bzw. 8.2GB beim zweiten Container frei machen können.

Beide melden aber ebenfalls:

Code:

Journal file /var/log/journal/a55811e5e7dd471c8828522cf3772105/system.journal is truncated, ignoring file.

Code:

Journal file /var/log/journal/b63388389bb241bc9e5317b71cd5ae20/system.journal is truncated, ignoring file.

Last edited:

Ich hatte leider wieder das Problem, dass mein "local" voll war...

Und wieder führte das dazu, dass nach einem Stromausfall nix mehr ging.

Erst gingen Zigbee Geräte nicht mehr, dann war kein Reboot mehr möglich.

Wer kann mir helfen herauszufinden warum „local“ immer voll läuft ??

Und wieder führte das dazu, dass nach einem Stromausfall nix mehr ging.

Erst gingen Zigbee Geräte nicht mehr, dann war kein Reboot mehr möglich.

Wer kann mir helfen herauszufinden warum „local“ immer voll läuft ??

Wenn du wieder Zugriff auf die Konsole hast, würde ich zB mit

du -sh * | sort -hr

die Order der Größe nach anzeigen lassen. Danach kann man schauen, welche Dateien darin erstellt sind und hat so ev. einen Rückschluss wer sie produziert bzw woher sie kommen.

Ev. noch ncdu installieren und mit diesem Programm schauen.

apt install ncdu

du -sh * | sort -hr

die Order der Größe nach anzeigen lassen. Danach kann man schauen, welche Dateien darin erstellt sind und hat so ev. einen Rückschluss wer sie produziert bzw woher sie kommen.

Ev. noch ncdu installieren und mit diesem Programm schauen.

apt install ncdu

Ich musste halt mal wieder mit

Also das was voll ist ist der Journal Ordner, das weiß ich ja schon…

Nur weiß ich eben nicht warum.

Post in thread 'Proxmox Oberfläche nach Stromausfall nicht mehr erreichbar'

https://forum.proxmox.com/threads/p...fall-nicht-mehr-erreichbar.150913/post-683158

In der datei

Ich verstehe daher nicht wieso der ordner

den log Ordner leer machen. Danach lief dann wieder alles.journalctl --vacuum-size 1G

Also das was voll ist ist der Journal Ordner, das weiß ich ja schon…

Nur weiß ich eben nicht warum.

Post in thread 'Proxmox Oberfläche nach Stromausfall nicht mehr erreichbar'

https://forum.proxmox.com/threads/p...fall-nicht-mehr-erreichbar.150913/post-683158

In der datei

/etc/systemd/journald.conf steht mittlerweile auch SystemMaxUse = 750MIch verstehe daher nicht wieso der ordner

/var/log/journalüberhaupt volllaufen kann…

Last edited:

Und gerade habe ich noch ein backup problem bei den containern (VM geht)

Und auf der Backup Platte ist auch platz…

Und auf der Backup Platte ist auch platz…

Code:

INFO: starting new backup job: vzdump --compress zstd --mode snapshot --mailnotification always --storage Backup --notes-template '{{guestname}}' --node proxmox --quiet 1 --prune-backups 'keep-daily=14' --all 1

INFO: Starting Backup of VM 100 (lxc)

INFO: Backup started at 2025-11-23 00:00:03

INFO: status = running

INFO: CT Name: InfluxDB2

INFO: including mount point rootfs ('/') in backup

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: create storage snapshot 'vzdump'

snapshot create failed: starting cleanup

no lock found trying to remove 'backup' lock

ERROR: Backup of VM 100 failed - lvcreate snapshot 'pve/snap_vm-100-disk-0_vzdump' error: Cannot create new thin volume, free space in thin pool pve/data reached threshold.

Last edited:

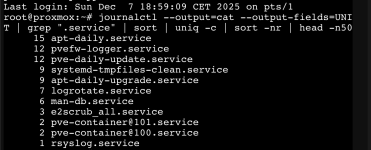

Du könntest so etwas probieren und zu sehen welcher Service am meisten loggt

Generell hat das Journal aber ein Limit und sollte nicht voll laufen.

Für das andere Problem Teile bitte

Bash:

journalctl --output=cat --output-fields=UNIT | grep ".service" | sort | uniq -c | sort -nr | head -n50Für das andere Problem Teile bitte

Bash:

lvs

pct fstrim 100

lvsUnd das wird doch hier eingestellt oder bin ich falsch ?Generell hat das Journal aber ein Limit und sollte nicht voll laufen.

/etc/systemd/journald.conf mit SystemMaxUse = 750Mjournalctl --output=cat --output-fields=UNIT | grep ".service" | sort | uniq -c | sort -nr | head -n50

Für das andere Problem Teile bitte

lvs

pct fstrim 100

lvs

Ja, es gibt aber ein defaultUnd das wird doch hier eingestellt oder bin ich falsch

Die Logs sind gerade eh ziemlich leer. Was sagt das hier

Bash:

df -hT

lvmconfig

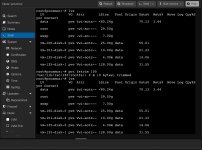

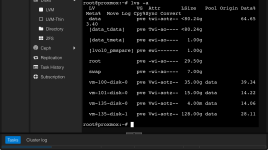

lvs -aHallo @lethuer,

anhand deines Screenshots lässt sich der Backup-Fehler (reached threshold) gut erklären:

Du hast eine massive Überprovisionierung (Overprovisioning) vorliegen.Dein Speicher-Pool (data) ist physikalisch nur <80,24 GB groß.Du hast den VMs/Containern aber virtuellen Speicher von weit über 160 GB zugewiesen (allein vm-135-disk-1 ist mit 128 GB größer als dein ganzer Server-Speicher).

Der Pool ist real zu 70,13% gefüllt. Wenn du ein Backup im Modus "Snapshot" startest, benötigt LVM freien Platz im Pool, um Änderungen während des Backups zwischenzuspeichern. Da der Pool aber schon recht voll ist und rechnerisch völlig überbucht, verweigert Proxmox den Snapshot aus Sicherheitsgründen, um zu verhindern, dass der Pool vollläuft und alles abstürzt.

Lösungsschritte:

anhand deines Screenshots lässt sich der Backup-Fehler (reached threshold) gut erklären:

Du hast eine massive Überprovisionierung (Overprovisioning) vorliegen.Dein Speicher-Pool (data) ist physikalisch nur <80,24 GB groß.Du hast den VMs/Containern aber virtuellen Speicher von weit über 160 GB zugewiesen (allein vm-135-disk-1 ist mit 128 GB größer als dein ganzer Server-Speicher).

Der Pool ist real zu 70,13% gefüllt. Wenn du ein Backup im Modus "Snapshot" startest, benötigt LVM freien Platz im Pool, um Änderungen während des Backups zwischenzuspeichern. Da der Pool aber schon recht voll ist und rechnerisch völlig überbucht, verweigert Proxmox den Snapshot aus Sicherheitsgründen, um zu verhindern, dass der Pool vollläuft und alles abstürzt.

Lösungsschritte:

- Backup-Modus: Stelle den Backup-Job temporär von "Snapshot" auf "Stop" um. Dabei wird der Container kurz heruntergefahren, es wird aber kein LVM-Snapshot-Platz benötigt. Das sollte funktionieren.

- Warnung: Die 128 GB Disk auf dem 80 GB Speicher ist ein hohes Risiko. Wenn diese VM anfängt, den Platz wirklich zu nutzen, läuft dein Host voll (data auf 100%) und alle VMs bleiben stehen oder das Dateisystem wird read-only.

- Logs/Root-Partition: Dein Screenshot zeigt nur die LVM-Ebene (lvs). Um das Problem mit dem vollen "local" Speicher (Logs) zu prüfen, fehlt noch die von @Impact angefragte Ausgabe von

df -h. Nur dort sehen wir, wie voll/(pve-root) auf Dateisystem-Ebene wirklich ist.

fstrim Ergebnis (0 Bytes) bedeutet, dass im Container entweder kein Platz zum Freigeben gefunden wurde oder die Daten dort tatsächlich belegt sind.defaults to 10% ... capped to 4GJa, es gibt aber ein default

Dann bleibt die Frage warum der Journal Ordner immer wieder voll läuft…

Gerade sieht es aber gut aus (was es so schwierig macht)

100 + 101 sind ContainerDurch das doofe LVM Namenssystem, kann ich nicht beurteilen, welche der IDs CTs und welche VMs sind.

135 ist VM

Du hast eine massive Überprovisionierung (Overprovisioning) vorliegen.Dein Speicher-Pool (data) ist physikalisch nur <80,24 GB groß.Du hast den VMs/Containern aber virtuellen Speicher von weit über 160 GB zugewiesen (allein vm-135-disk-1 ist mit 128 GB größer als dein ganzer Server-Speicher).

Jap leider hab ich das bei der Einrichtung nicht beachtet.Warnung: Die 128 GB Disk auf dem 80 GB Speicher ist ein hohes Risiko. Wenn diese VM anfängt, den Platz wirklich zu nutzen, läuft dein Host voll (data auf 100%) und alle VMs bleiben stehen oder das Dateisystem wird read-only.

Für die Container hatte ich den zugewiesenen Speicher sogar bereits reduziert…

verstehe. ich konnte die größe der beiden lxc mit dieser anleitung verkleinern:Du hast dein Storage überprovisioniert (ist mit lvm-thin möglich). Deine sda3 Partition/local-lvm, wo deine LXC/VM Daten liegen hat ~118G an Kapazität.

Du hast aber mehr zugewiesen:

https://tfta.de/forum/thread/7-proxmox-ve-verkleinern-einer-lvm-basierten-festplatte/

aber für die VM hat das leider nicht geklappt... gibt es hier eine anleitung wie ich die vm verkleinern könnte ?

Hab ihnen also wieder etwas mehr Speicher zuweisen müssen (jetzt 35G bzw. 15G).

Aber anscheinend gibt es keine sinnvolle Möglichkeit den zugewiesenen Speicher der VM nachträglich zu reduzieren?

Meine HomeAssistant Oberfläche (die auf 135 läuft) sagt mir aber sie wäre nur zu 26% belegt und hätte noch 86G frei.

Kommt ja fast hin mit den zugewiesenen 128G, die könnte also deutlich kleiner werden (z.B. 50G).

Insgesamt ist die Platte aber wohl einfach zu klein…

Last edited:

So sieht es heute ausDie Logs sind gerade eh ziemlich leer.

Was sagt das hier

df -hT

lvmconfig

Logs/Root-Partition: Dein Screenshot zeigt nur die LVM-Ebene (lvs). Um das Problem mit dem vollen "local" Speicher (Logs) zu prüfen, fehlt noch die von @Impact angefragte Ausgabe von df -h. Nur dort sehen wir, wie voll / (pve-root) auf Dateisystem-Ebene wirklich ist.

lvs -a

Last edited:

Tatsächlich funktioniert das Backup aktuell mit allen VM und Containern auch auf „Snapshot“ (ich hab aber nichts geändert).Backup-Modus: Stelle den Backup-Job temporär von "Snapshot" auf "Stop" um. Dabei wird der Container kurz heruntergefahren, es wird aber kein LVM-Snapshot-Platz benötigt. Das sollte funktionieren.

Irgendwie finde ich den Backup Job für die einzelnen Maschinen nicht..

Wo könnte ich das im Zweifel umstellen ?

Last edited: