Hallo zusammen,

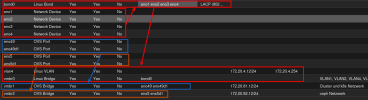

wir betreiben einen Proxmox VE (8.1.4) / Ceph (18.2.1) Cluster bestehend aus 3 Nodes. Die aktuelle Ceph Config sieht so aus:

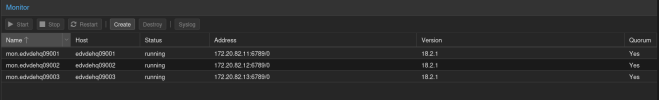

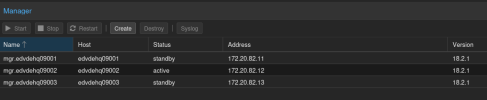

Ceph funktioniert einwandfrei, wie man auch in der Proxmox GUI sehen kann:

Jetzt müssen wir das Subnetz, in dem der komplette Ceph Traffic läuft, von 172.20.82.0/24 auf 172.20.81.0/24 ändern.

Laut diesem Forum Post ist das ja eigentlich simpel duch ändern der entsprechenden IPs in der /etc/pve/ceph.conf möglich:

https://forum.proxmox.com/threads/how-to-change-ceph-cluster-and-network-ip.96524/

Aber wenn wir das machen (sprich in der config, alle .82 Einträge zu .81 ändern), sieht das sofort in der Proxmox GUI nicht mehr so gut aus.

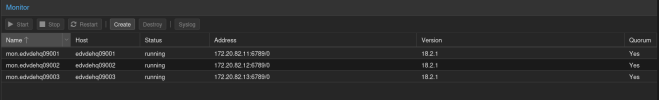

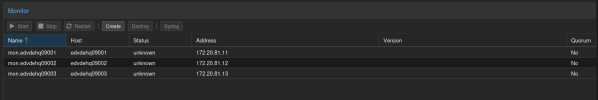

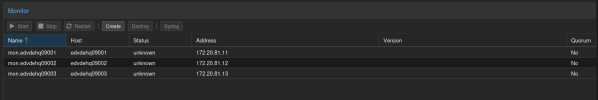

1.) Alle Monitore haben den Status "unknown":

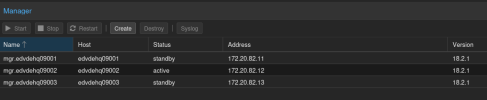

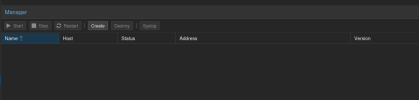

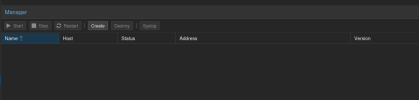

2.) Die Manager sind gar nicht mehr da:

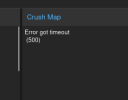

3.) Die Ceph - Config Seite funktioniert nicht mehr:

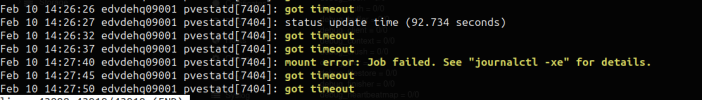

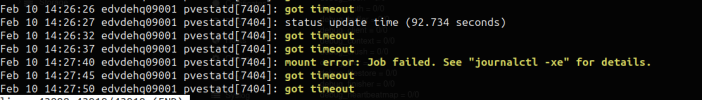

4.) Der pvestatd Dienst wirft diese Fehler:

Ein Reboot aller drei PVE Nodes verändert nichts.

BTW: das Ceph Log selber sieht während der ganzen Zeit eigentlich ganz normal aus, so als ob Ceph an sich funktioniert.

Wenn wir die ceph.conf wieder auf das ursprüngliche Netz .82 ändern, ist die Proxmox GUI sofort wieder ok, alles funktioniert.

Daher stellen wir uns jetzt die Frage: Ist das vllt. nur ein Problem in der GUI von Proxmox? Oder müssen wir hier doch noch mehr tun, als nur die ceph.conf anpassen?

Hat jmd. einen Tip?

wir betreiben einen Proxmox VE (8.1.4) / Ceph (18.2.1) Cluster bestehend aus 3 Nodes. Die aktuelle Ceph Config sieht so aus:

Code:

[global]

auth_client_required = none

auth_cluster_required = none

auth_service_required = none

cephx_sign_messages = false

cluster_network = 172.20.82.0/24

debug_asok = 0/0

debug_auth = 0/0

debug_buffer = 0/0

debug_client = 0/0

debug_context = 0/0

debug_crush = 0/0

debug_filer = 0/0

debug_filestore = 0/0

debug_finisher = 0/0

debug_heartbeatmap = 0/0

debug_journal = 0/0

debug_journaler = 0/0

debug_lockdep = 0/0

debug_mds = 0/0

debug_mds_balancer = 0/0

debug_mds_locker = 0/0

debug_mds_log = 0/0

debug_mds_log_expire = 0/0

debug_mds_migrator = 0/0

debug_mon = 0/0

debug_monc = 0/0

debug_ms = 0/0

debug_objclass = 0/0

debug_objectcacher = 0/0

debug_objecter = 0/0

debug_optracker = 0/0

debug_osd = 0/0

debug_paxos = 0/0

debug_perfcounter = 0/0

debug_rados = 0/0

debug_rbd = 0/0

debug_rgw = 0/0

debug_throttle = 0/0

debug_timer = 0/0

debug_tp = 0/0

fsid = cd3e4269-8080-4a18-a7fa-e309fb6cebbd

mon_allow_pool_delete = true

mon_host = 172.20.82.12 172.20.82.11 172.20.82.13

ms_bind_ipv4 = true

ms_bind_ipv6 = false

osd_pool_default_min_size = 2

osd_pool_default_size = 3

public_network = 172.20.82.0/24

[client]

keyring = /etc/pve/priv/$cluster.$name.keyring

[mds]

keyring = /var/lib/ceph/mds/ceph-$id/keyring

[mds.edvdehq09001]

host = edvdehq09001

mds_standby_for_name = pve

[mds.edvdehq09002]

host = edvdehq09002

mds_standby_for_name = pve

[mds.edvdehq09003]

host = edvdehq09003

mds_standby_for_name = pve

[mon.edvdehq09001]

public_addr = 172.20.82.11

[mon.edvdehq09002]

public_addr = 172.20.82.12

[mon.edvdehq09003]

public_addr = 172.20.82.13Ceph funktioniert einwandfrei, wie man auch in der Proxmox GUI sehen kann:

Jetzt müssen wir das Subnetz, in dem der komplette Ceph Traffic läuft, von 172.20.82.0/24 auf 172.20.81.0/24 ändern.

Laut diesem Forum Post ist das ja eigentlich simpel duch ändern der entsprechenden IPs in der /etc/pve/ceph.conf möglich:

https://forum.proxmox.com/threads/how-to-change-ceph-cluster-and-network-ip.96524/

Aber wenn wir das machen (sprich in der config, alle .82 Einträge zu .81 ändern), sieht das sofort in der Proxmox GUI nicht mehr so gut aus.

1.) Alle Monitore haben den Status "unknown":

2.) Die Manager sind gar nicht mehr da:

3.) Die Ceph - Config Seite funktioniert nicht mehr:

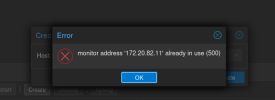

4.) Der pvestatd Dienst wirft diese Fehler:

Ein Reboot aller drei PVE Nodes verändert nichts.

BTW: das Ceph Log selber sieht während der ganzen Zeit eigentlich ganz normal aus, so als ob Ceph an sich funktioniert.

Wenn wir die ceph.conf wieder auf das ursprüngliche Netz .82 ändern, ist die Proxmox GUI sofort wieder ok, alles funktioniert.

Daher stellen wir uns jetzt die Frage: Ist das vllt. nur ein Problem in der GUI von Proxmox? Oder müssen wir hier doch noch mehr tun, als nur die ceph.conf anpassen?

Hat jmd. einen Tip?