Hi Forum,

7 Knoten Ceph-Cluster - letzte 7er-Version. Ein HDD-Pool mit ~ 40 OSDs. Brutto-Gesamtkapazität ~ 250TB.

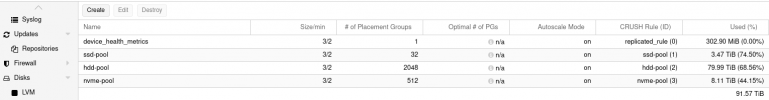

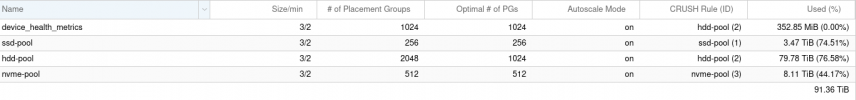

Unter Ceph -> Pools - ist pg_autoscaling angehakt.

Dennoch steht bei Optimal # PG - need pg_autoscaler enabled.

Auch ein # ceph osd pool autoscale-status

liefert keine Ausgabe.

Das hat zur Folge, dass mein Pool trotz haufenweise hinzugefügter HDDs, nicht mehr anwächst.

Setze ich manuell die Num # PGs, wächst der Pool.

Ist das ein Bug bzw. wie kann ich das weiter debuggen?

Vielen Dank.

Siegmar.

7 Knoten Ceph-Cluster - letzte 7er-Version. Ein HDD-Pool mit ~ 40 OSDs. Brutto-Gesamtkapazität ~ 250TB.

Unter Ceph -> Pools - ist pg_autoscaling angehakt.

Dennoch steht bei Optimal # PG - need pg_autoscaler enabled.

Auch ein # ceph osd pool autoscale-status

liefert keine Ausgabe.

Das hat zur Folge, dass mein Pool trotz haufenweise hinzugefügter HDDs, nicht mehr anwächst.

Setze ich manuell die Num # PGs, wächst der Pool.

Ist das ein Bug bzw. wie kann ich das weiter debuggen?

Vielen Dank.

Siegmar.

Last edited: