Performance Probleme

- Thread starter Nerion

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Ich denke der Aufruf via API führt hier zu Problemen. Mach bitte mal ein Backup über die Oberfläche.

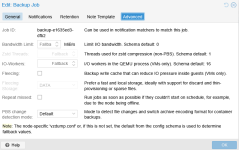

Habe jetzt noch PBS Change Detection mode alles ausprobiert. Habe auch IO-Workers mal auf 32 gesetzt.

Alles ohne Veränderung.

Alles ohne Veränderung.

Mehr kann ich dann hier nicht beitragen. Alles darüber hinaus müsste ich über direkten Zugang machen, da ich hier sonst nicht weiterkomme. Allen Beteiligten viel Erfolg!

Das Forum hier ist community support.Schade, dass sich hier niemand vom Proxmox Support Team meldet.

Für Support vom Proxmox Support Team gibts es das Kundencenter.

Dort kann ein Ticket eröffnet werden.

Die Trennung ist schon sinnvoll. Mache ich auch seit vielen Jahren so.Macht nur Sinn bei unterschiedlichen Platten, aber hier sind es die Gleichen !!

Außerdem würde ich die Vdisks auf readahead setzen, weil die PBS chunks 1,5-4MB groß sind und du x FS 4k requests dazu erzeugst, die alle eine zusätzliche Latency erzeugen, anstatt sie bereits im Vorfeld in den ctrl Cache zu holen.

Read Ahead Cache wäre gut, erklärt aber nicht das Problem.

Die Einstellungen der Controller sind in Ordnung, mich wundert aber wie ihr 12 NVMe an den Controller bekommen habt.

Laut Dell Support gehen da maximal 8 NVMe dran. Die Diskussion hatte sich ch mit dem Support für einen anderen Kunden.

Ich weiß nicht wie der Server ausgestattet ist, mit 12 NVMe bräuchte man einen PCIe Switch im Server und diese Dinger sind für Probleme bekannt.

Ich würde schauen ob man den Server umverkabeln kann und die NVMe direkt aufs Board stecken.

Das läuft garantiert stabiler und deutlich schneller.

Laut Dell Support gehen da maximal 8 NVMe dran. Die Diskussion hatte sich ch mit dem Support für einen anderen Kunden.

Ich weiß nicht wie der Server ausgestattet ist, mit 12 NVMe bräuchte man einen PCIe Switch im Server und diese Dinger sind für Probleme bekannt.

Ich würde schauen ob man den Server umverkabeln kann und die NVMe direkt aufs Board stecken.

Das läuft garantiert stabiler und deutlich schneller.

Interessanr, das wurde so direkt von Dell zusammengestellt und ist ab Dell Werk so und ist auch Offiziell Supported.

Bei einem R660 gehen nur 8 NVMe

Bei einem R760 gehen 24 NVMe mit zwei Controller. Wobei jeder Controller 12 NVMe kann

Bei einem R760 gehen 24 NVMe mit zwei Controller. Wobei jeder Controller 12 NVMe kann

Was Dell Vertriebler zusammenstellen, da gibt’s teilweise ganz schlimme Sachen.Interessanr, das wurde so direkt von Dell zusammengestellt und ist ab Dell Werk so und ist auch Offiziell Supported.

Aber das der so gebaut wurde wundert mich.

Daher vermute ich einen PCIe Switch

Sinnvoll ist das aber trotzdem nicht. Man bremst die NVMe massiv aus.Bei einem R660 gehen nur 8 NVMe

Bei einem R760 gehen 24 NVMe mit zwei Controller. Wobei jeder Controller 12 NVMe kann

Ja hast recht ab 8 NVMe ist ein Switch verbaut. Meinst der macht die Probleme? Dann stellt sich nur die Frage warum man dies mit einem fio test nicht reproduzieren kann.

4 NVMe ziehen würde bedeuten ich muss den komplett umbauen und schauen was ich mit den ganzen Backups mache.

Nur um dann vielleicht festzustellen, das war es nicht.

4 NVMe ziehen würde bedeuten ich muss den komplett umbauen und schauen was ich mit den ganzen Backups mache.

Nur um dann vielleicht festzustellen, das war es nicht.

Ja das ist tatsächlich schlecht zu testen.

Ich habe schon mehrere Server mit PCIe Switch gesehen und keiner lief gut. Entweder schlechte Benchmarks bei kleinen I/O bis zu Instabilität.

Ich traue den Dingern kein Stück mehr über den Weg.

Ich habe schon mehrere Server mit PCIe Switch gesehen und keiner lief gut. Entweder schlechte Benchmarks bei kleinen I/O bis zu Instabilität.

Ich traue den Dingern kein Stück mehr über den Weg.

Config richtig lesen !! Was da angelegt wurde ist "vergleichsweise in zfs Logik":Die Trennung ist schon sinnvoll. Mache ich auch seit vielen Jahren so.

Lege auf allen 12 nvme 2 Partitionen (oder namespaces) an, eine kleine und eine große (vergessen der Einfachheit hier mal den bootmanager),

zpool create rpool raidzX nvme{0..11}n0p1 und danach ein

zpool create data raidzX nvme{0..11}n0p2.

Das ist extrem weit von best paractise und hat nichts mit "Trennung" zu tun !!!

Füer einen nvme Tausch müßte man da auch 2 resilver für beide zpools auf den gleichen nvmes starten.

Last edited:

Aber fio lesenwerte / random read sind auch mega schnellZudem sieht es mir mehr anch einem Lese- oder Verarbeitungsproblem aus, denn nur "1Gbit/s" Backup-Schreibleistung bei den fio Werten läßt es nicht auf der write Seite erkennen.

Kleiner Tipp, bitte mal richtig lesen.Config richtig lesen !! Was da angelegt wurde ist in zfs Logik:

Lege auf allen 12 nvme 2 Partitionen (oder namespaces) an, eine kleine und eine große (vergessen der Einfachheit hier mal den bootmanager),

zpool create rpool raidzX nvme{0..11}n0p1 und danach ein

zpool create data raidzX nvme{0..11}n0p2.

Das ist extrem weit von best paractise und hat nichts mit "Trennung" zu tun !!!

Füer einen nvme Tausch müßte man da auch 2 resilver für beide zpools auf den gleichen nvmes starten.

Das ist kein ZFS RAID sondern Hardware RAID. Bei Hardware Raid macht die Trennung Sinn. Im ZFS Pool hat man ja eh keine Trennung.