Hallo zusammen,

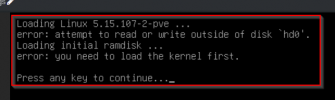

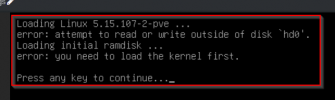

nach einem Update von Kernel 5.15.104-2-pve auf 5.15.107-2-pve auf einem der PBS kann dieser nicht mehr booten, und bleibt mit folgender Meldung stehen:

Der PBS läuft virtuell auf einem Proxmox Server.

Wenn ich manuell bei der Bootauswahl den alten 5.15.104-2-pve auswähle, kann ich normal booten.

Habt Ihr ne Idee, wo ich anfangen kann zu suchen?

Danke,

Basti

nach einem Update von Kernel 5.15.104-2-pve auf 5.15.107-2-pve auf einem der PBS kann dieser nicht mehr booten, und bleibt mit folgender Meldung stehen:

Loading Linux 5.15.107-2-pve ...

error: attempt to read or write outside of disk 'hd0'.

Loading initial ramdisk ...

error: you need to Ioad the kernel first.

Press any key to continue...

Der PBS läuft virtuell auf einem Proxmox Server.

Wenn ich manuell bei der Bootauswahl den alten 5.15.104-2-pve auswähle, kann ich normal booten.

Habt Ihr ne Idee, wo ich anfangen kann zu suchen?

Danke,

Basti