Hallo zusammen,

ich bitte um Infos, ob jemand einen Linux-Bond betreibt und dabei die gleichen Probleme hat, die mich hier plagen.

Um den Durchsatz für die VM bzw. die angeschlossenen Clients zu gewährleisten, habe ich aus zwei 10G-SFP+ (Mellanox-Karte) einen Linux-Bond erstellt:

Dieses Netzwerk habe ich nun diversen VM zugewiesen und dort eingebunden. Die Clients erreichen die VM's und die VM's haben eine Netzwerk-/Internetverbindung.

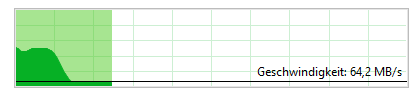

Das Problem besteht nun darin, dass ich von einem 10G-Netz weit weg bin. Ich liege immer um die 60-70 MB/s!?

Wo muss ich ansetzen bzw. was ist falsch konfiguriert?

Viele Grüße

ich bitte um Infos, ob jemand einen Linux-Bond betreibt und dabei die gleichen Probleme hat, die mich hier plagen.

Um den Durchsatz für die VM bzw. die angeschlossenen Clients zu gewährleisten, habe ich aus zwei 10G-SFP+ (Mellanox-Karte) einen Linux-Bond erstellt:

Code:

iface ens6f0 inet manual

iface ens6f1 inet manual

auto bond1

iface bond1 inet manual

bond-slaves ens6f0 ens6f1

bond-miimon 100

bond-mode 802.3ad

bond-use-carrier 1

bond-lacp-rate 1

bond-min-links 1

bond-xmit-hash-policy layer3+4

mtu 9000

auto vmbr1

iface vmbr1 inet manual

bridge-ports bond1

bridge-stp off

bridge-fd 0

bridge-vlan-aware yes

bridge-vids 2-4000

mtu 9000Dieses Netzwerk habe ich nun diversen VM zugewiesen und dort eingebunden. Die Clients erreichen die VM's und die VM's haben eine Netzwerk-/Internetverbindung.

Das Problem besteht nun darin, dass ich von einem 10G-Netz weit weg bin. Ich liege immer um die 60-70 MB/s!?

Wo muss ich ansetzen bzw. was ist falsch konfiguriert?

Viele Grüße