Hi liebe Community,

ich versuche mal so strukturiert wie möglich mein Setup, mein Problem und meine bisherigen Lösungsversuche darzustellen:

System:

Meine Analyse und bisheriges Ergebnis:

Nun bin ich echt ratlos. Viele Stunden investiert, bin leicht genervt und würde es am liebsten an die Wand pfeffern. Vielleicht hat ja von Euch noch jemand einen Tipp oder Rat?

Besten Dank und viele Grüße

ich versuche mal so strukturiert wie möglich mein Setup, mein Problem und meine bisherigen Lösungsversuche darzustellen:

System:

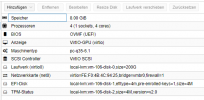

- CPU: 16 x AMD Ryzen 7 4800U with Radeon Graphics (1 Socket)

- RAM: 32GB

- Kernel: Linux 5.13.19-6-pve; PVE: pve-manager/7.1-11

- Bios: up-2-date

- Media Dateien sind alle auf meinem Synology NAS und werden "rein gemountet"

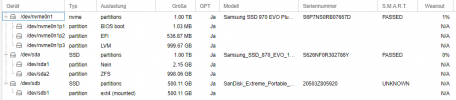

Google Coral TPU und Zigbee Dongle (ConbeeII) sind via powered USB hub verbunden - Festplatten (Platz ist da ...):

- Nginx (512MB RAM, 512MB SWAP, 1 core)

- DuckDNS (512MB RAM, 512MB SWAP, 1 core)

- Bitwarden (512MB RAM, 512MB SWAP, 1 core)

- Adguard (512MB RAM, 512MB SWAP, 1 core)

- Wireguard (512MB RAM, 512MB SWAP, 1 core)

- PhotoPrism (4GIG RAM, 4GIG SWAP, 4 cores, privelgiert für NAS mount)

- Grafana+InfluxDB (2GB RAM, 512MB SWAP, 2 cores)

- PLEX (2GB RAM, 512MB RAM, 2 cores, privelgiert für NAS mount)

- Home Assistant (8GB RAM, 2 cores, Coral und Conbee II USB passthrough)

- Windows 11 (8 GB RAM, 4 cores)

- CPU: 45°C

- NVME: 52°C

- Power consumption: 5 W

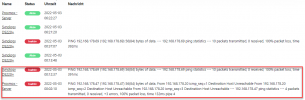

- Nicht wirklich reproduzierbare Host crashs. Mal nach 2h, mal nach 3 Tagen. Einziger Weg, wie ich es provozieren kann: ich fahre die Win11 VM hoch (siehe auch Screenshot). Aber lief damit auch schon 3 Tage am Stück und ich habe die Steuererklärung via RDP auf der VM gemacht.

- Es geht dann gar nichts mehr (SSH, WebGUI, .. alles tot). Nur Stom aus/an bringt alles zurück.

Meine Analyse und bisheriges Ergebnis:

- Logs sind mEn nicht aussagekräftig. Hören einfach auf (20:14 Uhr ) und fangen beim Reboot (20:17 Uhr) wieder neu an.

- less /var/log/syslog: https://pastebin.com/AUypuTde

- journalctl: https://pastebin.com/E4Eg1KfG

- less /var/log/messages: https://pastebin.com/kVY90bf9

- Ich habe einen CPU Stresstest durchgeführt, sowie 4 runs mit memtest (0 errors). In allen Belangen keine Auffälligkeiten oder crash.

- Ich habe den ganzen USB Schnickschnack entfernt und an den USB Hub (eigenes Netzteil!) gehängt, in der Annahme, dass vllt. das Netzteil des Gigabyte in die Knie geht. Habe es testweise auch komplett weggelassen. Kein Effekt.

- In der Annahme, dass mein Problem irgendwo mit dem RAM was zu tun hat, habe ich mir das ganze ZFS setting angeschaut

- Mir ist klar, dass mein jetziges ZFS Setup irgendwie Banane ist. Consumer SSD, kein ECC RAM. Habe mittlerweile viel quer gelesen, das ganze ZFS Pimmelimm aber auch nicht 100% verstanden.

- Was ich verstanden habe: Per default frisst ZFS 50% RAM. Habe daher ARC limitiert.

- /etc/modprobe.d/zfs.conf wurde wie folgt limitiert:

- options zfs zfs_arc_min=4294967296

options zfs zfs_arc_max=8589934592

- options zfs zfs_arc_min=4294967296

- /etc/modprobe.d/zfs.conf wurde wie folgt limitiert:

- Ich hatte damit die Hoffnung, ggf. Probleme mit dem "over-committen" von RAM irgendwie entgegenzuwirken. Kein Effekt. Trotzdem crash.

- Die Win11 VM ist mEn im Standard angelegt, beim RAM ist "balloning" aktiviert:

Nun bin ich echt ratlos. Viele Stunden investiert, bin leicht genervt und würde es am liebsten an die Wand pfeffern. Vielleicht hat ja von Euch noch jemand einen Tipp oder Rat?

Besten Dank und viele Grüße