Hallo zusammen,

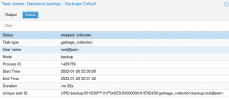

ich habe festgestellt, dass seit einiger Zeit die Garbage Collection des Backup Servers fehl schlägt.

Zum Testen starte ich die per Hand auf der Konsole:

mit dem Ergebnis, dass die Phase1 plötzlich und ohne jegliche Meldung bei 19% abbricht:

Hat jmd. ne Idee? Gibts irgendwo Logs oder so?

Danke schon mal!

T0mc@

ich habe festgestellt, dass seit einiger Zeit die Garbage Collection des Backup Servers fehl schlägt.

Zum Testen starte ich die per Hand auf der Konsole:

Code:

root@backup:~# proxmox-backup-manager garbage-collection start backupmit dem Ergebnis, dass die Phase1 plötzlich und ohne jegliche Meldung bei 19% abbricht:

Code:

starting garbage collection on store backup

Start GC phase1 (mark used chunks)

marked 1% (19 of 1847 index files)

marked 2% (37 of 1847 index files)

marked 3% (56 of 1847 index files)

marked 4% (74 of 1847 index files)

marked 5% (93 of 1847 index files)

marked 6% (111 of 1847 index files)

marked 7% (130 of 1847 index files)

marked 8% (148 of 1847 index files)

marked 9% (167 of 1847 index files)

marked 10% (185 of 1847 index files)

marked 11% (204 of 1847 index files)

marked 12% (222 of 1847 index files)

marked 13% (241 of 1847 index files)

marked 14% (259 of 1847 index files)

marked 15% (278 of 1847 index files)

marked 16% (296 of 1847 index files)

marked 17% (314 of 1847 index files)

marked 18% (333 of 1847 index files)

marked 19% (351 of 1847 index files)Hat jmd. ne Idee? Gibts irgendwo Logs oder so?

Danke schon mal!

T0mc@