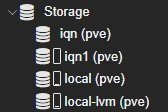

Erhalte folgenden Fehler beim hinzufügen von LVM auf iSCSCI:

create storage failed: vgcreate pve /dev/disk/by-id/scsi-36e843b66432653939323166663238653 error: Run `vgcreate --help' for more information. (500)

root@pve:~# pveversion

pve-manager/8.4.14/b502d23c55afcba1 (running kernel: 6.8.12-15-pve)

root@pve:~# multipath -v3

800.787450 | set open fds limit to 1048576/1048576

800.787478 | loading /lib/multipath/libchecktur.so checker

800.787530 | checker tur: message table size = 3

800.787535 | loading /lib/multipath/libprioconst.so prioritizer

800.787588 | _init_foreign: foreign library "nvme" is not enabled

800.790140 | nvme0n1: size = 1000215216

800.790217 | nvme0n1: vendor = NVME

800.790220 | nvme0n1: product = SKHynix_HFS512GEM9X169N

800.790221 | nvme0n1: serial = 5SE3N425910503A6D

800.790223 | nvme0n1: rev = 61700A30

800.790481 | nvme0n1: uid_attribute = ID_WWN (setting: storage device configuration)

800.790483 | nvme0n1: recheck_wwid = 1 (setting: multipath.conf defaults/devices section)

800.790539 | nvme0n1: 29634 cyl, 64 heads, 32 sectors/track, start at 0

800.790541 | nvme0n1: detect_checker = yes (setting: multipath internal)

800.790544 | nvme0n1: path_checker = none (setting: storage device configuration)

800.790545 | nvme0n1: checker timeout = 30 s (setting: multipath internal)

800.790547 | nvme0n1: none state = up

800.790549 | nvme0n1: uid = eui.ace42e00552239b9 (udev)

800.790553 | nvme0n1: wwid eui.ace42e00552239b9 blacklisted

800.790692 | nvme1n1: size = 1953525168

800.790765 | nvme1n1: vendor = NVME

800.790767 | nvme1n1: product = WD Red SN700 1000GB

800.790768 | nvme1n1: serial = 232938800437

800.790770 | nvme1n1: rev = 111150WD

800.791020 | nvme1n1: uid_attribute = ID_WWN (setting: storage device configuration)

800.791022 | nvme1n1: recheck_wwid = 1 (setting: multipath.conf defaults/devices section)

800.791070 | nvme1n1: 36365 cyl, 64 heads, 32 sectors/track, start at 0

800.791072 | nvme1n1: detect_checker = yes (setting: multipath internal)

800.791074 | nvme1n1: path_checker = none (setting: storage device configuration)

800.791076 | nvme1n1: checker timeout = 30 s (setting: multipath internal)

800.791077 | nvme1n1: none state = up

800.791079 | nvme1n1: uid = eui.e8238fa6bf530001001b448b4a7e0017 (udev)

800.791081 | nvme1n1: wwid eui.e8238fa6bf530001001b448b4a7e0017 blacklisted

800.791137 | sda: size = 2147483648

800.791190 | sda: vendor = QNAP

800.791200 | sda: product = iSCSI Storage

800.791210 | sda: rev = 300

800.791440 | sda: h:b:t:l = 0:0:0:1

800.791568 | sda: tgt_node_name = iqn.2004-04.com.qnap:ts-473a:iscsi.target-0.600914

800.791571 | sda: uid_attribute = ID_SERIAL (setting: multipath.conf defaults/devices section)

800.791573 | sda: recheck_wwid = 1 (setting: multipath.conf defaults/devices section)

800.791664 | sda: 65535 cyl, 255 heads, 63 sectors/track, start at 0

800.791666 | sda: vpd_vendor_id = 0 "undef" (setting: multipath internal)

800.791676 | sda: serial = d2e9921ff28e679e

800.791678 | sda: detect_checker = yes (setting: multipath internal)

800.792081 | sda: path_checker = tur (setting: storage device autodetected)

800.792084 | sda: checker timeout = 30 s (setting: kernel sysfs)

800.792190 | sda: tur state = up

800.792192 | sda: uid = 36e843b66432653939323166663238653 (udev)

800.792222 | sda: wwid 36e843b66432653939323166663238653 whitelisted

800.792225 | sda: detect_prio = yes (setting: multipath internal)

800.792365 | loading /lib/multipath/libpriosysfs.so prioritizer

800.792426 | sda: prio = sysfs (setting: storage device autodetected)

800.792428 | sda: prio args = "" (setting: storage device autodetected)

800.792445 | sda: sysfs prio = 50

800.792484 | loop0: device node name blacklisted

800.792518 | loop1: device node name blacklisted

800.792550 | loop2: device node name blacklisted

800.792581 | loop3: device node name blacklisted

800.792614 | loop4: device node name blacklisted

800.792645 | loop5: device node name blacklisted

800.792676 | loop6: device node name blacklisted

800.792707 | loop7: device node name blacklisted

800.792739 | dm-0: device node name blacklisted

800.792772 | dm-1: device node name blacklisted

800.792804 | dm-10: device node name blacklisted

800.792835 | dm-11: device node name blacklisted

800.792866 | dm-12: device node name blacklisted

800.792897 | dm-2: device node name blacklisted

800.792928 | dm-3: device node name blacklisted

800.792959 | dm-4: device node name blacklisted

800.792990 | dm-5: device node name blacklisted

800.793490 | dm-6: device node name blacklisted

800.793529 | dm-7: device node name blacklisted

800.793565 | dm-8: device node name blacklisted

800.793614 | dm-9: device node name blacklisted

===== paths list =====

uuid hcil dev dev_t pri dm_st chk_st vend/prod/rev dev_st

36e843b66432653939323166663238653 0:0:0:1 sda 8:0 50 undef undef QNAP,iSCSI Storage unknown

800.793854 | multipath-tools v0.9.4 (12/19, 2022)

800.793865 | libdevmapper version 1.02.185

800.793971 | kernel device mapper v4.48.0

800.793980 | DM multipath kernel driver v1.14.0

800.794107 | sda: size = 2147483648

800.794112 | sda: vendor = QNAP

800.794114 | sda: product = iSCSI Storage

800.794116 | sda: rev = 300

800.794419 | sda: h:b:t:l = 0:0:0:1

800.794477 | sda: tgt_node_name = iqn.2004-04.com.qnap:ts-473a:iscsi.target-0.600914

800.794490 | sda: 65535 cyl, 255 heads, 63 sectors/track, start at 0

800.794493 | sda: vpd_vendor_id = 0 "undef" (setting: multipath internal)

800.794505 | sda: serial = d2e9921ff28e679e

800.794694 | sda: tur state = up

800.794717 | sda: udev property ID_WWN whitelisted

800.794727 | sda: wwid 36e843b66432653939323166663238653 whitelisted

800.794881 | unloading none checker

800.794885 | unloading tur checker

800.794912 | unloading sysfs prioritizer

800.794926 | unloading const prioritizer

root@pve:~# multipath -ll

mpath0 (36e843b66432653939323166663238653) dm-12 QNAP,iSCSI Storage

size=1.0T features='1 queue_if_no_path' hwhandler='1 alua' wp=rw

`-+- policy='round-robin 0' prio=50 status=active

`- 0:0:0:1 sda 8:0 active ready running

root@pve:~# iscsiadm -m session -P3

iSCSI Transport Class version 2.0-870

version 2.1.8

Target: iqn.2004-04.com.qnap:ts-473a:iscsi.target-0.600914 (non-flash)

Current Portal: 192.168.199.101:3260,1

Persistent Portal: 192.168.199.101:3260,1

**********

Interface:

**********

Iface Name: default

Iface Transport: tcp

Iface Initiatorname: iqn.1993-08.org.debian:01:1832d5eaccd9

Iface IPaddress: 192.168.199.155

Iface HWaddress: default

Iface Netdev: default

SID: 1

iSCSI Connection State: LOGGED IN

iSCSI Session State: LOGGED_IN

Internal iscsid Session State: NO CHANGE

*********

Timeouts:

*********

Recovery Timeout: 5

Target Reset Timeout: 30

LUN Reset Timeout: 30

Abort Timeout: 10

*****

CHAP:

*****

username: iscsiuser

password: ********

username_in: <empty>

password_in: ********

************************

Negotiated iSCSI params:

************************

HeaderDigest: None

DataDigest: None

MaxRecvDataSegmentLength: 65536

MaxXmitDataSegmentLength: 262144

FirstBurstLength: 262144

MaxBurstLength: 262144

ImmediateData: Yes

InitialR2T: No

MaxOutstandingR2T: 1

************************

Attached SCSI devices:

************************

Host Number: 0 State: running

scsi0 Channel 00 Id 0 Lun: 1

Attached scsi disk sda State: running

root@pve:~# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 1T 0 disk

└─mpath0 252:12 0 1T 0 mpath

nvme1n1 259:0 0 931.5G 0 disk

├─red-vm--101--disk--0 252:2 0 128G 0 lvm

├─red-vm--102--disk--0 252:3 0 128G 0 lvm

├─red-vm--103--disk--0 252:4 0 4M 0 lvm

└─red-vm--103--disk--1 252:5 0 96G 0 lvm

nvme0n1 259:1 0 476.9G 0 disk

├─nvme0n1p1 259:2 0 1007K 0 part

├─nvme0n1p2 259:3 0 1G 0 part /boot/efi

└─nvme0n1p3 259:4 0 475.9G 0 part

├─pve-swap 252:0 0 8G 0 lvm [SWAP]

├─pve-root 252:1 0 96G 0 lvm /

├─pve-data_tmeta 252:6 0 3.6G 0 lvm

│ └─pve-data-tpool 252:8 0 348.8G 0 lvm

│ ├─pve-data 252:9 0 348.8G 1 lvm

│ ├─pve-vm--100--disk--0 252:10 0 8G 0 lvm

│ └─pve-vm--111--disk--0 252:11 0 128G 0 lvm

└─pve-data_tdata 252:7 0 348.8G 0 lvm

└─pve-data-tpool 252:8 0 348.8G 0 lvm

├─pve-data 252:9 0 348.8G 1 lvm

├─pve-vm--100--disk--0 252:10 0 8G 0 lvm

└─pve-vm--111--disk--0 252:11 0 128G 0 lvm

Wo mache ich ein Fehler ?

create storage failed: vgcreate pve /dev/disk/by-id/scsi-36e843b66432653939323166663238653 error: Run `vgcreate --help' for more information. (500)

root@pve:~# pveversion

pve-manager/8.4.14/b502d23c55afcba1 (running kernel: 6.8.12-15-pve)

root@pve:~# multipath -v3

800.787450 | set open fds limit to 1048576/1048576

800.787478 | loading /lib/multipath/libchecktur.so checker

800.787530 | checker tur: message table size = 3

800.787535 | loading /lib/multipath/libprioconst.so prioritizer

800.787588 | _init_foreign: foreign library "nvme" is not enabled

800.790140 | nvme0n1: size = 1000215216

800.790217 | nvme0n1: vendor = NVME

800.790220 | nvme0n1: product = SKHynix_HFS512GEM9X169N

800.790221 | nvme0n1: serial = 5SE3N425910503A6D

800.790223 | nvme0n1: rev = 61700A30

800.790481 | nvme0n1: uid_attribute = ID_WWN (setting: storage device configuration)

800.790483 | nvme0n1: recheck_wwid = 1 (setting: multipath.conf defaults/devices section)

800.790539 | nvme0n1: 29634 cyl, 64 heads, 32 sectors/track, start at 0

800.790541 | nvme0n1: detect_checker = yes (setting: multipath internal)

800.790544 | nvme0n1: path_checker = none (setting: storage device configuration)

800.790545 | nvme0n1: checker timeout = 30 s (setting: multipath internal)

800.790547 | nvme0n1: none state = up

800.790549 | nvme0n1: uid = eui.ace42e00552239b9 (udev)

800.790553 | nvme0n1: wwid eui.ace42e00552239b9 blacklisted

800.790692 | nvme1n1: size = 1953525168

800.790765 | nvme1n1: vendor = NVME

800.790767 | nvme1n1: product = WD Red SN700 1000GB

800.790768 | nvme1n1: serial = 232938800437

800.790770 | nvme1n1: rev = 111150WD

800.791020 | nvme1n1: uid_attribute = ID_WWN (setting: storage device configuration)

800.791022 | nvme1n1: recheck_wwid = 1 (setting: multipath.conf defaults/devices section)

800.791070 | nvme1n1: 36365 cyl, 64 heads, 32 sectors/track, start at 0

800.791072 | nvme1n1: detect_checker = yes (setting: multipath internal)

800.791074 | nvme1n1: path_checker = none (setting: storage device configuration)

800.791076 | nvme1n1: checker timeout = 30 s (setting: multipath internal)

800.791077 | nvme1n1: none state = up

800.791079 | nvme1n1: uid = eui.e8238fa6bf530001001b448b4a7e0017 (udev)

800.791081 | nvme1n1: wwid eui.e8238fa6bf530001001b448b4a7e0017 blacklisted

800.791137 | sda: size = 2147483648

800.791190 | sda: vendor = QNAP

800.791200 | sda: product = iSCSI Storage

800.791210 | sda: rev = 300

800.791440 | sda: h:b:t:l = 0:0:0:1

800.791568 | sda: tgt_node_name = iqn.2004-04.com.qnap:ts-473a:iscsi.target-0.600914

800.791571 | sda: uid_attribute = ID_SERIAL (setting: multipath.conf defaults/devices section)

800.791573 | sda: recheck_wwid = 1 (setting: multipath.conf defaults/devices section)

800.791664 | sda: 65535 cyl, 255 heads, 63 sectors/track, start at 0

800.791666 | sda: vpd_vendor_id = 0 "undef" (setting: multipath internal)

800.791676 | sda: serial = d2e9921ff28e679e

800.791678 | sda: detect_checker = yes (setting: multipath internal)

800.792081 | sda: path_checker = tur (setting: storage device autodetected)

800.792084 | sda: checker timeout = 30 s (setting: kernel sysfs)

800.792190 | sda: tur state = up

800.792192 | sda: uid = 36e843b66432653939323166663238653 (udev)

800.792222 | sda: wwid 36e843b66432653939323166663238653 whitelisted

800.792225 | sda: detect_prio = yes (setting: multipath internal)

800.792365 | loading /lib/multipath/libpriosysfs.so prioritizer

800.792426 | sda: prio = sysfs (setting: storage device autodetected)

800.792428 | sda: prio args = "" (setting: storage device autodetected)

800.792445 | sda: sysfs prio = 50

800.792484 | loop0: device node name blacklisted

800.792518 | loop1: device node name blacklisted

800.792550 | loop2: device node name blacklisted

800.792581 | loop3: device node name blacklisted

800.792614 | loop4: device node name blacklisted

800.792645 | loop5: device node name blacklisted

800.792676 | loop6: device node name blacklisted

800.792707 | loop7: device node name blacklisted

800.792739 | dm-0: device node name blacklisted

800.792772 | dm-1: device node name blacklisted

800.792804 | dm-10: device node name blacklisted

800.792835 | dm-11: device node name blacklisted

800.792866 | dm-12: device node name blacklisted

800.792897 | dm-2: device node name blacklisted

800.792928 | dm-3: device node name blacklisted

800.792959 | dm-4: device node name blacklisted

800.792990 | dm-5: device node name blacklisted

800.793490 | dm-6: device node name blacklisted

800.793529 | dm-7: device node name blacklisted

800.793565 | dm-8: device node name blacklisted

800.793614 | dm-9: device node name blacklisted

===== paths list =====

uuid hcil dev dev_t pri dm_st chk_st vend/prod/rev dev_st

36e843b66432653939323166663238653 0:0:0:1 sda 8:0 50 undef undef QNAP,iSCSI Storage unknown

800.793854 | multipath-tools v0.9.4 (12/19, 2022)

800.793865 | libdevmapper version 1.02.185

800.793971 | kernel device mapper v4.48.0

800.793980 | DM multipath kernel driver v1.14.0

800.794107 | sda: size = 2147483648

800.794112 | sda: vendor = QNAP

800.794114 | sda: product = iSCSI Storage

800.794116 | sda: rev = 300

800.794419 | sda: h:b:t:l = 0:0:0:1

800.794477 | sda: tgt_node_name = iqn.2004-04.com.qnap:ts-473a:iscsi.target-0.600914

800.794490 | sda: 65535 cyl, 255 heads, 63 sectors/track, start at 0

800.794493 | sda: vpd_vendor_id = 0 "undef" (setting: multipath internal)

800.794505 | sda: serial = d2e9921ff28e679e

800.794694 | sda: tur state = up

800.794717 | sda: udev property ID_WWN whitelisted

800.794727 | sda: wwid 36e843b66432653939323166663238653 whitelisted

800.794881 | unloading none checker

800.794885 | unloading tur checker

800.794912 | unloading sysfs prioritizer

800.794926 | unloading const prioritizer

root@pve:~# multipath -ll

mpath0 (36e843b66432653939323166663238653) dm-12 QNAP,iSCSI Storage

size=1.0T features='1 queue_if_no_path' hwhandler='1 alua' wp=rw

`-+- policy='round-robin 0' prio=50 status=active

`- 0:0:0:1 sda 8:0 active ready running

root@pve:~# iscsiadm -m session -P3

iSCSI Transport Class version 2.0-870

version 2.1.8

Target: iqn.2004-04.com.qnap:ts-473a:iscsi.target-0.600914 (non-flash)

Current Portal: 192.168.199.101:3260,1

Persistent Portal: 192.168.199.101:3260,1

**********

Interface:

**********

Iface Name: default

Iface Transport: tcp

Iface Initiatorname: iqn.1993-08.org.debian:01:1832d5eaccd9

Iface IPaddress: 192.168.199.155

Iface HWaddress: default

Iface Netdev: default

SID: 1

iSCSI Connection State: LOGGED IN

iSCSI Session State: LOGGED_IN

Internal iscsid Session State: NO CHANGE

*********

Timeouts:

*********

Recovery Timeout: 5

Target Reset Timeout: 30

LUN Reset Timeout: 30

Abort Timeout: 10

*****

CHAP:

*****

username: iscsiuser

password: ********

username_in: <empty>

password_in: ********

************************

Negotiated iSCSI params:

************************

HeaderDigest: None

DataDigest: None

MaxRecvDataSegmentLength: 65536

MaxXmitDataSegmentLength: 262144

FirstBurstLength: 262144

MaxBurstLength: 262144

ImmediateData: Yes

InitialR2T: No

MaxOutstandingR2T: 1

************************

Attached SCSI devices:

************************

Host Number: 0 State: running

scsi0 Channel 00 Id 0 Lun: 1

Attached scsi disk sda State: running

root@pve:~# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 1T 0 disk

└─mpath0 252:12 0 1T 0 mpath

nvme1n1 259:0 0 931.5G 0 disk

├─red-vm--101--disk--0 252:2 0 128G 0 lvm

├─red-vm--102--disk--0 252:3 0 128G 0 lvm

├─red-vm--103--disk--0 252:4 0 4M 0 lvm

└─red-vm--103--disk--1 252:5 0 96G 0 lvm

nvme0n1 259:1 0 476.9G 0 disk

├─nvme0n1p1 259:2 0 1007K 0 part

├─nvme0n1p2 259:3 0 1G 0 part /boot/efi

└─nvme0n1p3 259:4 0 475.9G 0 part

├─pve-swap 252:0 0 8G 0 lvm [SWAP]

├─pve-root 252:1 0 96G 0 lvm /

├─pve-data_tmeta 252:6 0 3.6G 0 lvm

│ └─pve-data-tpool 252:8 0 348.8G 0 lvm

│ ├─pve-data 252:9 0 348.8G 1 lvm

│ ├─pve-vm--100--disk--0 252:10 0 8G 0 lvm

│ └─pve-vm--111--disk--0 252:11 0 128G 0 lvm

└─pve-data_tdata 252:7 0 348.8G 0 lvm

└─pve-data-tpool 252:8 0 348.8G 0 lvm

├─pve-data 252:9 0 348.8G 1 lvm

├─pve-vm--100--disk--0 252:10 0 8G 0 lvm

└─pve-vm--111--disk--0 252:11 0 128G 0 lvm

Wo mache ich ein Fehler ?

Last edited: