Einen schönen guten morgen wünsche ich euch, meiner ist gerade sehr gruselig da mein einer VM Server steht (genau dieser welcher auf den neuen Umziehen soll (siehe anderen Thread) und sich keine VMs starten lassen.

Es läuft hier Proxmox 7.0-8

Ich erhalte bei allen die Meldung

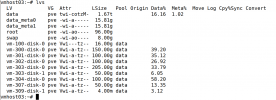

"kvm: -drive file=/dev/pve/vm-307-disk-0,if=none,id=drive-scsi0,discard=on,format=raw,cache=none,aio=io_uring,detect-zeroes=unmap: Could not open '/dev/pve/vm-307-disk-0': No such file or directory

TASK ERROR: start failed: QEMU exited with code 1"

Ich also nachgesehen beide HDDs (2x 4TB) sind vorhanden und zeigen keine Fehler an.

Server neustart !

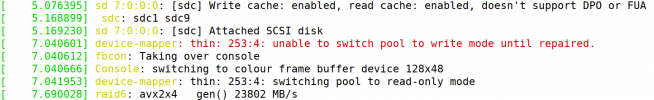

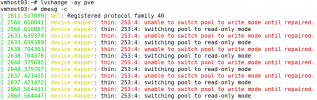

Hier sehe ich bei Booten

'Found volume group "pve" using metadata type lvm2

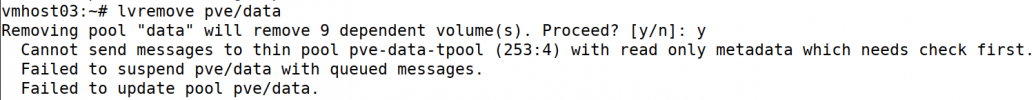

bad checksum in space map bitmap (block 11781)

Check of pool pve/data failed (status:1). Manual repair required!

bad checksum in space map bitmap (block 11781)

bad checksum in space map bitmap (block 11781)

bad checksum in space map bitmap (block 11781)

bad checksum in space map bitmap (block 11781)'

Bin für jede Hilfe echt dankbar...da ich im Moment absolut nicht weiß was ich machen soll.

Vielen Danke schon einmal vor ab..

Eure Foxi

Es läuft hier Proxmox 7.0-8

Ich erhalte bei allen die Meldung

"kvm: -drive file=/dev/pve/vm-307-disk-0,if=none,id=drive-scsi0,discard=on,format=raw,cache=none,aio=io_uring,detect-zeroes=unmap: Could not open '/dev/pve/vm-307-disk-0': No such file or directory

TASK ERROR: start failed: QEMU exited with code 1"

Ich also nachgesehen beide HDDs (2x 4TB) sind vorhanden und zeigen keine Fehler an.

Server neustart !

Hier sehe ich bei Booten

'Found volume group "pve" using metadata type lvm2

bad checksum in space map bitmap (block 11781)

Check of pool pve/data failed (status:1). Manual repair required!

bad checksum in space map bitmap (block 11781)

bad checksum in space map bitmap (block 11781)

bad checksum in space map bitmap (block 11781)

bad checksum in space map bitmap (block 11781)'

Bin für jede Hilfe echt dankbar...da ich im Moment absolut nicht weiß was ich machen soll.

Vielen Danke schon einmal vor ab..

Eure Foxi

Last edited: