Good morning guys,

We usw 2 Proxmox Clusters with about 50 VMs, linux and Windows

They Backup to a PBS, splittet in two datastores.

PBS-Version 2.2-3

We are running Prune and GC.

Here is the GC Protocoll for datastore GHH:

Datastore: GHH01

Task ID: UPID:GHH-PVE04:00000FA8:000012AD:000012AF:6323A060:garbage_collection:GHH01:root@pam:

Index file count: 1284

Removed garbage: 0 B

Removed chunks: 0

Removed bad chunks: 0

Leftover bad chunks: 0

Pending removals: 286.362 GiB (in 170440 chunks)

Original Data usage: 1.822 PiB

On-Disk usage: 38.939 TiB (2.09%)

On-Disk chunks: 15504577

Deduplication Factor: 47.91

And the GC Protocoll for datastore GHW:

Datastore: GHW01

Task ID: UPID:GHW-PBS01:0000166A:0000032B:000000F1:6323B050:garbage_collection:GHW01:root@pam:

Index file count: 369

Removed garbage: 0 B

Removed chunks: 0

Removed bad chunks: 0

Leftover bad chunks: 0

Pending removals: 0 B (in 0 chunks)

Original Data usage: 880.367 TiB

On-Disk usage: 14.379 TiB (1.63%)

On-Disk chunks: 6114822

Deduplication Factor: 61.23

Garbage collection successful.

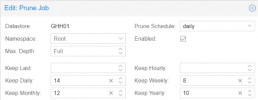

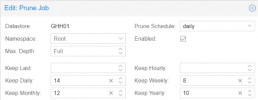

This is our Prune-Job configuration:

Datastore GHW01 is the same Configuration.

The Backups in GHW01 are running for about 1 year now. There 34 versions of each machine.

Most in GHH01 are running for about 6 weeks now.

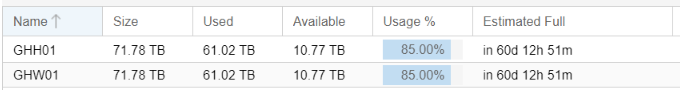

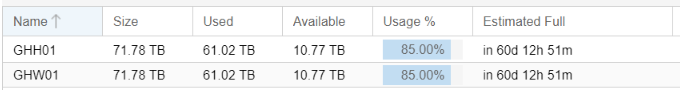

The onDisk Usage over all in Cluster 2 is about 22TB HDD + 6,5TB SSD (28,5TB)

The onDisk Usage over all in Cluster 1 is about 14TB HDD + 1,3TB SSD (15,3TB)

So on Disk it's about 44 TB.

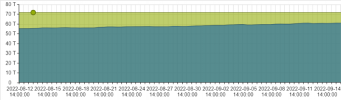

it is continiusly increasing the last month, but GC shoud have cleand up.

So, is it possible, that GC is not cleaning up all chunks?

Thanks for any help

greetz

Frank

We usw 2 Proxmox Clusters with about 50 VMs, linux and Windows

They Backup to a PBS, splittet in two datastores.

PBS-Version 2.2-3

We are running Prune and GC.

Here is the GC Protocoll for datastore GHH:

Datastore: GHH01

Task ID: UPID:GHH-PVE04:00000FA8:000012AD:000012AF:6323A060:garbage_collection:GHH01:root@pam:

Index file count: 1284

Removed garbage: 0 B

Removed chunks: 0

Removed bad chunks: 0

Leftover bad chunks: 0

Pending removals: 286.362 GiB (in 170440 chunks)

Original Data usage: 1.822 PiB

On-Disk usage: 38.939 TiB (2.09%)

On-Disk chunks: 15504577

Deduplication Factor: 47.91

And the GC Protocoll for datastore GHW:

Datastore: GHW01

Task ID: UPID:GHW-PBS01:0000166A:0000032B:000000F1:6323B050:garbage_collection:GHW01:root@pam:

Index file count: 369

Removed garbage: 0 B

Removed chunks: 0

Removed bad chunks: 0

Leftover bad chunks: 0

Pending removals: 0 B (in 0 chunks)

Original Data usage: 880.367 TiB

On-Disk usage: 14.379 TiB (1.63%)

On-Disk chunks: 6114822

Deduplication Factor: 61.23

Garbage collection successful.

This is our Prune-Job configuration:

Datastore GHW01 is the same Configuration.

The Backups in GHW01 are running for about 1 year now. There 34 versions of each machine.

Most in GHH01 are running for about 6 weeks now.

The onDisk Usage over all in Cluster 2 is about 22TB HDD + 6,5TB SSD (28,5TB)

The onDisk Usage over all in Cluster 1 is about 14TB HDD + 1,3TB SSD (15,3TB)

So on Disk it's about 44 TB.

it is continiusly increasing the last month, but GC shoud have cleand up.

So, is it possible, that GC is not cleaning up all chunks?

Thanks for any help

greetz

Frank